ANNEXE 5 : CONTRIBUTION DE

M. PATRICK ALBERT, ENTREPRENEUR ET CHERCHEUR :

RELEVER

DÉMOCRATIQUEMENT

LES DÉFIS DE L'INTELLIGENCE ARTIFICIELLE

Le développement de l'intelligence artificielle, favorisé par une concentration industrielle démarrée à la fin des années 2000, bouleverse nos modes de vie, que ce soit au niveau du travail, de l'enseignement, de la santé ou des relations humaines . Ce bouleversement est tel que chacun, glissant de manière continue vers une dépendance de plus en plus importante aux technologies, produits et services numériques majoritairement importés, peut expérimenter les bénéfices des services de l'intelligence artificielle. Ce développement a connu trois vagues industrielles successives , entrecoupées par deux « hivers » de l'intelligence artificielle » faits de désillusions. La vague des années 1980 correspond à l'apparition des « systèmes experts », des applications automatisant la connaissance d'un expert spécialisé dans la réalisation d'une tâche particulière. Cette première vague a vu la création de nombreuses jeunes entreprises dont les services ont permis le développement d'applications intelligentes de diagnostic de pannes ou de contrôle de procédés industriels, par exemple. Cependant, cette avancée technologique ne fut pas assez significative pour permettre à l'intelligence artificielle de connaître une percée industrielle durable. Cette vague fut également marquée par l'utilisation des machines américaines Lisp, du nom du langage informatique standard de développement des algorithmes, et des machines japonaises automatisant la mise en oeuvre du langage PROLOG - pour PROGrammation LOGique - inventé en France par le professeur Alain Colmerauer. Ces machines n'ont pas cependant dépassé le stade de super-prototype, et sont restés trop onéreuses pour déboucher sur des applications industrielles massives. Une autre vague débuta dans les années 2000, après plus d'une décennie « d'hiver ». Au cours de cette période, les technologies issues des systèmes experts ont connu des progrès considérables, améliorant leur performance et surtout simplifiant à l'extrême leur mise en oeuvre par des non-informaticiens. La technologie s'est focalisée sur la simplification extrême de l'automatisation de décisions simples , telles que la décision d'allocation d'un prêt, l'application d'un programme de fidélisation client, ou encore l'évaluation de la conformité à une norme. Cette deuxième vague de l'intelligence artificielle est celle de l'automatisation des règles métiers. Ces systèmes permettent au spécialiste d'un métier de transférer à la machine les règles que lui-même met en oeuvre en programmant des applications de décisions. Ce procédé se répandit dans de nombreux secteurs, en tout premier lieu dans celui des banques et des assurances.

Les données sont généralement considérées comme l' or noir d'Internet ; c'est également le cas de l'intelligence artificielle, qui se nourrit des milliards de données fournies en quantité croissante et à un coût marginal. C'est dans ce contexte que la dernière vague de l'IA, dans la période actuelle, émerge, grâce à l'articulation des progrès spectaculaires de la recherche fondamentale ayant perfectionné les premières méthodes d'apprentissage avec la massification des données et l'apparition de calculateurs spécialisés à très bas coût, les processeurs graphiques (GPU) 44 ( * ) . Ces puces GPU rencontrent une demande forte, près de 500 millions d'unités ayant été vendues au cours de l'année 2014 ; elles servent à appliquer des traitements très simples mais simultanément à une grande quantité de données. Intel a ainsi perdu sa position dominante en faveur de nouveaux fabricants de microprocesseurs, tel que Nvidia.

À l'instar de l'informatique qui lui sert de moteur, l'intelligence artificielle est une technologie horizontale , elle peut servir « à tout ». Elle fournit aux applications informatiques la capacité de résoudre des problèmes complexes. Elle permet à des machines de percevoir et de décider pour automatiser des tâches jusqu'ici entièrement réalisées par des humains, ou pour effectuer des activités nouvelles - par exemple les jeux vidéo, ou comme dans le cas de la réalité virtuelle, inventer des mondes dignes de la science-fiction et abuser nos sens pour nous faire croire à leur réalité.

Les intelligences artificielles sont le plus souvent sans mémoire, ou plus précisément, sans autre mémoire que celle - limitée mais parfaite - qui est indispensable pour mener à bien la tâche à laquelle elles sont dédiées. Car elles fonctionnent encore en silos, chacune d'entre elles automatise une tâche très spécifique. Une IA est totalement incompétente en dehors de « sa » tâche et impossible à connecter utilement à des IA développées, pour d'autres besoins dans d'autres contextes. Il existe des langages généralistes de communication inter-agents, mais ils en sont restés au stade de l'expérience de laboratoire. Un langage universel pour les agents du web se développe toutefois depuis l'année 2007. Ce qu'on appelle le « web sémantique » est une initiative d'envergure mondiale portée par Tim Berners-Lee, l'inventeur du web , qui vise à donner aux agents intelligents la capacité de représenter le monde et de le comprendre ; de lui donner du sens. Les langages RDF et OWL 45 ( * ) sont ainsi la synthèse de deux décennies de recherche sur les langages de représentation des connaissances, ils fournissent aux agents du web un moyen de communication universel indépendant des langages humains - une sorte d'Esperanto 46 ( * ) pour agents intelligents.

On peut séparer trois grandes classes d'activités « intelligentes » : la perception et l'expression - voir, entendre, parler, etc. - les décisions dites de routine, où l'on applique une connaissance simple, une règlementation, une « politique » prédéfinie, et les décisions d'optimisation où l'on cherche à obtenir la meilleure solution à un problème de gestion de ressources limitées et contraintes.

Les décisions d'optimisation sont automatisées grâce à leur formalisation dans des modèles mathématiques 47 ( * ) par des spécialistes ou par des programmes développés par des experts. Après le secteur de la défense , ce sont trois industries par natures globalisées qui ont embrayé le pas : les transports, les télécom et la finance . En effet, la logistique , le transport aérien, routier ou ferroviaire ne fonctionnent que grâce à ces agents artificiels qui sélectionnent les transporteurs, calculent leur trajet optimal, décident du chargement des soutes, du camion ou des wagons et planifient la séquence d'actions à mettre en oeuvre pour le réaliser. Plus encore, ils sélectionnent le conducteur ou le pilote, ou encore l'ensemble de l'équipage d'un avion, en respectant les conditions de sécurités, les lois et réglementation et les accords syndicaux tout en optimisant le coût financier ou social. Uber et ses algorithmes, ou encore la voiture robot reléguant le chauffeur au rôle de passager, ne sont que la partie émergée exposée au grand public d'un iceberg dont la profondeur ne cesse de s'accroitre. Bien entendu les algorithmes d'optimisation calculent le prix optimal 48 ( * ) et le font varier au cours du temps, prenant éventuellement en compte les visites successives de l'internaute repéré sur le site de la compagnie.

L'automatisation des services du web - disponibles partout et à tout instant - est une nécessité absolue: quelle est la bonne page à référencer pour Google ou Yahoo ? Que contiennent les photos des murs Facebook ? Ou encore quelles sont les compétences et les souhaits de carrière des personnes connectées au réseau professionnel Linkedin ? Est-on susceptible de recevoir une allocation ? Quelle est la réduction - ou le « cadeau » - à proposer pour déclencher le passage à l'acte de l'acheteur qui hésite ? Peut-on allouer ce crédit et à quel taux ? Quel accessoire est disponible sur cette voiture, à quel prix et avec quels délais de livraison ? La réponse doit être calculée en une fraction de seconde et présentée immédiatement ; seule une machine peut le faire. La logique qui pousse les grands acteurs du web vers l'intelligence artificielle, dans une compétition féroce pour la construction de monopoles mondiaux , intensifie et accélère ce mouvement. Les plus rapides gagneront la compétition. Le message est bien résumé par Andrew Ng, quittant Google en 2014 pour devenir directeur scientifique de Baidu, le géant de l'Internet Chinois « Qui gagnera l'intelligence artificielle gagnera l'Internet, en Chine et autour de la planète ! » 49 ( * ) .

L' Uberisation caractérise une évolution majeure de la fourniture de services. Des plateformes « biface » portées par le web et également accessibles au moyen de smartphones mettent en contact des clients avec des fournisseurs et gèrent le contrat de service qu'ils peuvent passer entre eux. Elles conçoivent et formalisent un service dont elles garantissent la qualité et prennent à leur charge le paiement ainsi que la gestion des inévitables conflits entre fournisseurs et clients. La première génération de plateformes apparue au début des années 2000 est celle des « places de marché en ligne », qui ne fournissent que la mise en relation avec généralement une ébauche de mesure de « confiance ». Ces places de marché se sont généralisées à de très nombreux domaines et avec trois variantes en fonction du type de populations connectées : B2B pour les services inter-entreprises, B2C pour connecter des professionnels aux particuliers ou C2C pour la mise en contact directe de particuliers entre eux. Le plus bel exemple de ces dernières en France étant « Le bon coin » qui fluidifie la circulation quotidienne d`objets et de services entre plus de deux millions six-cent mille particuliers. La simplification à l'extrême de l'accès au service grâce aux efforts combinés sur les plans du marketing et du design, ainsi que la prise en charge des aspects juridiques et du paiement ont donné naissance à la nouvelle génération des plateformes et à leur succès fulgurant. Blablacar en France en est le meilleur exemple. Selon les services, la garantie de confiance peut prendre différentes formes, mais on la retrouve le plus souvent incarnée sous la forme d'un bouquet de garanties telles que le contrat prédéfini, le paiement sécurisé, la sécurité du service, les assurances et la gestion des différends, et bien sûr la « réputation » du fournisseur.

Bénéficiant des dernières avancées technologiques, le service fourni est généralement beaucoup plus simple, de meilleure qualité et moins cher. On a donc expliqué que le web est un outil de désintermédiation . C'est une fausse approximation : les plateformes sont des outils d' automédiation , elles automatisent l'intermédiation qui est loin d'avoir disparue. Cette intermédiation, qui met en contact l'offre et la demande n'a pas été dissoute par quelque magie du web , elle a été simplement automatisée, ce sont des algorithmes d'intelligence artificielle animés par des machines qui font le lien. Les sociétés telles que Uber ou AirBnB pour ne citer que les plus emblématiques de ce mouvement de fond, sont les nouveaux intermédiaires, les successeurs des courtiers.

Tout comme il y a deux siècles lorsque les premières manufactures industrialisaient la production - en l'occurrence des draps -, les premières grandes plateformes du web inaugurent le mouvement de l'industrialisation du service et du courtage. Ni AirBnB, qui revendique plus de 2 millions de logements dans 34 000 villes à travers le monde, ni Booking.com ne possèdent de logements, et Uber ne possède pas plus de taxis que Blablacar n'a de voiture. Ces plateformes automatisent la mise en en relation de l'offre et de la demande. Elles fournissent les garanties suffisantes pour que des personnes se fassent suffisamment confiance pour entrer dans une relation contractuelle, à distance et sans se connaitre. C'est ce « magic-mix » qui fait le succès mondial et fulgurant des plateformes. Et lorsque l'automatisation du service lui-même est possible, nous verrons très probablement les plateformes le fournir directement, sans autre intermédiaire. Ainsi la trajectoire d'Uber est de remplacer une partie de ses conducteurs par des voitures autonomes 50 ( * ) . C'est un fait encore peu perçu, mais c'est bien l'intelligence artificielle qui est le moteur de cette industrialisation du service que le web et les mobiles ont rendue possible . Les conducteurs des voitures de tourisme avec chauffeur (VTC) mobilisés par Uber ne sont pas des professionnels du taxi, ils ne connaissent pas le détail des villes au sein desquelles ils transportent leurs clients. Le conducteur Uber est littéralement « piloté » par l'intelligence artificielle qui calcule le « meilleur » trajet 51 ( * ) . Cette automatisation du calcul du trajet, qui est le coeur du métier, garantit le meilleur service et permet à des personnes non qualifiées de devenir chauffeurs de taxi ; elles n'ont qu'à suivre les ordres de la machine. On peut poursuivre l'exemple avec la fixation du prix de la course qui est défini dynamiquement en fonction du contexte. Cette méthode de fixation du prix est un sujet classique de l'intelligence artificielle, celui du yield management dont le but est de maximiser le chiffre d'affaire ou le profit tiré d'une capacité par un pilotage fin de son prix de vente. En changeant radicalement de domaine, on pourrait facilement faire la même démonstration pour l'uberisation naissante des métiers du droit par les plateformes naissantes des « Legaltech 52 ( * ) ». Ces plateformes proposent de mettre en contact un client et son avocat, si nécessaire, tout en automatisant à marche forcée le traitement des cas les plus simples ou les plus fréquents. Les techniques seront différentes, par exemple la compréhension du langage naturel ou l'utilisation de robots conversationnels, mais à terme l'effet sera certainement le même.

L'intelligence artificielle se déploie grâce à l'exécution de logiciels spécialisés sur des machines. Ce déploiement se produit le plus souvent dans le cloud , sur nos machines de bureau ou à la maison, et de façon croissante sur les mobiles 53 ( * ) .

Mais c'est sans conteste « silencieusement » que l'IA se déploie le plus, hors de notre perception sensible.

Les industries soumises à une compétition internationale largement dérégulée, donc très aigüe, ont dû lutter pour diminuer leurs coûts et améliorer les décisions. In fine elles ont dû confier à des algorithmes intelligents le calcul des solutions optimales à nombre de leurs problèmes opérationnels. Les industries aéronautiques - compagnies d'aviation et aéroports - et la téléphonie fixe ou mobile ont été pionniers dans la mise en oeuvre des technologies de l'intelligence artificielle et de sa cousine jusqu'ici plus discrète, la recherche opérationnelle 54 ( * ) . Toutefois, de nombreuses industries sont maintenant équipées de logiciels intelligents et ce nombre ne fait que croître. L'éditeur de logiciels ILOG, fleuron de l'IA française, vendu à IBM fin 2009, a revendiqué près de trois mille clients : 2 500 entreprises et plus de 465 éditeurs de logiciels. Un impact énorme sur de très nombreuses applications.

Outre le commerce en ligne, déjà évoqué plus haut, il faut bien sûr citer les banques et la finance . Le cadre féroce de leurs opérations, mondial et dérégulé, et les objets manipulés - essentiellement immatériels - se prêtent à la perfection au monde de l'automatisation. Le cas particulier du « Trading Haute Fréquence » est plus que parlant : seuls des robots peuvent entrer dans la compétition car la vitesse de décision est telle qu'aucun humain ne peut combattre. Le trading algorithmique représente maintenant près de la moitié des transactions financières mondiales, le golden boy contemporain est en pur silicone.

Les assurances ont (un peu) tardé à s'y mettre car la compétition n'a pas la nature aigüe de la finance. Mais surfant sur la capacité prédictive apportée par les big data et par la connaissance individuelle fournie par les capteurs toujours plus nombreux qui nous environnent, les assurances se mettent à l'IA et la course à l'automatisation n'en est qu'à son début. L'intelligence artificielle sera le moteur d'une hyper-individualisation de la gestion du risque assuranciel rendue possible par la combinaison d'une catégorisation des comportements individuels, issue de l'analyse temps-réel des données du web et de l'Internet des Objets, avec les modèles prédictifs du big data .

Toujours dans le domaine de l'immatériel, les réseaux sociaux tels que Facebook utilisent l'intelligence artificielle pour étiqueter les photos publiées 55 ( * ) ou encore contrôler et définir le flux d'information et l'ordre dans lequel il est présenté. De fait Facebook devient un éditeur qui sélectionne et ordonne les informations soumises à ses clients. Son algorithme fait l'office du rédacteur en chef d'un quotidien unique à chaque lecteur dont il aurait une connaissance intime. De son côté, la presse traditionnelle passe en ligne, et mobilise l'intelligence artificielle pour sélectionner des informations pertinentes et rédiger les articles les plus simples. La vitesse de réaction/rédaction est encore ici un atout essentiel.

L'agriculture dite « de précision » qui est alimentée par les données GPS et satellitaires 56 ( * ) est elle aussi pilotée par intelligence artificielle. Planification et ordonnancement des travaux à réaliser dans les champs, réalisation de plus en plus automatisée de ces travaux, et jusqu'au choix des qualités et quantités d'engrais à déposer sur chaque m 2 d'un champ par analyse des photos satellitaires.

En s'automatisant la médecine produit des traitements intégrant les progrès les plus récents de la connaissance médicale et adaptés au plus près de chaque patient. De son côté, la pharmacie peut vérifier la compatibilité des médicaments prescrits tout en s'assurant de la validité des doses. La médecine devient préventive en confrontant les données issues de nos capteurs à des modèles prédictifs découverts grâce à l'analyse des masses de données récoltées sur les cohortes, tout en diminuant le coût d'interprétation des prélèvements et examens dont l'interprétation est partiellement ou totalement automatisée. Les assurances vont aussi être des acteurs majeurs de la poussée vers plus de prévention et de personnalisation.

L'automatisation du marketing et la publicité, on l'a vu, rapprochent le client et le vendeur, en personnalisant l'interaction, diminuant la quantité de publicité hors sujet à laquelle nous sommes exposés et rapprochant l'offre de nos besoin perçus. C'est sur ce domaine d'application qu'est né le big data (si on enlève les logiciels réalisés par les géants américains pour les besoins de la NSA). La quantité de publicité contenue dans les pages web a vite posé le problème de sa pertinence. Les internautes ont massivement rejeté le tsunami de la e-pub, et la lutte est maintenant ouverte entre les sites « gratuits » financés par la publicité et les ad-blockers qui suppriment les publicités. La tentative de compromis en cours entre le public et les publicitaires s'articule autour d'un concept de smart-pub ; une publicité intéressante et pertinente. Les algorithmes d'apprentissage que nous nourrissons de nos traces sur l'Internet servent à caractériser l'internaute et sont le garant de la pertinence. L'enjeu est de taille car c'est le modèle du web « gratuit » 57 ( * ) qui est mobilisé.

Le monde des loisirs n'est pas en reste, en particulier l'univers des jeux qui a été l'un des premiers, avec les militaires , à investir sérieusement le potentiel de l'intelligence artificielle. Les jeux à deux joueurs se sont très tôt avérés prêter un terrain d'expérimentation presque idéal aux techniques de l'IA. Leur univers extrêmement simple régi par un petit corpus de règles et doté d'une mesure de succès objective leur ont permis de servir de benchmark tout autant que de canal de communication avec le grand public. On sait l'écho qu'ont successivement rencontré la victoire aux échecs de Deep Blue contre Kasparov en 1997, la victoire au Jeu Jeopardy 58 ( * ) par IBM en 2011, à l'occasion de son 100 e anniversaire, puis enfin , en mars 2016, la victoire très largement commentée au jeu de Go d'AlphaGo, l'IA de la start-up anglaise achetée par Google, DeepMind. Les jeux vidéo ne sont pas en reste et utilisent de l'intelligence artificielle depuis plus d'une décennie en accumulant une expérience unique relative à l'importance critique du réglage de l'autonomie de leurs IA : pas assez d'autonomie et c'est l'ennui, mais trop d'autonomie et le jeu, donc le Gameplay 59 ( * ) , devient imprédictible.

La réalité virtuelle peut être la prochaine industrie grosse consommatrice d'intelligence artificielle, car pour être intéressant un univers doit être doté d'un comportement intelligent donc être animé par des IA.

La musique est aussi concernée 60 ( * ) , on peut citer deux exemples de réussites françaises : l'algorithme de flow de Deezer qui enchaine un flux ininterrompu de musiques « qu'on aime » 61 ( * ) ou encore l'excellent générateur de mélodies pop 62 ( * ) créé au sein du laboratoire parisien de Sony Research.

La peinture n'échappe pas à cette logique : on connaissait déjà les effets graphiques utilisés pour pimenter ou simplement améliorer les millions de « selfies » des utilisateurs de Facebook. On peut maintenant faire réinterpréter ses photos « dans le style de ». La jeune pousse russe Prisma propose par exemple d'appliquer le style Van Gogh ou Picasso à de simples photos 63 ( * ) . Plus intéressant, en avril 2016 la chaine de télévision Arte a créé en direct un « nouveau Rembrandt 64 ( * ) » qui a véritablement épaté, entre autres, une équipe de professionnelles expertes de la restauration de tableaux anciens. Il ne s'agit plus seulement d'appliquer un style à une composition picturale déjà faite, produite par un appareil photo, mais de créer véritablement une oeuvre originale. Avec son projet Magenta 65 ( * ) , la firme Google, toujours à la recherche de support médiatique s'est emparée milieu 2016 du sujet de la création graphique. Un premier projet d'art visuel avait suscité un certain écho. DeepDream 66 ( * ) produit des représentations graphiques dans des styles si bizarres qu'on pourrait les croire sorties d'un rêve 67 ( * ) .

Les robots connaissent aussi un essor spectaculaire et leur aspect frappe l'imagination : notre tendance à « humaniser » les animaux ou les objets nous incite à intégrer les robots comme une nouvelle espèce « bizarre » qui se développe sous nos yeux produisant parfois un mélange ambigu d'attirance et de peur. Les robots sociaux tels Nao ou Pepper de la société Aldebaran sont conçus pour susciter de l'empathie, et les résultats les plus avancés des neurosciences et de la sociologie sont utilisés pour produire des objets « attachants », des compagnons obéissants fournissant par exemple aux personnes âgées des services de proximités.

L'utilisation d'outils et si possible l'automatisation du travail est consubstantielle à l'histoire de l'humanité : il y a quelques 25 siècles Aristote écrivait 68 ( * ) : « Si les navettes tissaient toutes seules, si l'archet jouait seul de la cithare, alors les entrepreneurs se passeraient d'ouvriers, et les maîtres, d'esclaves ». L'histoire de la relation entre travail, humains et robots, est riche de plusieurs évolutions motivées en premier lieu par la production de masse et le taylorisme. Mais le robot universel reste à inventer. Un robot automatise une tâche particulière. Il est bien plus facile d'automatiser une tâche que l'on aura au préalable simplifiée. Ce n'est pas par hasard que le tout premier robot industriel, Unimate , a été mis en oeuvre en 1961 sur des lignes d'assemblage, celles de Général Motors. Avec son bras articulé d'une tonne et demi, ce robot transportait des pièces de fonte de 150 kilogrammes pour les souder sur la carrosserie des voitures en cours d'assemblage. Une tâche ingrate et dangereuse à cause du poids des pièces et des fumées toxiques, mais une tâche extrêmement simple. L'emblématique société Amazon montre la voie du futur 69 ( * ) : dans une première étape les magasiniers ont été asservis à la machine, travaillant dans le cadre d'une méthode de stockage, connue sous le nom de « Chaotic Storage », conçue par et pour des IA, et uniquement compréhensible par les machines qui les pilotent. Puis dans un deuxième temps, l'entreprise pousse l'automatisation un cran plus loin en déployant des robots en nombre. Ce sont plus de 30 000 robots qui oeuvrent aux cotés des humains pour poursuivre l'automatisation du processus de livraison. Plus loin encore, la promesse du digital manufacturing tel que développée par exemple en France par la société Dassault Systemes 70 ( * ) vise à terme à passer quasi automatiquement de la conception d'un nouveau produit à la « production » de l'usine qui le produira.

Les GAFA veulent mener la danse et disposent d'atouts extraordinaires. Ils génèrent l'équivalent du PIB du Danemark , la 25 e puissance économique mondiale et sont conçus pour la croissance (de l'ordre de 33 %) et la profitabilité (avec un taux d'imposition de l'ordre de 5 %). Seule la Chine à ce jour a su résister et créer une industrie concurrente crédible, mais leur surface va de l'Internet et du web jusqu'à la santé, les médias et le divertissement ou encore la distribution et la finance. Ils capturent plus de deux milliards d'utilisateurs et plus de 50 % du temps en ligne est passé sur leurs plateformes . Leur visée est hégémonique , la mise en place de monopoles mondiaux, et ils sont activement soutenus dans cette démarche par le gouvernement et l'armée des États-Unis.

Derrière un discours de type ONG les extensions de l'Internet que leurs « fondations » mettent en place semblent viser à étendre leur marché -on dit le « reach » - et à permettre aux pays en voie de développement d'accéder à l'Internet. À tel point que le peuple indien s'en est ému. Il s'est particulièrement offusqué de l'initiative « Internet.org », promue par un consortium essentiellement américain piloté par Facebook, au titre d'une violation de la « neutralité du net ».

L'année 2016 aura vu la concrétisation d'un mouvement profond et décisif de reconfiguration des GAFA autour de l'intelligence artificielle , après que les années 2000 aient été le moment des expériences et de la consolidation des technologies. Parti de deux projets d'IA en 2011, et après une douzaine d'acquisitions de start-up spécialisées sur le domaine, Google évoque, par exemple, fin 2016 plus de 1000 projets d'intelligence artificielle en cours.

En France, les talents sont nombreux, y compris au sein du monde académique 71 ( * ) et l'entrepreneuriat ne s'est jamais aussi bien porté. Ainsi, coté start-up , le dynamisme de la FrenchTech s'avère très efficace 72 ( * ) . Cependant la communauté scientifique de l'IA est morcelée en sous-communautés n'atteignant pas la taille critique qui leur permettrait d'être visibles, il existe peu d'écoles ou d'universités proposant des cursus solides dédiés à l'intelligence artificielle et, enfin, la rémunération des jeunes chercheurs est plus que modeste. Les start-up grouillent, mais comme le résume d'une formule choc Kevin Kelly le fondateur de Wired, les 10 000 prochaines start-up mettront de l'IA dans leur « marketing mix » 73 ( * ) et il s'agira d'être convainquant. Faire un peu de big data ou d'analyse factorielle ne suffira pas, l'engagement doit être total au risque d'être balayé par des entreprises adossées à une R&D solide. Reste enfin à voir si les dirigeants et les investisseurs vendront les start-up aux GAFA après les premiers succès ou sauront transformer les PME en ETI puis les ETI en groupes mondiaux à même d'entraîner dans leur sillon un large écosystème de chercheurs et de start-up innovantes.

L'Europe est un formidable atout qu'il faut utiliser, mais cela passe par une approche informée des difficultés inhérentes à sa complexité mais aussi par la création préalable d'une communauté nationale forte et consciente d'elle-même : on ne peut sous-traiter la souveraineté scientifique nationale aux institutions européennes.

Il n'y a pas encore de cadre réglementaire ou juridique spécifique à l'intelligence artificielle et le déploiement de la technologie avance à un rythme peut-être peu compatible avec celui du législateur. Mais il est ou sera nécessaire d'étendre la régulation aux problèmes posés, qui sont nombreux et parfois critiques : déterminer ce qui peut ou ne peut pas se faire, qui endosse les responsabilités et quelles seront les éventuelles sanctions. Au-delà de la simple régulation, on peut se poser la question de l'utile et s'interroger sur ce qui est bon, ce qui est plus difficile et probablement moins consensuel. Y-a-t-il une limite à fixer à l'automatisation du travail ou à la gestion de notre santé et plus généralement de nos existences ? La relation entre l'homme et la machine, la tendance de la technologie à s'auto-engendrer et à englober toujours plus de pans de nos existences ont été jusqu'ici des sujets plutôt marginaux. Ces sujets ont toutefois été pensés et travaillés par un petit nombre de philosophes alertant le plus souvent sur les dangers et les charmes hypnotiques du confort apporté par une automatisation toujours plus poussée. Selon Satya Nadella, P-DG de Microsoft :

• L'intelligence artificielle doit être conçue pour assister l'Humanité. Construire des robots se chargeant des tâches dangereuses protègerait ainsi les travailleurs humains.

• L'IA doit être transparente. Les principes et règles des algorithmes doivent être explicites et compréhensibles par chacun : le design doit fonctionner de pair avec l'éthique.

• Les algorithmes d'IA doivent être auditables pour les modifier au besoin.

• L'IA doit favoriser l'efficacité sans que cela ne se fasse au détriment de la dignité humaine. Ce qui demande l'implication d'équipes de conception reflétant du mieux possible la diversité culturelle et nécessitant la participation de tous. Le secteur technologique ne doit pas imposer les valeurs du futur.

• L'IA doit éviter tout biais pour ne pas favoriser les discriminations.

• L'IA doit être conçue de manière à protéger la vie privée des utilisateurs.

Il faudra également, en tout état de cause, résister au mythe de la nécessaire objectivité des processus automatisés lorsqu'on sait qu'il sont conçus par le tandem bien humain et très subjectif de l'informaticien et du marketeur, fermement aiguillonnés dans les coulisses par leurs investisseurs. Il faudra donc veiller à conserver, et plus probablement à renforcer, le rôle du politique, du débat public et de la délibération démocratique dans la gestion des affaires technologiques aussi bien qu'humaines.

On ne peut pas traiter de l'intelligence artificielle aux États-Unis - ni ailleurs... - sans faire un bref détour par la Silicon Valley . Ce nom est devenu « générique » et un peu magique. C'est comme un label que l'on appose pour garantir la présence d'une certaine culture vouée à l'innovation. On peut bien sûr retrouver cette culture dans d'autres grands centres américains comme à Boston sur la côte Est, autour du M.I.T. et de Harvard ou encore à Pittsburg, autour de l'université Carnegie Mellon, un haut lieu de la robotique intelligente. New York aussi à sa « Silicon Alley » qui revendiquait plus de sept milliards de dollars d'investissement en 2015. D'autres pays à leur tour tentent de créer leur « Valley », le plus souvent singeant l'original plutôt que d'en capturer et d'en acclimater l'esprit. Mais la Silicon Valley reste quelque chose d'unique : le retour en force de « l'esprit des pionniers ». Faute de nouvelle terre à conquérir, la conquête de l'Ouest par les colons européens a dû s'arrêter au bord du Pacifique, les laissant sur leur faim. Et de même, la folle ruée vers l'or de 1848, une fois les mines vidées et les rivières asséchées a dû finalement s'éteindre en 1856. Cette ruée vers l'or a créé la Californie, décimant les Indiens et attirant vers l'ouest près de trois cent mille personnes issues de tous pays. Elle a marqué durablement l'imaginaire californien . L'esprit de conquête, une soif d'aventure et l'espoir d'une fortune rapide dans un pays dont même les lois étaient encore à inventer. Ce nouveau mythe a déplacé le mythe américain inaugural, celui du fermier travaillant dur son modeste lopin de terre, nourrissant sa famille et servant pieusement Dieu et sa communauté. Mais ce nouvel esprit aventurier est resté brûlant, telle une braise sous la cendre, prêt à être remobilisé. Un peu plus d'un siècle plus tard, la Californie repart à l'attaque ; le silicone a cette fois remplacé l'or, et la ruée a recommencé. L'avènement du monde virtuel de l'Internet suivi de celui du web a servi de nouveau « nouveau monde » pour réactiver l'imaginaire pionnier. Et la Silicon Valley attire à nouveau les aventuriers de tous pays, d'Europe bien sûr mais aussi nombreux sont les Indiens et les Chinois 74 ( * ) , et ce nouveau monde de surcroît est beaucoup plus accueillant . Vraiment inhabité, personne à tuer pour occuper ou conserver les territoires, et illimité : dans le monde de l'Internet, la place est infinie , il suffit d'incrémenter un numéro pour y planter son ranch, et dans celui du web il suffit d'en inventer le nom pour créer son territoire. Par contre, revers de la médaille, le territoire nouveau est nu, il y fait nuit et il est inconnu de tous. Dans ce nouveau monde, c'est le diplôme du PhD, le doctorat en informatique, ou le master en marketing qui sert de passeport. Et si la capacité à travailler énormément reste nécessaire, l'esprit innovation est maintenant au pays du silicone ce qu'était le tamis des orpailleurs d'antan.

La Silicon Valley dispose enfin d'un atout qui pour être soft n'en est pas moins décisif, elle a parfaitement compris les quatre moteurs à la base de la révolution numérique :

1. L'informatisation d'une activité peut totalement la redéfinir, rebattre les cartes et in fine restructurer l'écosystème industriel qui la portait.

2. Un informaticien est un artisan 75 ( * ) - tel un chirurgien - pas l'ouvrier anonyme d'une « usine à logiciel » comme on a voulu le faire croire en France par exemple. Ce sont des développeuses et des développeurs, celles et ceux qui inventent et écrivent le code des algorithmes, et non pas des « programmateurs » comme on le lit souvent.

3. L'enjeu du web est la création de monopoles mondiaux .

4. On peut ne pas respecter les lois . Et si l'on a suffisamment d'argent, de cynisme et d'intimité avec la classe politique, on peut les changer.

À ce titre, l'industrie des plateformes est une illustration criante. Grâce à une maîtrise à la fine pointe de l'informatique et de l'intelligence artificielle elle peut révolutionner des industries aussi stables que l'hôtellerie ou le transport de personnes, les industrialisant de l'extérieur et capturant au passage une marge exorbitante.

Dans le cadre de l'utilisation de l'intelligence artificielle pour le bien de l'humanité, on voit donc que les logiciels libres - l' Open Source - peuvent être un paravent nécessaire, et peut-être efficace, contre la confiscation des algorithmes par une petite minorité de propriétaires. Au-delà des affichages philanthropiques et des proclamations bienveillantes, la réponse des logiciels libres est aussi un très bon moyen d' attirer les meilleurs développeurs , qui y trouvent un environnement au sein duquel ils peuvent travailler librement avec leurs pairs, communiquer leurs résultats et faire avancer la science, tout comme au sein d'un laboratoire hébergé par une université. L'approche ouvre également à l'industriel la porte à la mise en place de standards de fait favorables au développement de ceux qui en ont pris l'initiative. Enfin les entreprises à la base de ces systèmes bénéficient gratuitement de toutes les idées et améliorations apportées par les développeurs bénévoles qui expérimentent avec les algorithmes ou qui les étendent. C'est ainsi que l'on a vu les deux géants, Google avec « TensorFlow » puis Facebook avec « Torch », mettre à leur tour une partie de leurs services d'intelligence artificielle en Open Source . IBM a suivi, mais plus modestement, en publiant un standard assez peu utilisé, probablement pour ne pas être de reste et tenter d'afficher un support technique à un discours marketing très offensif sur l'informatique dite « cognitive ». Enfin, dernier en date, c'est au tour du géant chinois Baidu en septembre 2016, de mettre à disposition des développeurs son système « Paddle-Paddle » qui regroupe ses algorithmes de deep learning .

Nous sommes peut-être à l'aube de la quatrième des Grandes Transformations qui ont changé le cours de l'humanité. Ces transformations radicales se sont produites lorsqu'une ressource critique jusqu'alors rare et coûteuse d'accès est devenue tout à la fois abondante et abordable :

• Nourriture : l'agriculture, inventée il y a dix à quinze mille ans, a sonné le départ de la croissance des populations humaines, de l'écriture et des technologies.

• Connaissance : la presse à imprimer, au milieu du quinzième siècle, a créé en Europe les conditions de l'accès à la culture pour tous, donnant naissance à la sortie de l'obscurantisme et à la civilisation de la connaissance qui a pris son envol avec les Lumières.

• Énergie : la machine à vapeur a déclenché au dix-neuvième siècle le mouvement de remplacement du monde des paysans et des artisans par celui du commerce et de l'industrie. Cette domestication de l'énergie a rendu possible la production de masse et la société de quasi abondance dans laquelle se trouvent en particulier les pays occidentaux.

• Données et IA : la quatrième Grande Transformation, dont nous assistons à la naissance, est celle de la donnée, qu'elle soit relative au monde, à nos comportements en ligne ou à ceux captés sur nos existences incarnées. L'information qui était rare, chère, secrète et jalousement protégée, devient surabondante et gratuite. C'est un flux qui se libère, d'aucuns l'appellent un tsunami, mais il est incessant et toujours plus vaste. Ce nouvel or noir est le carburant de l'intelligence artificielle, son omniprésence et sa quasi gratuité signalent probablement l'aube d'une nouvelle ère.

Chacune de ces grandes transitions apportant des progrès considérables a toutefois bouleversé les sociétés qui les ont vues naître les faisant progressivement disparaître pour finalement les remplacer par une nouvelle. Émergeant au sein d'une société particulière, chacune s'est largement imposée aux autres sociétés, parfois naturellement de par les bienfaits qu'elles apportaient, mais le plus souvent grâce à la force supérieure qu'elle conférait, utilisée pour l'imposer . Ces transitions se sont donc souvent accompagnées de misères, de troubles de tous ordres, de guerres civiles ou entre États souvent longues.

Afin de bénéficier des bienfaits apportés par l'intelligence artificielle et d'en gérer les risques au plus près, je propose le développement de trois axes complémentaires :

• Construire une communauté nationale de recherche publique et d'innovation industrielle en intelligence artificielle et robotique coordonnée, consciente d'elle-même et réellement compétitive à l'échelle mondiale.

• Inciter et aider nos entreprises et administrations à mettre en oeuvre ces technologies afin de gagner en efficacité et en compétitivité grâce à l'optimisation des coûts et à l'amélioration de la productivité.

• Anticiper et gérer démocratiquement , en impliquant largement la société civile, les conséquences de l'avènement de l'intelligence artificielle et de la robotique afin d'en maximiser les bénéfices pour tous et d'en maîtriser les risques .

La création d'une « Agence française de l'intelligence artificielle » serait un premier pas nécessaire, permettant de regrouper au sein d'une structure dense, experte et focalisée, le traitement des sujets vitaux dont certains ont été rapidement évoqués plus haut : le développement d'un écosystème national , organisé et ultra-compétitif , à même de se déployer au niveau européen et international, la promotion et la mise en oeuvre de l'IA par nos entreprises et administrations afin de favoriser leur compétitivité, et enfin la compréhension fine des enjeux sociaux et sociétaux pour que le pays bénéficie de promesses de l'IA tout en en maîtrisant les risques. Très probablement le troisième Programme D'investissement d'Avenir en cours de finalisation pourrait être un véhicule propice pour porter et financer une telle activité, tout comme les nouvelles ambitions du Plan Junker pourraient l'accompagner au niveau européen.

* 44 En anglais, Graphics Processing Unit. Ce sont des accélérateurs graphiques conçus pour afficher les images ou les films sur tout type d'écran.

* 45 Ontology Web langage . L'ontologie, introduite par le Grec Aristote veut décrire le langage pour décrire le monde sous la forme d'un ensemble de concepts reliés entre eux.

* 46 Si l'Esperanto est en situation de demi-échec, le succès bien réel de la Langue Internationale des Signes démontre la possibilité d'une langue universelle.

* 47 L'informatique est cousine des mathématiques, et nombre d'informaticiens sont des mathématiciens contrariés. Il n'est pas étonnant que tout comme pour la logique, les mathématiques soient à leur tour mobilisées pour résoudre des problèmes de décision ; les deux approches sont parfaitement complémentaires, les nombres, quasiment divinisés par les Pythagoriciens, ont été chez les philosophes les compagnons de route de la logique. Au fronton de l'Académie de Platon était ainsi écrit « Nul n'entre ici s'il n'est géomètre ».

* 48 Le Yield management qui fixe le prix d'un service en fonction du moment où il est délivré : compagnies d'aviations, hôtels ou encore SNCF.

* 49 « Whoever wins artificial intelligence will win the Internet, in China and around the world ».

* 50 En commençant le 25/10/16 avec la livraison de 50 000 bières par un camion autonome équipé par la start-up Otto.

* 51 Un problème classique d'IA connu sous le nom barbare de « TDTSP » : Time Dependent Travelling Sales Person.

* 52 Les start-up qui appliquent agressivement l'automatisation algorithmique aux problèmes de législations.

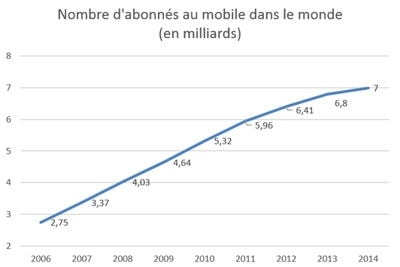

* 53 Sept milliards fin 2014.

* 54 Une annonce de la SNCF qui cherche un « Chef de projet en Intelligence Artificielle » sur le site de la recherche opérationnelle française indique que ces frontières traditionnelles s'émoussent.

* 55 Entre 1 et 1.5 milliard par jour... impossible à faire manuellement.

* 56 Vérifié personnellement par une séance dans le tracteur de l'agriculteur de mon petit village d'Episy dans le Gâtinais. Son intelligence artificielle trace des sillons plus précis que ceux du céréalier.

* 57 Bien résumé par la célèbre phrase : « Quand c'est gratuit c'est que vous êtes le produit. »

* 58 Équivalent américain de “Question pour un champion ».

* 59 Ce qui fait que le jeu reste intéressant, voire addictif.

* 60 En matière de musique, il devient difficile de distinguer un morceau fait par l'humain d'un autre entièrement composé par une machine. Dès les débuts de l'intelligence artificielle la composition musicale était dans la ligne de mire. En particulier les années soixante-dix ont vu la montée en puissance des synthétiseurs faciles à programmer et de la notion MIDI propice à son informatisation. Ray Kurzweil, pour n'en citer qu'un, fut un des pionniers de l'application de l'IA à la composition. Il a conçu dans les années soixante des programmes de composition lui valant la célébrité et de nombreux prix. Plus récemment, en décembre 2016, on a pu écouter le morceau « Daddy's Car » lors d'une grande soirée à la Gaité Lyrique, célébrant les vingt ans du laboratoire IA parisien de Sony. Cette excellente chanson qu'on pourrait dire « des Beatles » si cela n'était qu'elle a été composée par la Flow-Machine, une IA conçue par les chercheurs de Sony et éduquée par apprentissage. Ayant attentivement « écouté » et analysé quarante-cinq chansons des Beatles, l'algorithme a appris le style Beatles.

* 61 Notre usage quotidien de cette IA nous laisse parfois encore impressionné par la qualité des propositions de l'algorithme.

* 62 On peut écouter par exemple l'excellent morceau néo-Beatles Daddy's car sur le site du CSL

* 63 L'application a été bannie de Facebook probablement pour laisser la place libre à un produit interne encore en gestation.

* 64 Voir : https://www.youtube.com/watch?v=IuygOYZ1Ngo

* 65 Pour une présentation en anglais : https://magenta.tensorflow.org/welcome-to-magenta

* 66 L'article de Google : https://research.googleblog.com/2015/06/inceptionism-going-deeper-into-neural.html

* 67 Voir la galerie : https://photos.google.com/share/AF1QipPX0SCl7OzWilt9LnuQliattX4OUCj_8EP65_cTVnBmS1jnYgsGQAieQUc1VQWdgQ?key=aVBxWjhwSzg2RjJWLWRuVFBBZEN1d205bUdEMnhB

* 68 Aristote, La Politique, Livre I, chapitre 2, paragraphe 5.

* 69 “ Amazon Robotics empowers a smarter, faster, more consistent customer experience through automation. Amazon Robotics automates fulfillment center operations using various methods of robotic technology including autonomous mobile robots, sophisticated control software, language perception, power management, computer vision, depth sensing, machine learning, object recognition, and semantic understanding of commands. ”

* 70 Voir http://www.3ds.com/products-services/delmia/disciplines/manufacturing-operations/

* 71 Les institutions en charge de la recherche et de l'innovation son également pour partie en panne ou à la traine. Du côté des grands instituts, il apparait que seul Inria prend vraiment conscience de l'enjeu et compte ses forces. Le CEA semble amorcer le début d'une prise de conscience, mais le CNRS de son côté ne promeut l'intelligence artificielle en première place dans aucune de ses sections.

* 72 En 2016, les entreprises de la Tech française ont atteint un nouveau record en passant le cap des 1,5 milliard de dollars de financement. C'est ce que met en avant le rapport « Tech Funding Trends in France » réalisé par La French Tech et CB Insights.

* 73 “ In fact, the business plans of the next 10 000 start-up are easy to forecast: Take X and add AI” .

* 74 A tel point que lors du recul économique de 2002, les termes consacrés B2B - Business to Business - et B2C - Business to Customer - sont devenus « Back to Bombay » et « Back to China »

* 75 La gestion des employés repose sur un modèle post-industriel où une large part des tâches de surveillance et de contrôle réalisées jusqu'ici par le contremaître ou le petit-chef est réduite ou transférée à des machines émotionnellement neutres. Le management peut alors s'estomper et laisser de la place à l'émergence d'un leadership qui n'est plus basé sur l'autorité - le pouvoir conféré par la position dans l'organigramme - mais sur la compétence technique ou émotionnelle. La structure de commandement qui descend du conseil d'administration vers chaque employé reste très solide bien sûr, mais elle se limite à la transmission des consignes, laissant la place à une certaine auto-organisation quant à leur mise en oeuvre. Les outils informatiques modernes que maîtrise parfaitement la Silicon Valley favorisent une collaboration horizontale, entre pairs, et une poussée vers l'auto-organisation des groupes de projets qui s'accompagne bien sûr d'une plus grande motivation, de meilleurs résultats. L'industrie du logiciel s'inspire en fait largement du mode d'organisation qui a fait l'incroyable succès des communautés scientifiques, tout en y ajoutant la promesse de très fortes rémunérations. Ce mode d'organisation attire les « Smart Creatives » (concept introduit par des entreprises telles que Google et Netflix), dont cette industrie a tant besoin et qui font la différence. En dehors de cette sphère « high tech », dans les industries et services « classiques », celui qui fait est bien souvent nettement moins rémunéré et moins considéré que celui qui commande. Les managers raflent la mise. Le salaire des développeurs vedettes peut dépasser le million de dollars annuel, sans parler de la valorisation des stock-options ou des actions gratuites données à toute personne clé. C'est en particulier un symptôme catastrophique français bien connu qui fait qu'un management préhistorique transforme si souvent d'excellents développeurs en chefs incompétents ou tyranniques.