- LA TACTIQUE TIKTOK : OPACITÉ, ADDICTION

ET OMBRES CHINOISES

- LES RECOMMANDATIONS

DE LA COMMISSION D'ENQUÊTE

- I. UNE STRATÉGIE VISANT À MINIMISER

LES LIENS DE TIKTOK AVEC LA CHINE

- A. LE CONTEXTE : UNE STRATÉGIE

D'INFLUENCE NUMÉRIQUE ASSUMÉE PAR LA CHINE

- B. LE CONTRÔLE EXERCÉ PAR LE PARTI

COMMUNISTE CHINOIS SUR LES GRANDES ENTREPRISES

- C. DES LIENS AVEC LA CHINE QUI PERSISTENT

MALGRÉ LA VOLONTÉ DE PRÉSENTER TIKTOK COMME UNE ENTREPRISE

NON CHINOISE

- 1. Des liens avec la Chine par le biais des

dirigeants de l'entreprise

- a) En France : une SASU dont la présidente

est Mme Zhao Tian, cadre dirigeante de ByteDance qui n'apparaît pas sur

l'organigramme fourni par TikTok

- b) M. Zhang Yiming, fondateur de ByteDance et

« bénéficiaire effectif » de TikTok France

- c) Le rappel à l'ordre du fondateur de

TikTok, son autocritique et son remplacement à la tête de

l'entreprise

- a) En France : une SASU dont la présidente

est Mme Zhao Tian, cadre dirigeante de ByteDance qui n'apparaît pas sur

l'organigramme fourni par TikTok

- 2. La volonté de faire apparaître la

maison-mère de TikTok, ByteDance, comme une entreprise internationale et

non chinoise

- 3. Une séparation fictive entre TikTok et

Douyin

- a) Un changement de nom pour afficher une

séparation entre TikTok et Douyin

- b) L'acquisition d'une « golden

share » par l'État chinois et la revente des parts du

fondateur à des investisseurs fantômes

- c) Des liens évidents entre Douyin et

TikTok

- (1) Des liens au niveau des technologies et de la

propriété intellectuelle

- (a) Des brevets détenus par l'entité

pékinoise de ByteDance

- (b) Des technologies développées en

commun, un algorithme partagé

- (2) Des liens par le biais des transferts de

données

- (3) Des liens qui passent aussi par les

employés de ByteDance en Chine

- (4) Une messagerie Lark partagée par tous

les employés

- a) Un changement de nom pour afficher une

séparation entre TikTok et Douyin

- 4. La présence de membres du Parti

communiste chinois au sein de ByteDance

- 1. Des liens avec la Chine par le biais des

dirigeants de l'entreprise

- D. DES FAITS AVÉRÉS ALTÉRANT

DURABLEMENT LA RÉPUTATION DE TIKTOK ET LA CONFIANCE DE L'OPINION

PUBLIQUE

- E. EN CONCLUSION : DES RISQUES

AVÉRÉS QUI ONT CONDUIT À DE NOMBREUSES DÉCISIONS

D'INTERDICTION OU DE RESTRICTION D'UTILISATION DE TIKTOK

- F. LA SOLUTION PROPOSÉE PAR TIKTOK :

DES PROJETS TEXAS ET CLOVER QUI NE SUFFIRONT PAS À GARANTIR

L'ÉTANCHÉITÉ DE L'APPLICATION VIS-À-VIS DES

AUTORITÉS CHINOISES

- 1. Deux projets qui reposent sur la localisation

géographique des données des utilisateurs

- 2. Deux projets qui ne garantissent pas

l'immunité face aux législations extraterritoriales

- 3. Deux projets qui ne remettent pas en cause la

possibilité d'accéder aux données des utilisateurs depuis

la Chine

- 4. Le « précédent

Huawei » : une première alerte d'ampleur sur les risques

posés pour la sécurité nationale par une entreprise

chinoise mondiale

- a) Une entreprise mondialisée fer de lance

des « routes numériques de la soie » de la Chine

- b) Dans le cadre du développement de la 5G,

une incapacité à convaincre quant à l'absence de risque

pour la sécurité nationale

- c) En conséquence, des mesures

d'interdiction ou de restriction prises en ordre dispersé à

l'échelle mondiale

- a) Une entreprise mondialisée fer de lance

des « routes numériques de la soie » de la Chine

- 1. Deux projets qui reposent sur la localisation

géographique des données des utilisateurs

- A. LE CONTEXTE : UNE STRATÉGIE

D'INFLUENCE NUMÉRIQUE ASSUMÉE PAR LA CHINE

- II. UNE OPACITÉ RELEVÉE AUSSI PAR

LES INSTITUTIONS EN RELATION AVEC TIKTOK EN FRANCE

- III. UNE COLLECTE DE DONNÉES TRÈS

IMPORTANTE, QUI FAIT L'OBJET DE PLAINTES TRAITÉES PAR LA « CNIL

» IRLANDAISE

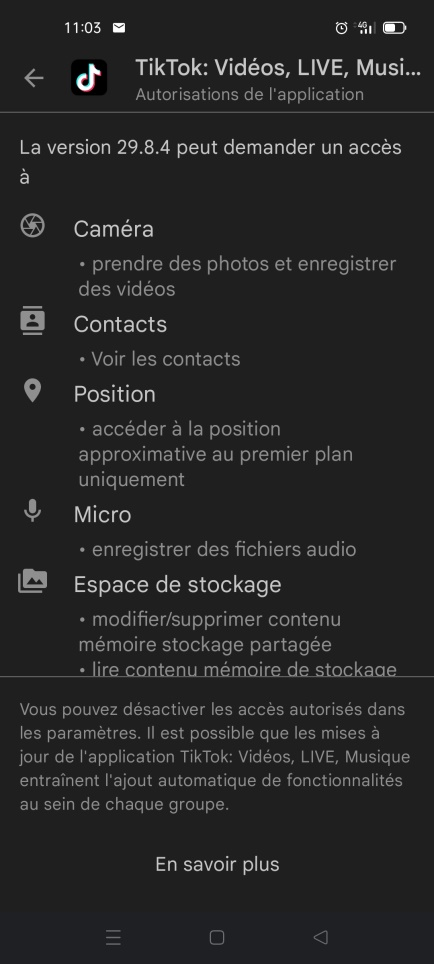

- A. LES SPÉCIFICITÉS DE TIKTOK

EXPLIQUENT UNE COLLECTE DE DONNÉES DANS LE « HAUT DU SPECTRE

» DES APPLICATIONS

- B. UNE COLLECTE QUI A ALERTÉ DE NOMBREUSES

AUTORITÉS DE PROTECTION DES DONNÉES

- C. LES PROCÉDURES EN COURS DE TRAITEMENT

PAR LA DPC, LA « CNIL » IRLANDAISE

- 1. Au moins deux procédures en cours,

relatives aux mineurs et au transfert de données vers la Chine

- 2. Une autorité irlandaise souvent

critiquée pour ses réponses timorées voire pour sa

complaisance vis-à-vis des plateformes

- 3. Des autorités nationales qui essayent de

maintenir une forme de contrôle sur TikTok

- 1. Au moins deux procédures en cours,

relatives aux mineurs et au transfert de données vers la Chine

- A. LES SPÉCIFICITÉS DE TIKTOK

EXPLIQUENT UNE COLLECTE DE DONNÉES DANS LE « HAUT DU SPECTRE

» DES APPLICATIONS

- IV. UN ALGORITHME DE RECOMMANDATION TRÈS

PERFORMANT MAIS OPAQUE

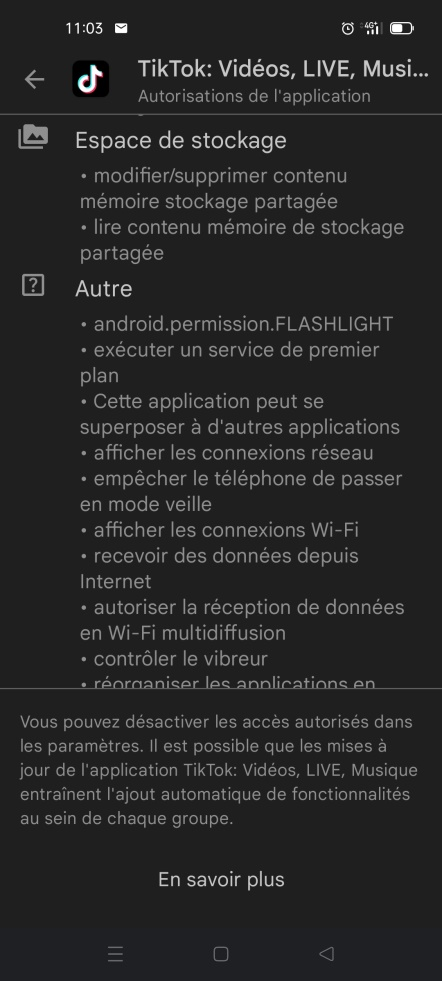

- V. DES RÉSULTATS ENCORE TRÈS

INSUFFISANTS SUR LA LUTTE CONTRE LA DÉSINFORMATION

- VI. DES EFFETS PSYCHOLOGIQUES ET SANITAIRES

À NE PAS SOUS-ESTIMER

- A. « ADDICTION » ? «

ABRUTISSEMENT » ? : UNE « RADICALISATION » DES

EFFETS DES PLATEFORMES NUMÉRIQUES

- B. DES CONTENUS DANGEREUX OU INAPPROPRIÉS

POUSSÉS PAR L'ALGORITHME

- C. DES MESURES PRISES PAR TIKTOK D'UNE

EFFICACITÉ INCERTAINE OU CONTOURNÉES PAR LES UTILISATEURS

- A. « ADDICTION » ? «

ABRUTISSEMENT » ? : UNE « RADICALISATION » DES

EFFETS DES PLATEFORMES NUMÉRIQUES

- VII. LES RECOMMANDATIONS DE LA COMMISSION

D'ENQUÊTE

- A. ÉLARGIR L'INTERDICTION DE L'APPLICATION

DÉJÀ DÉCIDÉE POUR LES FONCTIONNAIRES AUX

OPÉRATEURS D'IMPORTANCE VITALE (OVI)

- B. ACCORDER À TIKTOK JUSQU'AU 1ER JANVIER

2024 POUR SE METTRE EN CONFORMITÉ AVEC SES OBLIGATIONS ET SE MONTRER

COOPÉRATIF VIS-À-VIS DES AUTORITÉS

- C. EXIGER UNE CLARIFICATION DE LA SITUATION

JURIDIQUE DE TIKTOK VIS-A-VIS DE LA CHINE

- D. ENCADRER LES ALGORITHMES DE RECOMMANDATION ET

DE MODÉRATION

- E. ALLER PLUS LOIN : REPENSER LA

RESPONSABILITÉ DES PLATEFORMES QUI ÉDITORIALISENT LEURS CONTENUS

ET MIEUX LUTTER CONTRE LES FAUSSES INFORMATIONS

- F. MOBILISER LE MONDE ACADÉMIQUE POUR

EVALUER LES MESURES PRISES PAR TIKTOK ET DETERMINER SCENTIFIQUEMENT SES EFFETS

PSYCHOLOGIQUES, PRENDRE DES MESURES EN CAS DE DANGER AVÉRÉ

- G. METTRE EN PLACE UN VÉRITABLE

SYSTÈME DE VERIFICATION DE L'AGE ET INSTAURER UN BLOCAGE DE TEMPS POUR

LES MINEURS

- H. PRÉVOIR UNE POSSIBILITÉ DE

SUSPENSION EN CAS D'ABSENCE DE RÉPONSE ET DE NON-RESPECT DE SES

OBLIGATIONS ESSENTIELLES PAR TIKTOK AVANT LE 1ER JANVIER 2024

- A. ÉLARGIR L'INTERDICTION DE L'APPLICATION

DÉJÀ DÉCIDÉE POUR LES FONCTIONNAIRES AUX

OPÉRATEURS D'IMPORTANCE VITALE (OVI)

- I. UNE STRATÉGIE VISANT À MINIMISER

LES LIENS DE TIKTOK AVEC LA CHINE

- ANNEXE 1 : CIRCULAIRE D'INTERDICTION DES

APPLICATIONS RÉCRÉATIVES

- ANNEXE 2 : L'EXTRATERRITORIALITÉ DU

DROIT CHINOIS

- ANNEXE 3 : LE DROIT AMÉRICAIN EN

MATIÈRE DE PROTECTION DES DONNÉES, DE MODÉRATION DES

CONTENUS ET DE LUTTE CONTRE LA DÉSINFORMATION

- EXAMEN EN COMMISSION

- LISTE DES DÉPLACEMENTS

- LISTE DES PERSONNES AUDITIONNÉES

- TABLEAU DE MISE EN oeUVRE ET DE SUIVI

DES RECOMMANDATIONS

N° 831

SÉNAT

SESSION EXTRAORDINAIRE DE 2022-2023

Rapport remis à M. le Président du Sénat le 4 juillet 2023

Enregistré à la Présidence du Sénat le 4 juillet 2023

RAPPORT

FAIT

au nom de la commission d'enquête (1) sur l'utilisation du réseau social TikTok, son exploitation des données, sa stratégie d'influence,

Président

M. Mickaël

VALLET,

Rapporteur

M. Claude MALHURET,

Sénateurs

Tome I - Rapport

(1) Cette commission est composée de : M. Mickaël Vallet, président ; M. Claude Malhuret, rapporteur ; M. Stéphane Artano, Mme Toine Bourrat, MM. Thomas Dossus, André Gattolin, Loïc Hervé, Mmes Marie Mercier, Catherine Morin-Desailly, MM. Pierre Ouzoulias, Cédric Perrin, Mme Laurence Rossignol, vice-présidents ; Mmes Annick Billon, Céline Boulay-Espéronnier, Valérie Boyer, MM. Rémi Cardon, Daniel Gueret, Mmes Christine Lavarde, Sophie Primas.

LA TACTIQUE TIKTOK : OPACITÉ, ADDICTION ET OMBRES CHINOISES

« Les réseaux sociaux sont devenus l'une des principales menaces contre la démocratie » disait il y a peu M. Barack Obama dans « The Atlantic1(*) ». Le rêve de quelques jeunes ingénieurs californiens du début des années 2000 d'un Internet porteur d'une connaissance universelle, d'une transparence inédite et de nouveaux liens sociaux à l'échelle de la planète s'est transformé en une réalité beaucoup plus prosaïque. Fake news, discours de haine, harcèlement, désinformation, manipulations électorales à grande échelle, fermes à trolls, ne sont que quelques exemples des dérapages d'une technologie qui connaît un succès mondial mais bien souvent pour de mauvaises raisons.

C'est dans ce contexte qu'est apparu voici quelques années, après Facebook, Twitter, Instagram et quelques autres, un nouveau venu dont la croissance exponentielle lui a permis de dépasser en peu de temps la plupart de ses prédécesseurs. En apparence il leur ressemble. En réalité il s'en distingue par au moins trois aspects essentiels. D'abord son fonctionnement : au modèle du « graphe2(*) social » de la plupart des réseaux qui favorisent les interactions de l'internaute avec ses « amis », TikTok oppose un « graphe d'intérêts » qui privilégie les contenus proposés par l'application elle-même. En deuxième lieu, son algorithme extrêmement addictif qui retient des heures durant ses utilisateurs, essentiellement des enfants et des adolescents, sur leurs écrans. Enfin, malgré des efforts constants pour le dissimuler, l'évidence de la faculté pour l'État, le Parti communiste et les services de renseignement chinois d'accéder aux données recueillies sur les utilisateurs du monde entier.

Pour toutes ces raisons, TikTok est aujourd'hui interdit totalement dans plusieurs pays (Inde, Indonésie, Pakistan...) et de façon limitée dans beaucoup d'autres, notamment ceux de l'Union Européenne, France incluse. Faut-il aller plus loin et considérer que TikTok doit être mis à l'index, au même titre que Huawei, comme une des menaces envers les démocraties d'un régime chinois qui ne cesse de se durcir ? La moindre des prudences consiste en tous cas à nous départir de notre naïveté confondante envers les risques posés aux démocraties par les méthodes de plus en plus élaborées des dictatures et de ce qu'elles appellent leurs guerres hybrides. C'est le but de ce rapport.

LES

RECOMMANDATIONS

DE LA COMMISSION D'ENQUÊTE

Recommandation n° 1 : Élargir l'interdiction de l'application TikTok aux personnels identifiés comme devant jouer un rôle important en cas de crise au sein des opérateurs d'importance vitale (OVI). Après l'entrée en vigueur de la directive européenne NIS 2, élargir le champ d'application de l'interdiction de TikTok à certaines entités visées par la nouvelle directive, après une évaluation des risques au cas par cas.

Recommandation n° 2 : Demander à TikTok de détailler publiquement les nouvelles mesures de transparence et de modération mises en oeuvre afin de répondre aux critiques de l'ARCOM ; d'accroître les moyens de la modération francophone et de préciser ceux dédiés à la lutte contre la désinformation, d'assurer un retrait proactif des fausses informations, de renforcer la labellisation des contenus issus de médias d'États ou altérés par l'intelligence artificielle, d'assurer la transparence sur la manière dont sont attribués les « bonus » à la visibilité des contenus et inversement sur les techniques d'invisibilisation, enfin d'appliquer un processus d'amplification algorithmique pour les contenus fiabilisés par une certification telle que la Journalism Trust Initiative (JTI).

Recommandation n° 3 : Au niveau européen, organiser, dès le 17 février 2024, une supervision ciblée sur quelques très grandes plateformes, dont TikTok, avec l'aide des régulateurs nationaux volontaires.

Recommandation n° 4 : Demander à la Commission européenne de décider dès aujourd'hui du schéma de « réponse graduée » face à des fournisseurs de très grandes plateformes en ligne non coopératifs.

Recommandation n° 5 : Exiger de TikTok la négociation d'un accord satisfaisant et équitable avec la société des auteurs et compositeurs dramatiques (SACD) afin de lutter plus efficacement contre la piraterie audiovisuelle et les atteintes quotidiennes aux droits d'auteur à l'oeuvre sur la plateforme. De même, demander à TikTok de faire évoluer le premier accord négocié avec la société des auteurs, compositeurs et éditeurs de musique (SACEM) afin de rémunérer plus justement les éditeurs de musique dont les oeuvres originales contribuent au succès de la plateforme.

Recommandation n° 6 : En matière d'application du RGPD, mieux encadrer le mécanisme de coopération entre l'autorité de contrôle chef de file et les autorités de contrôle concernées, en particulier en fixant des délais pour réduire la durée des procédures transfrontalières et en incluant les procédures de règlement amiable dans son champ.

Recommandation n° 7 : Maintenir la possibilité pour les autorités de contrôle concernées de contrôler et de sanctionner le respect du futur règlement ePrivacy, en particulier en matière de cookies.

Recommandation n° 8 : Demander à TikTok d'apporter aux autorités nationales et européennes une démonstration plus précise et plus convaincante que les données des utilisateurs européens de TikTok seront protégées par le projet Clover.

Recommandation n° 9 : À défaut, proposer une alternative avec des garanties de sécurité supplémentaires suffisantes pour protéger les données des législations extraterritoriales, en désignant un « opérateur de confiance » immatriculé sur le territoire de l'UE et en recourant à des logiciels de traitement de données développés par des sociétés européennes également immatriculées sur le territoire de l'UE. Exiger de TikTok un délai précis pour la mise en oeuvre de ces garanties afin d'éviter toute annonce dilatoire similaire à celles des projets Texas et Clover, ce délai ne pouvant être supérieur à un an.

Recommandation n° 10 : Exiger de

Bytedance Ltd, maison mère de TikTok et société

immatriculée au sein du paradis fiscal des Iles Caïmans, la

transparence sur ses statuts et sur les droits de

vote à son conseil d'administration.

S'il

s'avère que la société est contrôlée par les

fondateurs chinois, demander à la Commission européenne d'exiger

de Bytedance, soit que les statuts de la société soient

modifiés pour mettre fin à ce contrôle des fondateurs, soit

que les parts de ceux-ci soient vendues.

Recommandation n° 11 : Exiger de TikTok que la société crée des API et y ouvre un large accès à l'ensemble des organismes de recherche qui le souhaiteraient, en communiquant sur cette politique afin que le monde académique et la société civile puissent évaluer le respect de ses obligations au regard du RSN.

Recommandation n° 12 : S'assurer de la légalité et de la sécurité des algorithmes d'ordonnancement des contenus, de modération et d'adressage de la publicité utilisés par les plateformes en ligne en mettant en place, au niveau européen, des normes minimales en matière d'éthique et de respect des droits fondamentaux, obligatoires pour tous les algorithmes, dès leur création (sécurité et légalité par construction ou « safety and legacy by design »).

Recommandation n° 13 : D'ores et

déjà, traiter en éditeur TikTok à travers son fil

« Pour Toi » et tenir la société

responsable de son contenu.

Recommandation n° 14 : Créer un nouveau régime européen de responsabilité renforcée pour les fournisseurs de services intermédiaires utilisant des algorithmes d'ordonnancement des contenus, à raison de cette utilisation.

Recommandation n° 15 : Demander à la plateforme Pharos de prendre davantage en compte les infractions liées à la diffusion de fausses informations et adapter le formulaire internet de déclaration d'infractions en conséquence.

Recommandation n° 16 : Exiger des plateformes numériques une modération a priori en cas de graves troubles à l'ordre public et d'utilisation de ces plateformes par les auteurs de ces troubles pour les organiser ou y inciter. Prévoir la possibilité, pour l'autorité administrative, s'il est constaté des émeutes et des incitations manifestes à la violence contre des personnes, à la dégradation des bâtiments ou des installations publiques ou à l'intrusion en leur sein, d'émettre des injonctions de retrait à l'encontre de tout service de réseau social en ligne pour retirer ou bloquer l'accès de ces contenus, à l'instar des dispositions qui existent déjà pour lutter contre la pédopornographie ou le terrorisme en ligne.

Recommandation n° 17 : Soutenir les recherches sur les effets sanitaires et psychologiques de l'application TikTok.

Recommandation n° 18 : En cas de danger avéré, mettre en oeuvre l'article 66 du RGPD pour suspendre l'application.

Recommandation n° 19 : Exiger de TikTok la mise en place d'un système performant de vérification de l'âge, prévoyant un tiers vérificateur indépendant.

Recommandation n° 20 : Instaurer pour les mineurs un blocage de l'application au bout de 60 minutes d'utilisation.

Recommandation n° 21 : Demander au

Gouvernement de suspendre TikTok en France et de demander sa suspension au sein

de l'UE à la Commission européenne pour des raisons de

sécurité nationale :

- si TikTok, avant le

1er janvier 2024, n'a pas répondu aux principales questions

soulevées par la Commission d'enquête (capital et statuts de la

maison-mère ByteDance ; propriété intellectuelle et

localisation des ingénieurs qui élaborent l'algorithme ;

nature des entités chinoises avec lesquelles TikTok est en relation

permanente ; nature des données des utilisateurs

transférées en Chine et raison de ces transfert ; capacité

du projet Clover à mettre fin à ces transferts de données

; nom des entreprises qui mettront en oeuvre le projet Clover ; raison de la

collecte massive de données ; nombre de mineurs qui cessent

réellement

d'utiliser l'application au bout d'une heure) ;

- si TikTok, dans le même délai, n'a pas pris les principales

mesures demandées par le présent rapport : clarification des

statuts et de l'actionnariat de la maison-mère Bytedance et

séparation effective avec la Chine ; mise en conformité avec les

prescriptions du DSA, incluant la mise en place d'une modération et

d'une lutte contre la désinformation enfin efficaces, ainsi que la

création d'interfaces de programmation ouvertes et transparentes ;

présentation de garanties supplémentaires pour le projet Clover ;

mise en place d'un contrôle effectif de l'âge et de mesures

concrètes pour lutter contre l'utilisation excessive par les adolescents

et contre leur enfermement dans des « bulles de filtres » ;

fin de la « piraterie ».

La participation de TikTok aux travaux de la

commission d'enquête :

« La transparence dans

l'opacité »

Le phénomène qui a le plus frappé les membres de la Commission d'enquête tout au long de ses travaux est le contraste saisissant entre, d'une part, les proclamations permanentes de transparence des dirigeants de TikTok et, d'autre part, le jugement de toutes les autres personnes et institutions rencontrées, régulateurs, chercheurs, journalistes, responsables politiques, dont le sentiment, entendu à chaque audition se résume à un mot : l'opacité.

TikTok a répondu à trois questionnaires envoyés par le rapporteur. Deux de ses dirigeants, M. Éric Garandeau, directeur des affaires publiques et Mme Marlène Masure, directrice générale des opérations France, Benelux et Europe du Sud, ont été entendus en auditions et ont répondu aux questions du rapporteur et des membres de la commission d'enquête pendant plus de trois heures chacun.

Toutefois, tout au long de ces échanges, l'entreprise et ses représentants se sont efforcés de maintenir cette opacité à laquelle le groupe TikTok est habitué et de retenir toute information qui ne serait pas déjà publique.

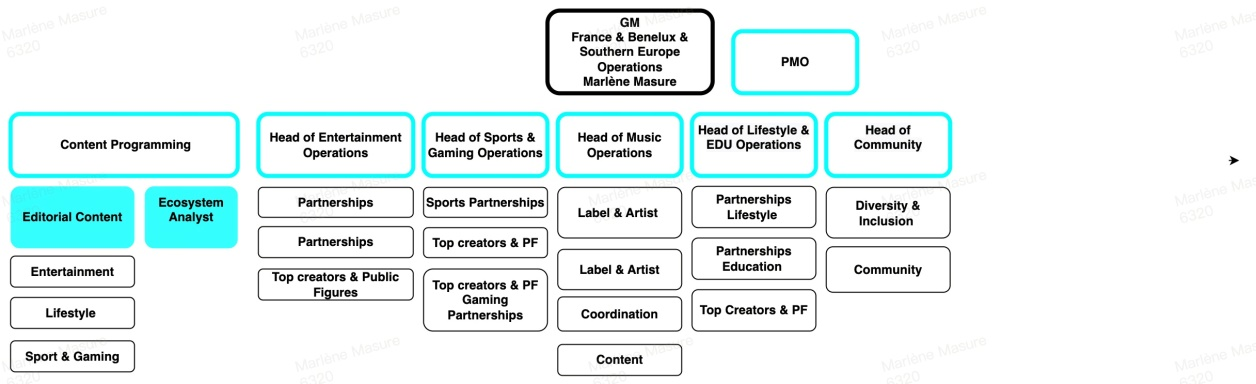

Le document transmis en réponse à une demande de fournir au secrétariat de la commission d'enquête un organigramme de la société TikTok SAS en est un exemple révélateur : il ne faisait apparaître aucun nom de responsables à l'exception de Mme Marlène Masure, déjà publiquement identifiée comme directrice générale des opérations.

Organigramme transmis par TikTok SAS à la commission d'enquête

M. Éric Garandeau - qui n'apparaissait pas

lui-même sur ce document - a justifié ce format comme une

mesure de sécurité, pour « ne pas

exposer les salariés à des risques de menaces, chantage ou

harcèlement de la part d'utilisateurs mécontents de

décisions de modération ». La seule information

qu'il a consenti à révéler est que « ce

sont des personnes françaises, qui opèrent

depuis nos bureaux parisiens, et plutôt junior car elles gèrent

des portefeuilles de partenaires et ont été recrutées

depuis peu ». Ce n'est qu'après plusieurs

échanges écrits qu'un organigramme complet a finalement

été fourni... complet à l'exception d'une seule personne

que le rapporteur a dû identifier lui-même car elle ne figurait

dans aucun des documents remis. Il s'agissait pourtant de la Présidente

de la société : Mme Zhao Tian...

De même, le rapporteur a souhaité disposer de l'ensemble des conditions générales d'utilisation, des politiques de confidentialité et autres règles contractuelles applicables aux utilisateurs français et a demandé à TikTok de présenter les différentes versions de celles-ci, pour en comprendre les évolutions au cours du temps.

Dans sa première réponse, la société TikTok a renvoyé aux conditions générales d'utilisation et à la politique de confidentialité en ligne, sachant que la politique de confidentialité a été actualisée le 4 mai 2023 au cours des travaux de la commission d'enquête. Elle a également éludé la question sur les évolutions dans le temps en indiquant que « TikTok réexamine régulièrement ses conditions et politiques et, le cas échéant, les met à jour (par exemple, pour se conformer à de nouvelles obligations légales ou pour refléter les meilleures pratiques de l'industrie) ». Elle a simplement donné quelques exemples ponctuels d'évolutions, sans en fournir le détail ni être exhaustive.

C'est pourtant derrière sa politique de confidentialité, très incomplète sur ce sujet, que TikTok s'est retranché pour refuser de répondre aux demandes précises du rapporteur concernant les données à caractère personnel collectées auprès des utilisateurs.

Extrait des réponses de TikTok

Enfin, lors de leurs auditions, les représentants de TikTok SAS n'ont pas répondu à certaines questions précises du rapporteur, préférant apporter ultérieurement des compléments par écrit. Ces compléments effectivement communiqués ont maintenu l'opacité sur plusieurs sujets. Ainsi, concernant le stockage et les transferts à l'étranger des données des utilisateurs, et sur les raisons de ces transferts, TikTok a choisi de maintenir le secret. TikTok n'a pas non plus répondu aux questions sur les « équipes produit ingénierie » situées dans le monde entier, notamment aux États-Unis, en Europe, à Singapour et en Chine, ou, comme on le verra, sur le nom des entités du groupe situées en Chine avec lesquels l'entreprise travaille. Autre exemple, aucune information n'a été apportée sur le nombre de mineurs qui arrêtent effectivement de regarder le fil « Pour Toi » après l'alerte apparaissant au bout de 60 minutes, mesure pourtant mise en avant comme la « mesure phare » pour lutter contre l'utilisation excessive de l'application par les jeunes.

La société ByteDance3(*), société-mère de TikTok, a été créée en 2012, par M. Zhang Yiming et M. Liang Rubo, ingénieurs chinois en informatique, à Zhongguaucun, technopole située dans le district de Haidian de Pékin, considérée comme la « Silicon Valley chinoise ».

ByteDance a constitué dès sa création une « App factory »4(*), une fabrique d'applications. En quelques mois, l'entreprise crée ainsi deux applications : Neihan Duanzi (« Plaisanterie sous entendue »), un forum humoristique, et Jinri Toutiao (« Les titres du jour »), un agrégateur d'informations qui repose sur un flux de contenu personnalisé et qui remporte rapidement un succès important.

En septembre 2016, ByteDance investit le domaine des vidéos à format court en créant Douyin (« son d'une vibration »). Cette application s'inspire alors de Musical.ly, une plateforme née en Chine proposant des vidéos musicales et de karaoké, qui fonctionne à l'étranger mais qui reste confidentielle en Chine. En mai 2017, ByteDance lance une version internationale de Douyin, dénommée TikTok. ByteDance rachète Musical.ly en novembre 2017 puis fusionne Musical.ly et TikTok en août 2018.

À partir de 2018, la croissance de TikTok devient exponentielle. Pour favoriser son succès à travers le monde, ByteDance investit massivement dans des campagnes de communication pour promouvoir TikTok sur les autres plateformes. Rien qu'en 2018, la société dépense 1 milliard de dollars en campagnes de publicités sur les sites de ses principaux concurrents comme YouTube, Instagram et Snapchat, afin d'attirer de nouveaux utilisateurs sur TikTok5(*). Le moins qu'on puisse dire est que ceux-ci n'ont rien vu venir...

La pandémie de covid-19 sert d'accélérateur à la croissance de l'application. Alors qu'elle comptait 54 millions d'utilisateurs en janvier 2018, TikTok en cumule plus de 689 millions en juillet 2020. En septembre 2021, l'application passe le cap du milliard d'utilisateurs mensuels. En 2023, TikTok compte 1,7 milliard d'utilisateurs actifs, soit plus de 20 % des 4,8 milliards d'utilisateurs d'internet dans le monde.

En septembre 2021, TikTok est même passé, selon Cloudflare, devant Google en termes de site le plus visité, titre qu'il a depuis perdu pour repasser en troisième position. Avec 3 milliards d'installations, TikTok était en 2022 l'application la plus téléchargée de l'histoire6(*). Les utilisateurs de TikTok ouvrent leur application environ 40 fois par jour7(*). TikTok a été utilisé en 2022 par 22 millions de Français, avec 9 millions d'utilisateurs quotidiens8(*).

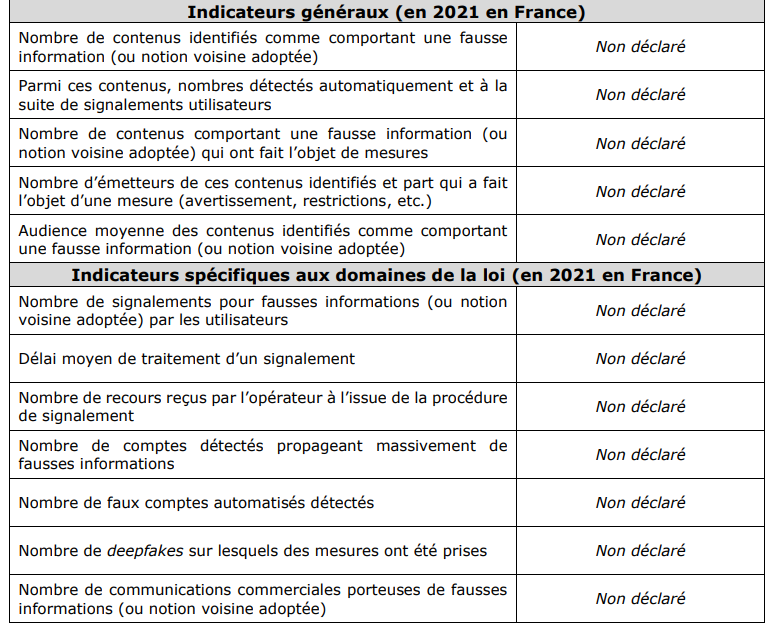

Le succès de TikTok est particulièrement impressionnant chez les plus jeunes, l'application étant massivement plébiscitée par les enfants et les adolescents. En 2022, TikTok était le deuxième média social le plus utilisé par les adolescents américains après YouTube. Au moins un tiers des utilisateurs français sont mineurs, ce qui représente plusieurs millions d'adolescents et d'enfants. Selon une récente enquête mondiale de Qustodio, les mineurs passent en moyenne 1h47 par jour sur TikTok9(*).

Application de divertissement, ayant fait son succès à l'origine sur des vidéos musicales et de synchronisation labiale, TikTok est en outre de plus en plus une plateforme choisie par les jeunes pour s'informer. 15 % des 18-24 ans utilisent l'application dans le but de s'informer10(*). Aux États-Unis, plus du quart des 18-29 ans utilisent régulièrement TikTok pour s'informer11(*).

Cependant, depuis ses origines, l'application a suscité de nombreuses polémiques médiatiques mais aussi des inquiétudes sérieuses, conduisant à une interdiction dans certains pays ou à des restrictions d'utilisation sur les terminaux portables d'employés des administrations publiques.

Au premier rang de ces inquiétudes, les liens entre l'entreprise et la Chine font craindre une utilisation possible de l'application à des fins de désinformation ou de collecte de données personnelles des utilisateurs par les autorités de ce pays. Le présent rapport s'efforce à ce sujet d'évaluer la persistance de ces liens malgré les dénégations des représentants de l'entreprise et d'évaluer les risques qui en découlent (I).

Plus généralement, le rapport montre aussi que TikTok France fait preuve d'une grande opacité dans ses relations avec l'ensemble des institutions en France, en particulier avec celles qui représentent les ayants droit des artistes dont des créations sont réutilisées dans les contenus de la plateforme, sans qu'ils obtiennent nécessairement en échange une juste rémunération (II).

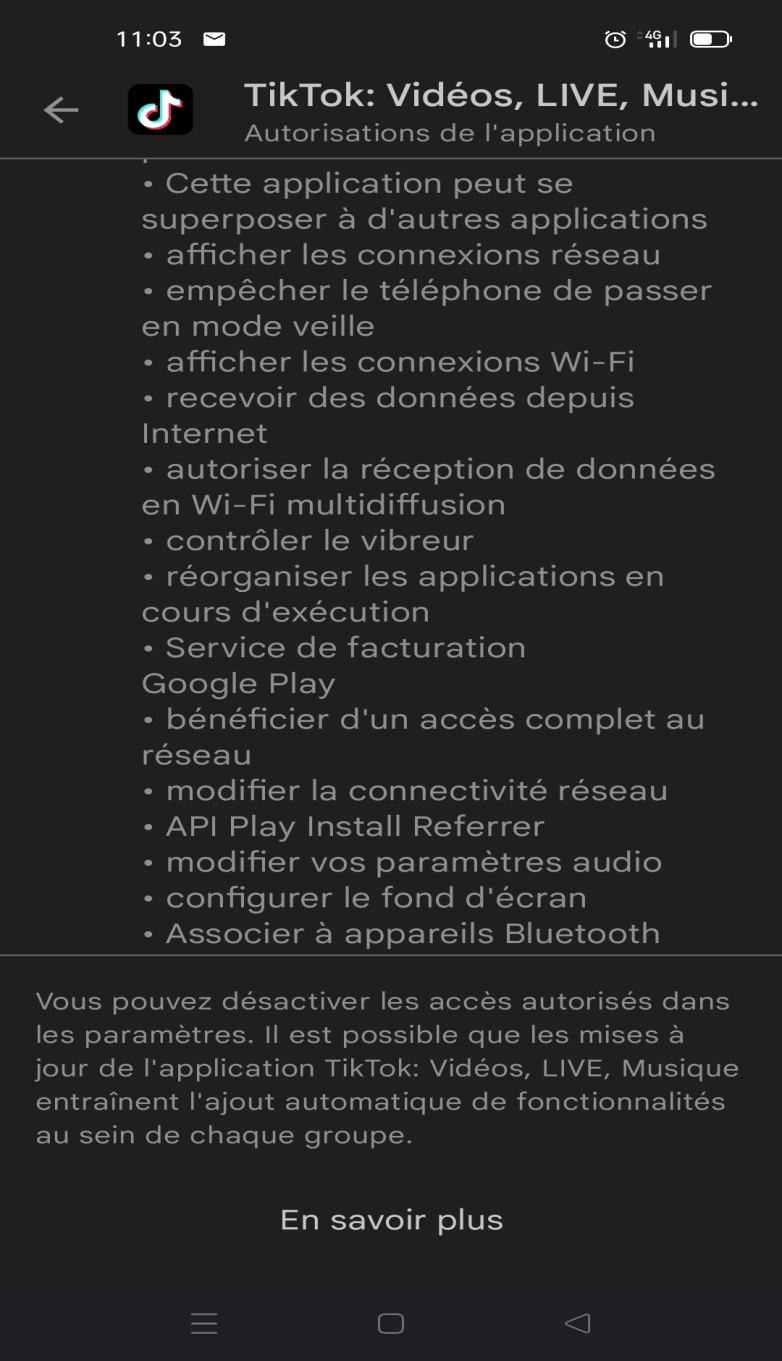

En troisième lieu, il a été reproché à l'entreprise de ne pas respecter le Règlement général sur la protection des données européen (RGPD) en collectant plus de données que nécessaires et en les transférant dans des pays qui n'appliquent pas des règles équivalentes. Le rapport mesure l'étendue de cette collecte de données, en décrit les mécanismes et étudie la réponse apportée par l'entreprise (III).

Il approfondit également la question de l'algorithme (IV) du fil « Pour Toi » de TikTok, qui constitue le coeur de l'application et le premier artisan de son succès, tout en suscitant de nombreuses critiques liées à son opacité.

TikTok a été particulièrement pointée du doigt par l'ARCOM en raison de ses mauvaises performances et de son absence de transparence en matière de lutte contre la désinformation et dans les autres domaines couverts par le nouveau Règlement sur les services numériques (RSN) qui doit entrer en vigueur à partir de l'été 2023. Dans le domaine, le présent rapport recense les faits reprochés à l'application et s'efforce d'en comprendre les causes (V).

Enfin, de nombreux reproches sont faits à l'application du fait de son « addictivité » et des conséquences psychologiques ou sanitaires de son utilisation intensive par les adolescents et les enfants. Cette question, d'une grande importance compte tenu de la diffusion extrêmement large de TikTok au sein de cette population, fait l'objet de la partie VI.

La dernière partie du rapport présente une série de recommandations destinées à prévenir ou à traiter l'ensemble des risques ainsi recensés et analysés (VII).

I. UNE STRATÉGIE VISANT À MINIMISER LES LIENS DE TIKTOK AVEC LA CHINE

Réseau social au succès mondial, TikTok présente la particularité, par rapport aux autres plateformes numériques de cette envergure, d'avoir été créée par une entreprise chinoise, ByteDance, créée par M. Zhang Yiming en 2012 à Pékin.

Depuis plusieurs années, la Chine est engagée dans une stratégie d'influence à grande échelle, qui a fait l'objet de plusieurs rapports12(*). Cette stratégie se décline de manière particulièrement ambitieuse dans le monde numérique. Dans ce contexte, les représentants de TikTok s'emploient à démontrer que leur entreprise est désormais complètement séparée de la branche chinoise de la maison-mère, ByteDance, et qu'elle n'est donc pas soumise au contrôle ni à l'influence des autorités chinoises.

Les investigations menées par les membres de la commission d'enquête montrent cependant que ce postulat ne résiste pas à l'examen. Il peut au contraire être démontré qu'il existe des liens étroits entre TikTok et les entités situées en Chine du groupe ByteDance, tant sur le plan des transferts de données que des technologies utilisées, de la propriété intellectuelle ou encore des relations entre les employés. En outre, des faits concrets illustrant ces liens avec la Chine sont intervenus encore récemment, décrédibilisant le discours des représentants de TikTok sur ce sujet. Les nouvelles décisions de restriction d'usage de l'application qui ont été prises en série aux mois de mars et d'avril 2023 par les gouvernements et institutions de nombreux pays ne font que traduire la prise de conscience des risques que fait peser cette persistance des liens avec la Chine. La réponse de TikTok, le projet Clover, s'avère insuffisante pour mettre fin à ces craintes légitimes.

A. LE CONTEXTE : UNE STRATÉGIE D'INFLUENCE NUMÉRIQUE ASSUMÉE PAR LA CHINE

1. Une « guerre cognitive » au service des intérêts et de la pérennité du régime

Les risques pour la sécurité nationale que peuvent représenter des entreprises chinoises mondialisées telles que Huawei ou TikTok doivent être appréhendés dans le contexte des vastes opérations d'influence menées par la Chine depuis plusieurs années et mobilisant plusieurs leviers d'action, en particulier les entreprises internationales et les réseaux sociaux.

Selon le rapport de M. Paul Charon et de M. Jean-Baptiste Jeangène Vilmer publié en 2021 pour l'Institut de recherche stratégique de l'école militaire (Irsem), les opérations d'influence chinoises tendent à se complexifier et à se durcir. C'est pourquoi ce rapport fait référence au « moment machiavélien » de la Chine.

Ces opérations poursuivent plusieurs objectifs. D'une part, produire un discours positif sur la Chine, son hégémonie, ses valeurs et son modèle, souvent présenté en opposition avec le modèle de la démocratie libérale qui prévaut aux États-Unis et en Europe. D'autre part, « empêcher tout discours négatif sur le PCC, en prévenant et contrôlant tout discours sur les « cinq poisons » (Ouïghours, Tibétains, Falun Gong, « militants pro-démocratie », « indépendantistes taïwanais »), et plus généralement toute critique du Parti »13(*).

Cette analyse est corroborée par le premier rapport du service européen d'action extérieure (SEAE) sur les menaces de manipulation étrangère de l'information et d'interférences, que les membres de la commission d'enquête ont eu l'opportunité de rencontrer à Bruxelles lors d'un déplacement auprès des institutions européennes le 24 avril 2023.

Sur l'année 2022, l'étude empirique menée par le SEAE décrit un ensemble de comportements, certes généralement non illégaux, qui néanmoins menacent ou peuvent avoir un impact négatif sur les valeurs, les procédures et les processus politiques des pays cibles. Ces comportements sont de nature manipulatrice, menée de manière intentionnelle et coordonnée par des acteurs étatiques ou non étatiques, y compris leurs mandataires, à l'intérieur et à l'extérieur de leur propre territoire.

Cette étude recense ainsi une centaine d'incidents, dont 17 sont attribués directement à la Chine, principalement menés par des acteurs étatiques à destination d'une audience internationale. Il est ainsi établi que « les incidents chinois ont promu la Chine en tant que partenaire fiable et leader mondial, tout en dégradant l'Occident, en soulignant notamment la manière dont les États-Unis déstabilisaient l'Union européenne »14(*).

Afin de mieux comprendre les opérations d'influence menées par la Chine et les risques qu'elles représentent, le rapport de l'Irsem rappelle ainsi l'ancienneté et la densité de la pensée stratégique et militaire chinoise dont les concepts suivants peuvent aujourd'hui être mobilisés pour mieux cerner cette stratégie d'influence et rendre les Européens plus lucides face aux prétentions hégémoniques de la Chine :

- la « guerre de l'opinion publique », qui consiste à « créer un environnement d'opinion publique favorable à l'initiative politique et à la victoire militaire »15(*) ;

- la « guerre psychologique », qui consiste à « utiliser des informations spécifiques et des médias pour des actions de combat qui affectent la psychologie et le comportement du public cible »16(*) ;

- la « guerre cognitive » qui, se situant au croisement de la guerre de l'opinion publique et de la guerre psychologique, consiste à « utiliser la guerre psychologique pour façonner et même contrôler les capacités cognitives de l'ennemi et de prise de décision »17(*).

2. Une « force de frappe internationale » qui intéresse forcément les services chinois

Parmi les différents concepts évoqués ci-dessus, celui de « guerre cognitive » a particulièrement retenu l'attention des membres de la commission d'enquête lors des diverses auditions menées, car il reflète particulièrement bien les inquiétudes exprimées par de nombreux spécialistes quant à l'instrumentalisation possible de TikTok par le régime chinois.

Avec plus d'un milliard d'utilisateurs dans le monde dont 22 millions d'utilisateurs actifs mensuels en France, TikTok est la version internationale à succès d'une autre application, Douyin, qui est une application chinoise seulement autorisée et utilisée en Chine, alors que TikTok y est interdit.

Au regard de sa croissance, du nombre de ses utilisateurs, particulièrement jeunes, et de sa capacité à susciter une utilisation intensive grâce à un algorithme de recommandation dynamique favorisant la succession de vidéos en format court, TikTok apparaît comme un levier potentiel pour contribuer à cette « guerre cognitive » dont « le but ultime est de manipuler les valeurs, l'esprit/l'éthos national, les idéologies, les traditions culturelles, les croyances historiques, etc., d'un pays pour les inciter à abandonner leur compréhension théorique, leur système social et leur voie de développement »18(*).

Pour le chercheur M. Julien Nocetti, « il faut comprendre que les stratégies de subversion sont devenues la norme dans le cadre des relations internationales, plutôt que l'exception. Ce rapport de force dans le domaine cognitif vient finalement exploiter quelque chose d'assez ancien. Mais celui-ci est adapté à des contenus extrêmement personnalisés, et s'insère dans une démarche de répétition, qui, alliée à des contenus courts, permet de capter l'attention de l'utilisateur et de le rendre très dépendant des contenus qu'il consulte »19(*).

Autrement dit, selon certains analystes, TikTok représente une « force de frappe internationale » que le régime chinois pourrait mettre à profit afin « d'affaiblir les résistances » d'une jeunesse mondiale qui constituera, dans quelques années, le principal concurrent à une société et à une force productive chinoises en quête d'hégémonie et d'une plus grande reconnaissance internationale.

Comme l'a expliqué M. Paul Charon, directeur du domaine « Renseignement, anticipation et stratégies d'influence » de l'Irsem : « ce que l'on ne sait pas, c'est à quel point le fait de mettre du contenu tendant à abêtir les utilisateurs correspond ou non à une stratégie de la Chine. Est-ce seulement une conséquence néfaste de l'algorithme, surtout conçu a priori pour faire du profit, suivant l'intérêt de TikTok et de ByteDance ? Mais comme la plateforme a du succès, elle intéresse nécessairement les services chinois, qui peuvent être intéressés par la diffusion de contenus »20(*).

Si les doutes subsistent sur les différences réelles entre TikTok et Douyin, les auditions des dirigeants de TikTok SAS France devant la commission d'enquête n'ayant en aucun cas permis de les dissiper, une chose est certaine : il existe en Chine une véritable politique de limitation du temps d'écran et de lutte contre les addictions aux jeux et aux plateformes numériques qui, dans un contexte de « guerre cognitive » assumée, modifie, en notre défaveur, notre rapport de force vis-à-vis de ce pays.

B. LE CONTRÔLE EXERCÉ PAR LE PARTI COMMUNISTE CHINOIS SUR LES GRANDES ENTREPRISES

1. Un succès improbable sans le soutien affirmé des autorités

Les entreprises sont aujourd'hui des acteurs de premier plan des stratégies d'influence menées par la Chine sur la scène internationale, en particulier les entreprises des nouvelles technologies de l'information et de la communication dont TikTok est le dernier fleuron.

Les critiques et les craintes de l'opinion publique, des services de renseignement et des dirigeants politiques concernent surtout les entreprises mondialisées d'origine chinoise car, en l'état actuel du fonctionnement du régime chinois, le succès international de l'entreprise ne peut être assuré sans un soutien manifeste du Parti communiste chinois (PCC). À cet égard, les travaux précités de l'Irsem relèvent un renforcement du contrôle exercé par le PCC sur le secteur privé et sur les grandes entreprises : « On peut ainsi dire qu'aucune compagnie importante en Chine ne peut prospérer sans être sur la ligne du Parti. Sous le mandat de M. Xi Jinping, cette tendance s'est même renforcée avec le programme Made in China 2025, la Belt and Road Initiative et les plans de développement en matière d'intelligence artificielle ou d'informatisation »21(*).

Ce constat a été confirmé et expliqué à des nombreuses reprises lors des auditions menées par la commission d'enquête. Ainsi, M. Marc Faddoul, chercheur en intelligence artificielle et directeur de l'association AI Forensics, a rappelé que « le régime de M. Xi Jinping a démontré à plusieurs reprises qu'il contrôlait l'écosystème technologique d'une main de fer »22(*).

Le député européen M. Raphaël Glucksmann, qui préside la commission du Parlement européen sur les ingérences étrangères, a insisté sur les différences culturelles et politiques qui existent avec le régime chinois : « ByteDance n'est pas une entreprise privée comme on l'entend en France. Bien sûr, sur le papier, elle en est une. Mais en Chine comme en Russie, il est impossible pour une entreprise dépassant une taille critique d'échapper au contrôle du régime politique »23(*).

Le contrôle exercé par le PCC sur les grandes entreprises chinoises peut se matérialiser de différentes façons, mais notamment par :

- la présence de cellules du PCC au sein de l'entreprise, comme cela a été par exemple mis en évidence pour Huawei, le PCC disposant de 300 cellules et de 12 000 membres parmi les salariés de l'entreprise24(*). Selon Mme Alice Ekman, sinologue et analyste responsable de l'Asie à l'Institut des études de sécurité de l'Union européenne (EUISS), il y aurait aujourd'hui plus de 1,5 million de cellules du PCC implantées dans des entreprises, avec une présence plus ou moins marquée selon les secteurs25(*) ;

- l'exigence d'avoir un nombre minimum de salariés inscrits au PCC au sein de l'entreprise, en particulier s'il s'agit de joint ventures entre des entreprises chinoises et des entreprises étrangères. Il est ainsi estimé que le PCC compte 92 millions de membres en Chine, avec une tendance croissante estimée à 2 millions d'adhésions supplémentaires par an26(*) ;

- l'accès facilité à des financements bancaires, en particulier de la part de la China Bank et de la China Export-Import Bank ;

- les prises de participation minoritaire au capital des grandes entreprises (Alibaba ; Tencent ; ByteDance, maison mère de TikTok ; etc.) par l'intermédiaire des « golden shares » détenues par l'Administration du cyberespace de Chine, permettant au PCC de siéger à leur conseil d'administration et de veiller, en conséquence, au bon respect de la ligne du Parti.

Par divers procédés de surveillance et de contrôle, la Chine d'aujourd'hui renforce progressivement son implication dans le développement et la gouvernance des grandes entreprises chinoises qui se développent internationalement. Cette situation témoigne d'un changement de stratégie d'influence plus globale, comme le soulignent de récents travaux parlementaires à ce sujet : « la Chine de M. Xi Jinping se caractérise par une projection sur la scène internationale qui se distingue des préceptes mis en avant sous l'ère de M. Deng Xiaoping, à savoir « faire profil bas » et « attendre son heure »». Si la Chine d'hier était concentrée sur son développement intérieur, la Chine d'aujourd'hui - et de demain - lie stabilité intérieure et affirmation extérieure »27(*).

2. Une coopération inévitable avec les services de renseignement

Les craintes exprimées à l'encontre de TikTok et d'autres entreprises chinoises internationales sont intrinsèquement liées à la nature du régime politique chinois, à son régime juridique et à l'extraterritorialité de son droit. En particulier, la coopération inévitable avec les services de renseignement a été mise en avant à de très nombreuses reprises lors des auditions menées par la commission d'enquête, comme l'illustrent les témoignages suivants :

- pour M. Marc Faddoul, « le fait que TikTok, parce qu'elle est une entreprise chinoise, doive répondre aux demandes d'un gouvernement autoritaire, constitue une distinction importante »28(*) ;

- pour M. Benoît Loutrel, membre du collège de l'Autorité de régulation de la communication audiovisuelle et numérique (ARCOM) « la loi chinoise oblige toutes les sociétés à coopérer avec les services de renseignement chinois » 29(*) ;

- pour M. Paul Charon : « aucune société chinoise ne peut tenir tête au parti. C'est juste impossible. Le système ne le permet pas, d'abord parce qu'une loi sur le renseignement et une loi sur le contre-espionnage autorisent, depuis 2014 et 2017, les services de renseignement chinois à demander à toute entreprise chinoise de leur transmettre les données dont elle dispose sur des individus ou des personnes morales »30(*) ;

- pour M. Raphaël Glucksmann, « une grande entreprise comme ByteDance est soumise non seulement à la loi de 2017 qui soumet tous les acteurs institutionnels, privés y compris, aux exigences de sécurité nationale émises par le parti communiste chinois mais également aux diktats politiques fixés par le pouvoir »31(*).

Cette « loi chinoise de 2017 » à laquelle il est souvent fait référence désigne la loi sur le renseignement national de la République populaire de Chine adoptée le 27 juin 2017 qui codifie la pratique existante en matière de renseignement, établit une distinction entre les fonctions du renseignement civil et du renseignement militaire et des principes juridiques pour le fonctionnement des agences de sécurité de l'État, sans précisément les nommer ni définir la notion de « renseignement ».

En particulier, les articles 7, 9 et 10, dont la traduction figure ci-dessous, suscite des inquiétudes légitimes de la part de nombreux experts et dirigeants politiques. La portée extraterritoriale de cette loi, applicable en dehors du territoire de la République populaire de Chine pour y autoriser, sous certaines conditions, l'activité des services de renseignement chinois, est ainsi explicitement mentionnée.

|

Extraits de la loi sur le renseignement national de la République populaire de Chine Article 7 Toute organisation et tout citoyen doit soutenir, aider et coopérer avec les services de renseignement de l'État conformément à la loi et ne pas divulguer les secrets des services de renseignement de l'État. L'État protège les personnes et les organisations qui soutiennent, assistent et coopèrent aux activités de renseignement de l'État. Article 9 L'État félicite et récompense les personnes et les organisations qui ont contribué de manière significative à l'activité de renseignement de l'État. Article 10 Les services de renseignement de l'État utilisent, en fonction des besoins de leur activité, les moyens, méthodes et canaux nécessaires pour mener à bien les activités de renseignement à l'intérieur et à l'extérieur de l'État, conformément à la loi. |

Ainsi, la combinaison du contrôle ordinaire du PCC sur l'économie et les grandes entreprises internationales et de la portée extraterritoriale du droit chinois conduit à ce que « tout citoyen, toute entreprise peuvent être contraints de devenir des agents du PCC, c'est-à-dire à tout le moins des informateurs, parfois des espions »32(*).

Il y a ainsi aujourd'hui un contexte, une stratégie d'influence, un régime politique et juridique et des contraintes dont on ne saurait faire abstraction s'agissant de TikTok et de ByteDance, entreprises dont les pages suivantes démontrent les liens étroits et persistants avec la Chine. Bien au contraire, le succès mondial de l'application la rend plus vulnérable aux pressions qui découlent nécessairement de ce contexte.

C. DES LIENS AVEC LA CHINE QUI PERSISTENT MALGRÉ LA VOLONTÉ DE PRÉSENTER TIKTOK COMME UNE ENTREPRISE NON CHINOISE

Face aux allégations concernant les liens persistants de TikTok avec la Chine, une double ligne de défense est suivie par les représentants de l'entreprise.

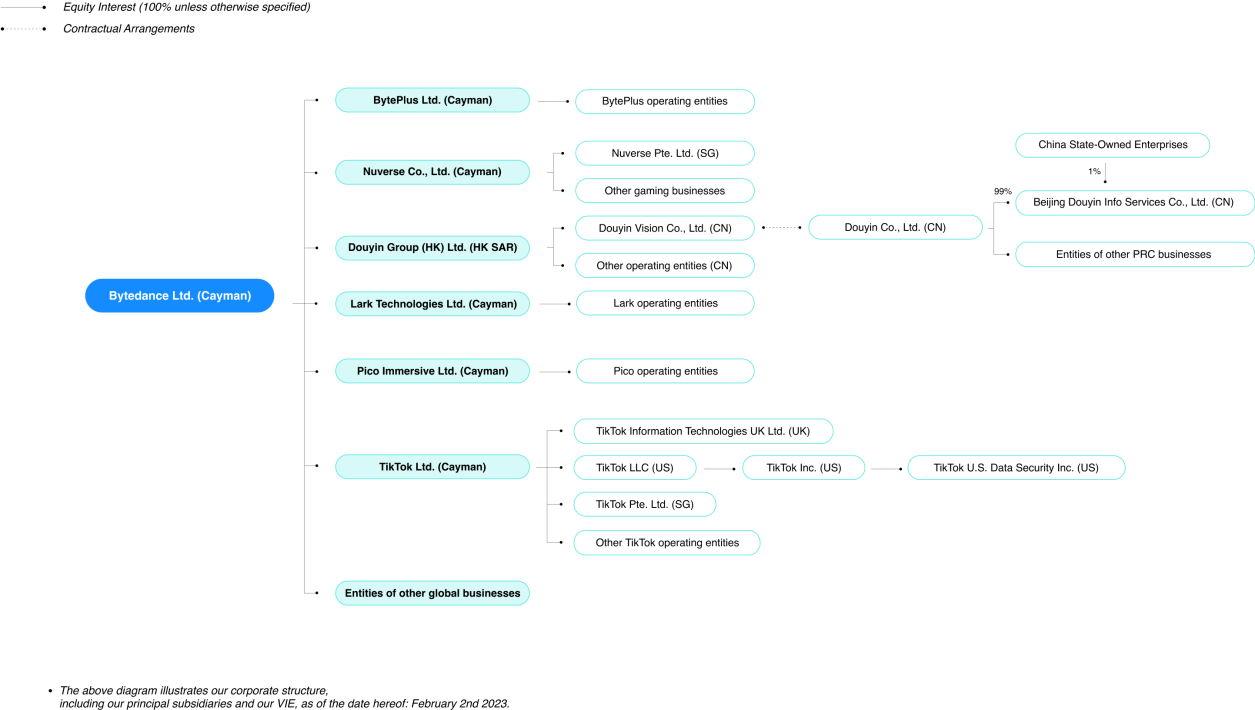

D'une part, ceux-ci affirment que la maison mère de TikTok, ByteDance, est une entreprise internationale, immatriculée aux îles Caïmans et dont le capital est pour l'essentiel détenu par de grands investisseurs institutionnels, dont plusieurs sont Américains. En caricaturant, ByteDance serait une entreprise américaine et non une entreprise chinoise, et TikTok, elle-même relativement autonome par rapport à ByteDance selon ses représentants, serait donc une entreprise totalement internationale et nullement chinoise. Ainsi, devant le Congrès américain, le PDG de TikTok a insisté sur cet actionnariat international et sur le caractère international, et non chinois, de sa société.

D'autre part, les représentants de TikTok et de ByteDance soutiennent que la branche chinoise de ByteDance, qui perdure malgré un changement de nom (cf. ci-dessous, comment les filiales de ByteDance en Chine ont été rebaptisées Douyin) est totalement séparée des autres branches de l'entreprise, et que par conséquent ni données, ni contrôle, ni influence ne peuvent circuler « transversalement » entre cette branche chinoise et les autres entités de ByteDance partout ailleurs dans le monde.

Ainsi, selon les représentants de TikTok : au sommet se trouve ByteDance Ltd, immatriculée aux îles Caïmans, sous laquelle plusieurs chaînes complètement séparées les unes des autres « descendent » jusqu'aux entités nationales. L'une de ses chaînes passe par TikTok Ltd (également immatriculée aux îles Caïmans) et se ramifie notamment en TikTok US et TikTok UK, dont TikTok SAS en France est une filiale à 100%. Une autre chaîne, présentée comme séparée de la précédente, passe par Douyin group Ltd (HK) puis les diverses entités de Douyin en Chine. Ainsi, comme l'a défendu M. Éric Garandeau lors de son audition devant la commission : « la chaine capitalistique et juridique qui descend de ByteDance à TikTok doit permettre de faire en sorte qu'il n'y ait pas de pressions qui soient exercées à l'encontre de la plateforme TikTok ».

L'organigramme public de ByteDance, ou comment l'entreprise souhaite que l'on se représente sa structure

Cette partie du rapport entend démontrer que cette présentation de la structure de l'entreprise comme assurant l'étanchéité des activités internationales de TikTok par rapport aux activités en Chine ne résiste pas à l'examen.

1. Des liens avec la Chine par le biais des dirigeants de l'entreprise

a) En France : une SASU dont la présidente est Mme Zhao Tian, cadre dirigeante de ByteDance qui n'apparaît pas sur l'organigramme fourni par TikTok

L'entité française de TikTok est une société par actions simplifiée à actionnaire unique (SASU), détenue à 100% par TikTok UK. En examinant les documents relatifs à cette entreprise déposés au greffe du tribunal judiciaire de Paris, le rapporteur a été surpris de constater que la présidente de cette société est Mme Zhao Tian, née en Chine, ayant acquis la nationalité canadienne et qui résiderait actuellement à Singapour. En effet, interrogés oralement puis à l'écrit sur l'organigramme de la société TikTok SAS, les représentants de l'entreprise n'ont pas fait la moindre allusion à cette personne, ni aux fonctions qu'elle exerce dans l'entreprise.

Pourtant, Mme Zhao Tian est non seulement présidente de TikTok SAS (la branche française) mais également présidente de TikTok UK, et membre du « board » de TikTok en Australie. Elle a en outre occupé des hautes fonctions eu sein du groupe ByteDance, ayant été vice-présidente de Toutiao, proche de M. Zhang Yiming, le fondateur de l'entreprise (cf. ci-dessous). Les responsables de TikTok SAS, interrogés expressément sur cette personne, ont par ailleurs indiqué qu'elle dirigerait l'équipe « Global Ethics » (éthique globale) de TikTok et serait basée à Singapour. Sur LinkedIn, Mme Zhao Tian dispose d'un profil très discret et communique rarement. On peut néanmoins y constater qu'elle a fait des études à l'académie diplomatique de Pékin.

Lors de leur audition, les responsables de TikTok France ont indiqué que Mme Zhao Tian n'avait « aucune responsabilité opérationnelle » au sein de TikTok SAS et expliqué sa nomination à la tête de la société par la pratique qui consiste, pour un groupe en pleine croissance au niveau mondial et qui en conséquence multiplie les filiales, à nommer la même personne à la tête d'un grand nombre de ces filiales. M. Garandeau et Mme Masure ont aussi indiqué n'avoir jamais rencontré Mme Zhao Tian. Interrogés sur les pouvoirs de Mme Zhao Tian en tant que présidente de TikTok SAS, les deux responsables ont systématiquement répondu au sujet de son absence de rôle opérationnel, éludant ainsi la question de ses prérogatives juridiques. En tant que présidente de la SAS, Mme Zhao Tian a pourtant tout pouvoir pour prendre les décisions relatives à la société dans son ensemble, comme la signature des contrats conclus avec la société, sa représentation vis-à-vis des tiers, la prise des actes engageant le patrimoine de la société, la détermination de la politique d'investissement ou encore sa stratégie financière.

Dans ce contexte, le fait que Mme Zhao Tian soit présidente de TikTok SAS a une importance qui ne relève pas de l'opérationnel au sein de l'entreprise mais bien du contrôle potentiel exercé sur son action par le pouvoir chinois : pendant toute sa période d'activité en Chine, notamment au sein de Toutiao, elle était en effet soumise à l'autorité de celui-ci, à la fois de fait et de droit. Le cas échéant, elle devait donc obtempérer à toute demande en provenance de cette autorité, qu'elle implique ou non des entités de ByteDance ainsi que des employés ou des utilisateurs de l'application situés en Chine ou de nationalité chinoise. Ce contrôle continue probablement à s'exercer quand bien même Mme Tian a acquis la nationalité canadienne.

Cette soumission des dirigeants du numérique chinois aux autorités est d'ailleurs démontrée par les faits : plusieurs d'entre eux, dont M. Zhang Yiming lui-même, fondateur de ByteDance, ont eu à subir des pressions très fortes, les forçant à publier leur autocritique voire, pour certains, à renoncer à tout ou partie de leurs fonctions (cf. ci-dessous).

Deux motivations peuvent alors être à l'oeuvre pour les autorités chinoises. D'une part, l'entreprise concernée peut sembler être une menace pour l'ordre social en Chine lorsqu'elle ne se conforme pas suffisamment aux souhaits des autorités, par exemple lorsqu'elle permet ou encourage l'expression d'opinions qui ne vont pas dans un sens favorable pour ces autorités et ses dirigeants : ainsi de Toutiao lorsqu'elle fut interdite temporairement en 2018, obligeant M. Zhang Yiming à faire son autocritique. D'autre part, comme déjà indiqué, le secteur du numérique est au centre d'une stratégie très élaborée et d'une grande cohérence de la part des autorités chinoises, déclinée en de multiples aspects, visant à en faire un instrument de pouvoir et d'influence au niveau international : or cette stratégie implique notamment un contrôle sur les dirigeants des entreprises du numérique (comme, par exemple, le PDG d'Alibaba, M. Jack Ma l'a appris à ses dépens).

Après l'audition de M. Garandeau, celui-ci a fait savoir aux membres de la commission d'enquête qu'un nouveau président, européen, allait remplacer Mme Zhao Tian à la tête de TikTok France, en raison des inquiétudes manifestées lors de son audition.

b) M. Zhang Yiming, fondateur de ByteDance et « bénéficiaire effectif » de TikTok France

Liée ainsi étroitement sur le plan juridique à une ressortissante chinoise, la société l'est également sur le plan capitalistique. En effet, dans ses statuts déposés au greffe du Tribunal de grande instance, il est indiqué que M. Zhang Yiming, fondateur de ByteDance, est bénéficiaire effectif de la société.

La notion de « bénéficiaire effectif » a été introduite dans le code monétaire et financier par la loi Sapin II du 9 décembre 2016, qui oblige les créateurs d'entreprise à fournir un document relatif à ce bénéficiaire effectif lors des formalités de création ou de modification d'entreprise. Le bénéficiaire effectif est défini par l'article R561-1 du code monétaire et financier comme la personne physique associée (SAS, SARL, etc.) ou l'actionnaire (SA) qui remplit une des conditions suivantes :

- elle détient, directement ou indirectement, plus de 25 % des droits de vote ou du capital de la société ;

- elle dispose d'un pouvoir de contrôle sur celle-ci par tout autre moyen (par exemple, elle peut nommer ou révoquer la majorité des membres des organes de direction).

En l'occurrence, le document du greffe indique que M. Zhang Yiming détient indirectement 26 % de la TikTok SAS. Ainsi qu'il a été indiqué au rapporteur par les responsables de TikTok France, cette société est détenue à 100 % par la filiale TikTok UK. Selon l'organigramme officiel de ByteDance, TikTok UK est elle-même détenue à 100 % par TikTok Ltd, à son tour détenue à 100 % par ByteDance Ltd (îles Caïmans). Comme l'ont confirmé les représentants de TikTok France, le contrôle de 26 % du capital de TikTok SAS par M. Zhang Yiming résulte ainsi des parts qu'il détient dans la maison mère, ByteDance Ltd, immatriculée aux îles Caïmans.

Ainsi, le fondateur de ByteDance est-il considéré par la loi française comme le bénéficiaire effectif de TikTok France.

c) Le rappel à l'ordre du fondateur de TikTok, son autocritique et son remplacement à la tête de l'entreprise

L'histoire personnelle de M. Zhang Yiming montre qu'il a dû se conformer étroitement au contrôle des autorités chinoises.

En 2009, M. Zhang Yiming, après un passage chez Microsoft, rejoignit la startup Fanfou, un clone de Twitter. L'application fut brutalement interdite pendant les émeutes d'Urumqi dans le Xinjiang en raison de messages ayant déplu au Gouvernement ; elle ne réapparut qu'un an plus tard. M. Zhang Yiming fut ainsi confronté une première fois à la rigueur des autorités.

En 2012, M. Zhang Yiming fonda ByteDance, la future maison mère de TikTok, avec son ancien camarade d'université M. Liang Rubo. ByteDance créa plusieurs applications, dont Toutiao (ou « Today's headlines »), un agrégateur de nouvelles qui connut rapidement un grand succès (et dont Mme Zhao Tian, la présidente de TikTok France, fut vice-présidente). ByteDance créa ensuite Douyin en 2016, un clone de Musical.ly, puis TikTok, version mondiale de Douyin, avant de racheter le concurrent Musical.ly et de le fusionner avec TikTok en août 2018.

Dès 2014, ByteDance eut à souffrir de la pression exercée par les autorités chinoises, qui lancèrent une enquête à l'encontre de Toutiao, accusée de promouvoir du contenu « vulgaire » et d'enfreindre les droits d'auteur. Cependant, l'entreprise semble avoir été protégée pour un temps grâce aux liens entretenus par ses fondateurs avec M. Lu Wei, directeur de l'administration du Cyberspace de Chine de 2013 à 2016, membre du Comité central du PCC et directeur adjoint du département de la propagande jusqu'en 2017, avant d'être arrêté, expulsé du Parti communiste chinois puis condamné à 14 ans de prison en 2019. Toutefois, les pressions continuèrent à s'exercer, M. Zhang Yiming ayant estimé et exprimé publiquement que Toutiao devait être considéré davantage comme un simple hébergeur, à l'image des plateformes américaines, que comme éditeur, c'est-à-dire soumis à une certaine responsabilité sociale33(*).

En 2018, Toutiao fut interdite trois semaines, peut-être en raison de sa popularité qui en faisait de fait une concurrente pour les médias officiels. Les autorités ont en outre affirmé qu'elle « violait la morale sociale ».

Quelques jours après cette interdiction, M. Zhang Yiming faisait une longue autocritique sur son compte WeChat, dans laquelle il déclarait notamment que « Notre produit a pris une mauvaise direction et le contenu publié n'était pas conforme aux valeurs fondamentales du socialisme ». Il déclare également « J'exprime mes plus sincères excuses aux autorités à nos usagers et à mes collègues. Depuis que j'ai reçu hier la note des autorités de régulation, je suis plein de remords et de culpabilité, qui m'ont empêché de dormir (...) Nous n'avons pas été assez attentifs et n'avons pas assez mis l'accent sur la responsabilité sociale de l'entreprise dans la promotion d'une énergie positive, et la compréhension des principes corrects qui doivent guider l'opinion publique. En tant que Start-Up en développement rapide dans le sillage du 18ème congrès national du parti communiste chinois, nous sommes pleinement conscients que ce développement a été permis par cette ère glorieuse (...) j'exprime ma gratitude pour cette occasion historique de réformes économiques et d'ouverture et ma gratitude envers ce gouvernement qui a permis le développement de l'industrie technologique ». Il s'engage ensuite à renforcer le travail de construction du parti au sein de l'entreprise ainsi que l'éducation de l'équipe aux «valeurs de base du socialisme ». Il indique également qu'il faut « approfondir la coopération avec les médias officiels, augmenter la diffusion des contenus officiels et s'assurer que la voix des média officiel soit relayée avec force, renforcer le système de responsabilité de la rédaction en chef, corriger entièrement les déficiences dans le contrôle des algorithmes et des ordinateurs, renforcer les opérations et les contrôles humain ».

En novembre 2021, M. Zhang Yiming abandonne finalement son siège de PDG de ByteDance au profit de son ami M. Liang Rubo - au moment, où, parallèlement, M. Jack Ma, qui a démissionné de ses fonctions de PDG d'Alibaba et a disparu pendant plusieurs mois après avoir critiqué les autorités, quitte toute responsabilité dans les affaires en Chine. Zhang Yiming garde néanmoins des responsabilités et des parts dans l'entreprise. Lors de son audition, M. Éric Garandeau, directeur des relations publiques de TikTok France, a expliqué que M. Zhang Yiming avait envoyé une lettre à tous les employés de ByteDance pour expliquer qu'il n'occuperait plus de fonctions exécutives au sein du groupe, désirant « prendre de la hauteur » et « se consacrer à la réflexion stratégique ».

Ainsi, le bénéficiaire effectif de TikTok France, M. Zhang Yiming, a-t-il dû publiquement manifester sa pleine et entière obéissance aux autorités chinoises. Toutefois, plus que son rôle de bénéficiaire effectif de la société française, c'est son rôle actuel dans la maison mère ByteDance Ltd qui pose question.

Soumis de fait au contrôle des autorités chinoises, M. Zhang Yiming l'est aussi de droit, même lorsqu'il ne se trouve pas en Chine. En effet, outre le contrôle ordinaire exercé sur les citoyens chinois et décrit dans la partie précédente, le droit chinois tend de plus en plus à l'extraterritorialité. En 2019, à l'issue de la deuxième session de la commission pour la gouvernance globale fondée sur le droit du PCC, ce dernier affirmait son ambition d'établir un système juridique d'application extraterritoriale (« [le pays] devrait s'efforcer d'accélérer la construction d'un système juridique d'application extraterritoriale de notre droit national »). Depuis, cette ambition a été réaffirmée à plusieurs reprises, notamment en 2022, lors d'une conférence sur « les réalisations de la Chine en matière de promotion de l'État de droit dans la nouvelle ère », organisée par le comité central du PCC. (cf. en annexe la note du service de droit comparé du Sénat sur l'extraterritorialité du droit chinois).

2. La volonté de faire apparaître la maison-mère de TikTok, ByteDance, comme une entreprise internationale et non chinoise

a) Une domiciliation de la maison mère ByteDance aux îles Caïmans qui permet de maintenir l'opacité et qui ménage la possibilité d'un contrôle par les fondateurs chinois

Soucieux de minimiser le contrôle exercé par les fondateurs de l'entreprise, les dirigeants de TikTok, notamment le PDG M. Shou Zi Chew, insistent régulièrement sur le fait que TikTok est ultimement détenue par la société ByteDance Ltd, immatriculée aux îles Caïmans et dont le capital est détenu par de grands investisseurs institutionnels majoritairement américains. La stratégie sous-jacente est de présenter TikTok comme une société essentiellement internationale, voire américaine, et non chinoise.

Ainsi, interrogé sur ce point, M. Éric Garandeau a corroboré les informations publiquement accessibles sur les membres du Conseil d'administration de ByteDance Ltd. Il s'agit :

- des représentants de trois fonds institutionnels américains :

- M. William Ford, représentant de General Atlantic ;

- M. Arthur Dantchik, représentant de Susquehanna International Group ;

- M. Philippe Laffont, représentant du fonds Coatue Management,

- de M. Neil Shen, représentant du fonds d'investissement chinois Sequoia China ;

- de M. Rubo Liang, PDG de ByteDance Ltd et successeur de son ami M. Zhang Yiming à la tête de l'entreprise.

M. Garandeau a ainsi affirmé lors de son audition que « c'est là qu'est le pouvoir de ByteDance, qui (...) descend jusqu'en bas, jusqu'à TikTok SAS ».

Mettre en avant une transparence exemplaire tout en établissant son siège aux îles Caïmans, paradis des sociétés écrans, relève de l'oxymore

Or, d'une part, les îles Caïmans sont classées deuxième au classement 2021 des paradis fiscaux du réseau international pour la justice. Les îles Caïmans abritent ainsi de nombreuses sociétés offshore en tant que sociétés écrans, non seulement parce que cela permet de bénéficier de conditions fiscales avantageuses, mais aussi et surtout par ce que cela garantit anonymat et opacité. Ainsi, même s'il n'y a là rien de spécifique à TikTok, on peut observer que mettre en avant une transparence exemplaire comme s'y plaisent les représentants de ByteDance, tout en établissant son siège dans le paradis des sociétés écrans (et son siège américain dans le Delaware) relève du paradoxe.

Surtout, il est très probable que comme la plupart des entreprises du secteur du numérique créées en Chine, ByteDance ait un statut de VIE (variable interest entity). Ce statut permet en effet à ces géants du numérique d'accueillir des investissements étrangers tout en garantissant le contrôle des autorités chinoises, qui craignent toujours que ces investisseurs, notamment américains, n'acquièrent un contrôle sur des actifs immatériels chinois. Ce statut permettrait ainsi aux fondateurs, en l'occurrence M. Zhang Yiming et M. Liang Rubo, de contrôler la société malgré le caractère minoritaire de la participation qu'ils détiennent au sein du capital de celle-ci. Or, comme il a été rappelé ci-dessus, non seulement M. Zhang Yiming a fait son autocritique et réaffirmé son intention d'oeuvrer en faveur des autorités chinoises, mais il est également soumis à l'extraterritorialité du droit chinois déjà décrit à propos de Mme Zhao Tian. Il en va de même de M. Liang Rubo, le PDG.

Il faut également souligner que M. Neil Shen, membre du Conseil d'administration de ByteDance Ltd en sa qualité de représentant du fonds d'investissement Sequoïa, fut membre du 13ème comité national de la conférence consultative politique du peuple chinois, un forum qui mêle des officiels du parti et des membres des élites. Il est également vice-président du comité des fonds de capital-risque de l'association de gestion d'actifs de Chine, et directeur du forum d'entrepreneurs « Yabuli China », qui relève de la Fédération chinoise de l'industrie et du commerce.

Ainsi, les liens avec la Chine sont loin d'être coupés au sommet de ByteDance, la maison-mère de TikTok.

b) D'autres mesures prises pour faire apparaître ByteDance comme une entreprise essentiellement internationale

Sans doute en raison de la pression américaine contre l'entreprise, TikTok a nommé une succession de trois PDG extérieurs à la Chine : M. Kevin Mayer, un ancien de Disney, est ainsi devenu PDG en mai 2020 pour 4 mois, puis Mme Vanessa Pappas a fait l'intérim jusqu'à la nomination du singapourien M. Shou Zi Chew. Par ailleurs, l'entreprise se présente comme davantage singapourienne que chinoise, compte-tenu de la nationalité du PDG actuel et de la présence à Singapour des fondateurs M. Zhang Yiming et M. Liang Rubo. Lors de son audition par la commission, M. Éric Garandeau a ainsi souligné que M. Liang Rubo était basé à Singapour.

3. Une séparation fictive entre TikTok et Douyin

Le deuxième axe de la stratégie de TikTok pour se distancer de la Chine, après la présentation de ByteDance comme une entreprise internationale, est de nier tout lien entre TikTok et la branche chinoise de ByteDance. De nombreux éléments montrent au contraire que ces liens restent nombreux.

a) Un changement de nom pour afficher une séparation entre TikTok et Douyin

Avant 2022, il était évident aux yeux de tous les observateurs, et affirmé par les responsables de ByteDance eux-mêmes, que ByteDance Ltd était une entreprise immatriculée aux îles Caïmans mais ayant son siège en Chine, donc essentiellement chinoise. Les multiples filiales de l'entreprise en Chine concentraient ainsi manifestement les actifs les plus précieux de l'entreprise.

Toutefois, en mai 2022 est intervenu un changement important au sein des entreprises du groupe ByteDance : toutes les entités localisées en Chine ont abandonné le nom « ByteDance » pour adopter des noms incluant le terme « Douyin » (le nom de l'application-soeur de TikTok en Chine). Dans une lettre au congrès américain du 30 juin 2022, le PDG de TikTok, M. Shou Zi Chew, a justifié ce changement de nom par la nécessité « d'assurer une meilleure cohérence entre le nom et l'activité de ces entités au sein d'un groupe mondial qui en comporte de nombreuses ». Ce changement de nom des entités localisées en Chine appuie dorénavant le discours des dirigeants de TikTok, qui consiste à mettre en avant une séparation totale des entités de ByteDance en Chine avec les entités du groupe dans le reste du monde, dont TikTok.

Ainsi, lors de son audition par la commission d'enquête, M. Éric Garandeau a déclaré : « en matière d'organisation juridique du groupe, il y a bien une séparation totale entre TikTok et d'autres entités opérant en Chine ». De même, dans les réponses au questionnaire envoyé par la commission d'enquête, les représentants de TikTok ont indiqué que « TikTok n'est pas disponible en Chine continentale, tandis que Douyin n'est pas disponible en dehors de la Chine continentale. Aucune donnée personnelle n'est partagée entre ces deux entités ». Ainsi, les évolutions intervenues récemment en Chine et décrites ci-dessus n'auraient pas d'effet sur TikTok.

Ce raisonnement opère en réalité un glissement sémantique, rendu justement possible par le fait que les entités de ByteDance en Chine ont été rebaptisées Douyin en 2022 : il consiste à dire que, les applications TikTok et Douyin étant séparées (puisque l'application TikTok est interdite en Chine et que l'application Douyin n'existe au contraire qu'en Chine), les entreprises TikTok et Douyin sont également totalement séparées.

Il convient au préalable de relever que si les applications TikTok et Douyin sont effectivement séparées, cette séparation existe pour des raisons qui, en soi, sont regrettables. TikTok, comme les autres grandes plateformes numériques (Facebook, YouTube, Google...) est interdite en Chine car les autorités ne souhaitent pas que la population chinoise ait accès à de l'information libre, et, inversement, Douyin est un média qui n'existe qu'en Chine et qui est totalement censuré par les autorités chinoises. Ce rappel est néanmoins important car il faut observer que les représentants de TikTok, à la différence de ceux des autres plateformes elles aussi interdites en Chine, ne critiquent jamais cet état de fait, ce qu'ils ne manqueraient pas de faire si leur entreprise était réellement totalement indépendante du pouvoir chinois comme ils l'affirment.

Interrogée sur ce point lors de son audition, Mme Marlène Masure, directrice générale opérationnelle de TikTok France, a même refusé, niant l'évidence, de dire si elle savait que TikTok était interdit en Chine et que Douyin était une plateforme censurée. Sur l'interdiction de TikTok en Chine, Mme Marlène Masure a notamment répondu : « je suis pas un expert de la Chine. Donc j'ai beaucoup de mal à répondre à votre question. TikTok interdit dans certains pays, je trouve ça très injuste aussi [il s'agit sans doute d'une allusion à l'interdiction par l'Inde et par le Montana]. Donc oui dans l'absolu, philosophiquement, je suis pour la liberté, pour qu'on offre à tous les utilisateurs du monde entier les mêmes choix. Après il y a probablement des raisons qui me dépassent ». De même, interrogée sur le fait que Douyin soit censurée, Mme Masure a déclaré « j'adore me prononcer sur les sujets que je maîtrise et que je connais. Celui-là je ne le connais pas donc permettez-moi de ne pas émettre un avis (...) Je n'ai jamais ouvert l'application Douyin en fait. Je suis une bonne Française, je suis comme Saint Thomas je crois que ce que je vois, et en l'occurrence l'application je ne l'ai jamais ouverte. Donc je ne sais pas s'il y a de la censure. Franchement je n'ai pas le contexte sur cette interdiction ».

b) L'acquisition d'une « golden share34(*) » par l'État chinois et la revente des parts du fondateur à des investisseurs fantômes

Au cours des années 2021-2022 s'est également déroulée une succession de changements de propriété du capital au sein de la branche chinoise de ByteDance (désormais baptisée Douyin).

Beijing ByteDance Technology Co, une filiale essentielle de ByteDance en Chine créée en mars 2012, donc dès l'origine de ByteDance, devenue Beijing Douyin Information Service Limited, a ainsi vendu une participation de 1 % lors d'une transaction réalisée fin avril (selon Tianyancha, un service de données sur le registre des entreprises chinoises). Les principaux bénéficiaires effectifs de cette participation de 1 % sont l'organisme de contrôle des participations de l'État, China Media Group et la Cyberspace Administration of China (l'autorité de régulation de l'internet en Chine et versant public de la Commission centrale du PCC pour la cybersécurité et l'informatisation). Le PDG de TikTok, M. Shou Zi Chew, dans une lettre adressée aux sénateurs américains, a indiqué que « Beijing Douyin Information Service Limited est une filiale distincte de ByteDance Ltd. Beijing Douyin Information Service Limited, n'a pas de participation directe ou indirecte ni de contrôle dans une entité de TikTok. L'acquisition par l'entreprise d'État chinoise de 1 % de Beijing Douyin Information Service Limited était nécessaire pour obtenir une licence d'information en Chine pour plusieurs contenus basés en Chine, tels que Douyin et Today's Headlines (Toutiao) ».

Consécutivement, un fonctionnaire chinois, M. Wu Shugang, membre de la Cyberspace Administration of China, est devenu membre du conseil d'administration de cette filiale chinoise de ByteDance. M. Wu Shugang est notamment connu pour avoir déclaré dans un tweet publié sur son compte Weibo personnel: « Je n'ai qu'un souhait, celui de pouvoir un jour couper la tête de chien des Chinois libéraux qui défendent les valeurs occidentales. » ainsi que « Que les traîtres chinois qui prêchent les soi-disant « droits de l'homme et la liberté » aillent en enfer ». Selon le Financial Times35(*), en tant que membre du conseil d'administration, M. Wu Shugang a son mot à dire sur la stratégie commerciale et les plans d'investissement, sur les fusions ou acquisitions, l'affectation des bénéfices et sur le vote des trois principaux dirigeants du groupe ainsi que sur leurs rémunérations, comme l'indique la charte de l'entreprise. Il a également le pouvoir de contrôler le contenu des plates-formes médiatiques de ByteDance en Chine, Toutiao et Douyin, et le droit de nommer le « rédacteur en chef » du groupe, qui exerce la censure sur les contenus.

À noter que depuis cette acquisition de ce qui apparaît comme une « golden share» dans ByteDance, les autorités chinoises ont acquis une participation semblable dans les deux autres grandes sociétés chinoises du numérique, Alibaba et Tencent.

Deuxième grand mouvement intervenu au sein de ByteDance, le 18 janvier 2023, quelques mois après avoir démissionné de son poste de PDG de ByteDance, M. Zhang Yiming a vendu toutes ses parts, soit 98,81 %, dans une filiale chinoise de ByteDance, Douyin Co Ltd, à une entreprise, Xiamen Xingchen Qidian Technology (XXQT), créée vingt jours auparavant, le 30 décembre 2022, et dont les deux actionnaires sont totalement inconnus hormis leurs noms qui n'apparaît nulle part ailleurs, ce qui constitue une singularité dans le monde du numérique36(*). La société Douyin Co Ltd possède 99 % de Beijing Douyin Information Service Limited, (les 1 % restant étant désormais, comme on l'a vu ci-dessus, détenus par les autorités chinoises), la filiale essentielle déjà évoquée. Enfin, il apparaît qu'XXQT a immédiatement cédé la totalité de ses parts en nantissement à une filiale de ByteDance, Douyin Vision Co, elle-même détenue à 100 % par une filiale à Hongkong de la maison-mère ByteDance37(*).

Les détails de cette opération, ayant permis à une petite entreprise récemment créée de lever les fonds nécessaires au rachat d'une des principales entités de ByteDance, ne sont pas connus. On sait seulement que XXQT a été fondée à Xiamen, ville dont le jeune Xi Jinping fut vice-maire de 1985 à 1988 avant de commencer son ascension depuis la province du Fujiang, dans laquelle se trouve Xiamen jusqu'au sommet de l'État et du Parti communiste chinois.

c) Des liens évidents entre Douyin et TikTok

(1) Des liens au niveau des technologies et de la propriété intellectuelle

Les deux opérations décrites ci-dessus, intervenues dans la structure de ByteDance, constituent pour les autorités, d'une part, un moyen de mieux superviser les contenus diffusés auprès de la population chinoise, mais aussi et surtout, d'autre part, une nouvelle manière de s'assurer un contrôle accru sur certains actifs dont elles estiment qu'ils ont une importance essentielle.

(a) Des brevets détenus par l'entité pékinoise de ByteDance

Il apparaît en effet que Beijing Douyin Information Service Limited, installée à Pékin, reste le coeur de l'entreprise, toujours détentrice des brevets et des technologies essentielles, ceux-ci étant partagés avec toutes les entités du groupe, dont TikTok.

En effet, la société dans laquelle les autorités ont pris une « golden share » est bien Beijing Douyin Information Service Limited, qui était auparavant appelée Beijing ByteDance Technology Co.