Rapport d'information n° 627 (2021-2022) de MM. Marc-Philippe DAUBRESSE , Arnaud de BELENET et Jérôme DURAIN , fait au nom de la commission des lois, déposé le 10 mai 2022

Disponible au format PDF (1,2 Moctet)

Synthèse du rapport (393 Koctets)

-

AVANT-PROPOS

-

L'ESSENTIEL

-

LISTE DES PROPOSITIONS

-

PREMIÈRE PARTIE

UNE TECHNOLOGIE AUX MULTIPLES FACETTES SOULEVANT DE NOMBREUX ENJEUX DE LIBERTÉ ET DE SOUVERAINETÉ

-

I. LA RECONNAISSANCE FACIALE : UNE TECHNOLOGIE

AUX MULTIPLES FACETTES

-

A. DÉFINITION : UNE TECHNOLOGIE

BIOMÉTRIQUE PROBABILISTE DESTINÉE À L'AUTHENTIFICATION OU

À L'IDENTIFICATION DES INDIVIDUS

-

B. DES CAS D'USAGE MULTIPLES ET POTENTIELLEMENT

ILLIMITÉS

-

1. Les usages facilitant la gestion de

l'identité

-

2. Les usages permettant d'assurer un

contrôle des accès physiques sécurisé et

fluidifié

-

3. L'identification et le suivi des personnes

à des fins de police administrative et judiciaire

-

4. Les autres usages de l'identification des

personnes par reconnaissance faciale

-

1. Les usages facilitant la gestion de

l'identité

-

C. DANS LE MONDE, DES STRATÉGIES

DIVERGENTES

-

A. DÉFINITION : UNE TECHNOLOGIE

BIOMÉTRIQUE PROBABILISTE DESTINÉE À L'AUTHENTIFICATION OU

À L'IDENTIFICATION DES INDIVIDUS

-

II. UN USAGE EMBRYONNAIRE EN FRANCE SANS

ENCADREMENT AD HOC

-

A. UN USAGE ENCORE EMBRYONNAIRE

-

1. Des usages pérennes limités

-

a) Les usages réalisés sans le

consentement des personnes

-

(1) Le « Traitement des

antécédents judiciaires » (TAJ)

-

(2) L'utilisation de la reconnaissance faciale

comme technique de renseignement

-

b) Les usages basés sur le consentement des

personnes

-

(1) PARAFE : un système en voie

d'extension

-

(2) Alicem : un projet d'authentification sur

mobile abandonné

-

a) Les usages réalisés sans le

consentement des personnes

-

2. Des expérimentations à la

marge

-

3. Le projet avorté d'un usage

d'identification à distance à grande échelle pour les

JOP 2024

-

1. Des usages pérennes limités

-

B. UN ENCADREMENT JURIDIQUE BALBUTIANT

-

A. UN USAGE ENCORE EMBRYONNAIRE

-

III. DES ENJEUX FORTS EN TERMES DE LIBERTÉS

PUBLIQUES ET DE SOUVERAINETÉ

-

A. UNE TECHNOLOGIE SUSCEPTIBLE DE PORTER ATTEINTE

À DE NOMBREUSES LIBERTÉS PUBLIQUES

-

1. Les risques liés à la nature et

au recueil des données utilisées par les algorithmes

-

a) La biométrie du visage, une

donnée particulièrement sensible

-

b) La constitution des bases de données

d'apprentissage et de comparaison

-

(1) Des moyens de captation de la donnée de

plus en plus répandus et performants

-

(2) Des données parfois directement

accessibles au public

-

(3) Une disponibilité accrue de la

donnée qui emporte des risques

-

a) La biométrie du visage, une

donnée particulièrement sensible

-

2. Les risques liés à l'emploi de la

reconnaissance faciale

-

a) Une technologie dont l'emploi est susceptible

de porter atteinte à de nombreuses libertés publiques

-

(1) La reconnaissance faciale : une

technologie qui n'est jamais banale

-

(2) Des cas d'usages qui emportent des risques

importants d'atteintes aux libertés publiques

-

b) A maxima, le risque d'une

« société de surveillance »

-

c) Une position incertaine de la

société civile vis-à-vis du déploiement de la

reconnaissance faciale

-

a) Une technologie dont l'emploi est susceptible

de porter atteinte à de nombreuses libertés publiques

-

3. Les risques liés au fonctionnement des

algorithmes de reconnaissance faciale : des questions sur leur

fiabilité qui semblent pouvoir être au moins partiellement

résolues

-

a) Des atteintes potentielles aux libertés

publiques étroitement liées au niveau de fiabilité des

algorithmes

-

b) Des performances des algorithmes qui

progressent rapidement et atteignent, dans des conditions d'emploi optimales,

de très hauts niveaux de fiabilité

-

(1) Des taux d'erreurs résiduels dans des

conditions d'emploi maîtrisées

-

(2) Des résultats en progrès mais

encore perfectibles en présence d'une donnée source de

qualité réduite

-

c) La question des « biais »

des algorithmes : des différentiels de performance

avérés sur certaines catégories de population, qui tendent

toutefois à se réduire

-

(1) Des différentiels de performance

établis de longue date selon le sexe, l'âge et la couleur de

peau

-

(2) Des biais en diminution et qui peuvent dans

une certaine mesure être contenus

-

a) Des atteintes potentielles aux libertés

publiques étroitement liées au niveau de fiabilité des

algorithmes

-

1. Les risques liés à la nature et

au recueil des données utilisées par les algorithmes

-

B. POUR PALLIER CES RISQUES POUR LES

LIBERTÉS PUBLIQUES, L'INDISPENSABLE PROTECTION DE NOTRE

SOUVERAINETÉ TECHNOLOGIQUE

-

A. UNE TECHNOLOGIE SUSCEPTIBLE DE PORTER ATTEINTE

À DE NOMBREUSES LIBERTÉS PUBLIQUES

-

I. LA RECONNAISSANCE FACIALE : UNE TECHNOLOGIE

AUX MULTIPLES FACETTES

-

DEUXIÈME PARTIE

ÉCARTER LE RISQUE D'UNE SOCIÉTÉ DE SURVEILLANCE EN EXPÉRIMENTANT AU CAS PAR CAS

-

I. DÉFINIR COLLECTIVEMENT UN CADRE

COMPRENANT DES LIGNES ROUGES, UNE MÉTHODOLOGIE ET UN RÉGIME DE

REDEVABILITÉ

-

II. RECENTRER LE DÉBAT DU CADRE JURIDIQUE

SUR LES CAS D'USAGE

-

A. DISTINGUER TECHNOLOGIES DE RECONNAISSANCE

BIOMÉTRIQUE ET TECHNOLOGIES CONNEXES

-

B. L'AUTHENTIFICATION BIOMÉTRIQUE EN VUE DE

PERMETTRE UN CONTRÔLE D'ACCÈS SÉCURISÉ

-

C. DISTINGUER, AU SEIN DES DISPOSITIFS

D'IDENTIFICATION BIOMÉTRIQUES, L'IDENTIFICATION EN TEMPS RÉEL DE

CELLE RÉALISÉE A POSTERIORI

-

D. UN USAGE DE LA RECONNAISSANCE

BIOMÉTRIQUE PAR LES ACTEURS PRIVÉS FONDÉ SUR LE

CONSENTEMENT DES USAGERS

-

A. DISTINGUER TECHNOLOGIES DE RECONNAISSANCE

BIOMÉTRIQUE ET TECHNOLOGIES CONNEXES

-

III. RENFORCER LA SOUVERAINETÉ

TECHNOLOGIQUE DE LA FRANCE ET DE L'EUROPE

-

A. LA NÉCESSAIRE CRÉATION D'UN TIERS

DE CONFIANCE EUROPÉEN

-

B. LEVER LES OBSTACLES À LA RECHERCHE ET AU

DÉVELOPPEMENT PAR LA MISE EN PLACE D'UN CADRE JURIDIQUE STABLE ET

SPÉCIFIQUE, ET FACILITER L'ACCÈS AUX JEUX DE DONNÉES POUR

LA RECHERCHE PUBLIQUE

-

C. CONSERVER LA MAÎTRISE TECHNOLOGIQUE DES

ALGORITHMES EN ASSURANT LA TRAÇABILITÉ DES DONNÉES

UTILISÉES ET LA SÉCURITÉ DES INFRASTRUCTURES

D'HÉBERGEMENT

-

A. LA NÉCESSAIRE CRÉATION D'UN TIERS

DE CONFIANCE EUROPÉEN

-

I. DÉFINIR COLLECTIVEMENT UN CADRE

COMPRENANT DES LIGNES ROUGES, UNE MÉTHODOLOGIE ET UN RÉGIME DE

REDEVABILITÉ

-

EXAMEN EN COMMISSION

-

LISTE DES DÉPLACEMENTS

-

LISTE DES PERSONNES ENTENDUES

PAR LA COMMISSION

-

LISTE DES PERSONNES ENTENDUES

PAR LES RAPPORTEURS

-

LISTE DES CONTRIBUTIONS ÉCRITES

-

COMPTE RENDU DE L'AUDITION DE M. CÉDRIC O,

SECRÉTAIRE D'ÉTAT CHARGÉ

DE LA TRANSITION NUMÉRIQUE ET DES COMMUNICATIONS ÉLECTRONIQUES

N° 627

SÉNAT

SESSION ORDINAIRE DE 2021-2022

Enregistré à la Présidence du Sénat le 10 mai 2022

RAPPORT D' INFORMATION

FAIT

au nom de la commission des lois constitutionnelles, de législation, du suffrage universel, du Règlement et d'administration générale sur la reconnaissance faciale et ses risques au regard de la protection des libertés individuelles ,

Par MM. Marc-Philippe DAUBRESSE, Arnaud de BELENET et Jérôme DURAIN,

Sénateurs

(1) Cette commission est composée de : M. François-Noël Buffet , président ; Mmes Catherine Di Folco, Marie-Pierre de La Gontrie, MM. Christophe-André Frassa, Jérôme Durain, Marc-Philippe Daubresse, Philippe Bonnecarrère, Mme Nathalie Goulet, M. Alain Richard, Mmes Cécile Cukierman, Maryse Carrère, MM. Alain Marc, Guy Benarroche , vice-présidents ; M. André Reichardt, Mmes Laurence Harribey, Muriel Jourda, Agnès Canayer , secrétaires ; Mme Éliane Assassi, MM. Philippe Bas, Arnaud de Belenet, Mmes Nadine Bellurot, Catherine Belrhiti, Esther Benbassa, MM. François Bonhomme, Hussein Bourgi, Mme Valérie Boyer, M. Mathieu Darnaud, Mmes Françoise Dumont, Jacqueline Eustache-Brinio, M. Pierre Frogier, Mme Françoise Gatel, MM. Ludovic Haye, Loïc Hervé, Patrick Kanner, Éric Kerrouche, Jean-Yves Leconte, Henri Leroy, Stéphane Le Rudulier, Mme Brigitte Lherbier, MM. Didier Marie, Hervé Marseille, Mme Marie Mercier, MM. Thani Mohamed Soilihi, Jean-Yves Roux, Jean-Pierre Sueur, Mmes Lana Tetuanui, Claudine Thomas, Dominique Vérien, M. Dany Wattebled .

AVANT-PROPOS

Les technologies de reconnaissance biométrique ont été popularisées dans l'imaginaire collectif par de nombreuses fictions. Ainsi, tant George Orwell dans son roman 1984 publié en 1949, que Steven Spielberg dans son film Minority Report sorti en 2002, ont souligné les risques des nouvelles technologies dans l'établissement d'une société de surveillance.

Le débat est désormais particulièrement polarisé entre les tenants d'un moratoire sur les technologies biométriques et ceux qui, à l'inverse, mettent en exergue leurs bénéfices opérationnels tant pour favoriser la sécurité des personnes et des biens que pour apporter un plus grand confort en facilitant un certain nombre d'actes de la vie quotidienne.

Parmi les technologies de reconnaissance biométriques, la reconnaissance faciale concentre l'attention. Le visage, qui conditionne selon Emmanuel Levinas « l'expérience d'autrui », nous appartient en effet en propre tout en étant offert à tous. Le déploiement de la reconnaissance faciale s'effectue cependant sans encadrement juridique spécifique, ni réflexion éthique collective.

Les possibilités d'usage de la reconnaissance faciale sont déterminées, aujourd'hui, par la règlementation relative à la protection des données personnelles. Les usages de cette technologie sont à ce jour limités, car lorsqu'ils ne se basent pas sur le consentement des personnes, ils nécessitent l'adoption d'une disposition législative ou règlementaire particulière. Deux usages développés par les forces de sécurité intérieure peuvent par exemple être cités : le dispositif PARAFE, qui permet des passages frontaliers sur la base d'une authentification biométrique, ou l'introduction d'un module de reconnaissance faciale d'aide à la décision sur le fichier du traitement des antécédents judiciaires (TAJ). Plusieurs expérimentations de la reconnaissance faciale dans les espaces accessibles au public ont par ailleurs été conduites par des acteurs privés sur la base du consentement des personnes, mais aucune d'entre elles n'a été pérennisée. Toutefois, malgré ces emplois marginaux dans l'espace public, la reconnaissance faciale se banalise avec une multiplication d'usages individuels dans la vie quotidienne, comme le déverrouillage de téléphones ou l'ouverture de comptes bancaires.

Il est donc impératif de construire une réponse collective sur l'utilisation de ces technologies, afin de ne pas être, dans les années à venir, dépassés par les développements industriels. C'est la raison pour laquelle la commission des lois du Sénat a créée en son sein une mission d'information sur la reconnaissance faciale, ses risques en matière de surveillance et de libertés publiques, en en désignant rapporteurs Marc-Philippe Daubresse, Arnaud de Belenet et Jérôme Durain.

Après avoir près de 120 personnes et réalisé 4 déplacements, la mission en est arrivée à la conclusion que, compte tenu du changement d'échelle impliqué par ces technologies dans la capacité d'exploitation des images captées dans des espaces accessibles au public, il était impératif qu'un encadrement des technologies biométriques soit réalisé au niveau législatif. Elle a également conclu qu'il fallait, de manière très claire, rejeter le modèle d'une société de surveillance en établissant d'abord des lignes rouges, compte tenu de la multiplicité des cas d'usage de la reconnaissance faciale, potentiellement illimités. Ce n'est qu'une fois ces lignes posées qu'un raisonnement cas d'usage par cas d'usage doit s'imposer, car tous les usages permis par la technologie de reconnaissance faciale ne soulèvent pas les mêmes risques au regard des libertés.

La mission d'information s'est en conséquence prononcée en faveur d'une démarche d'expérimentations permettant :

- en premier lieu, de définir au cas par cas les utilisations des technologies de reconnaissance faciale, et plus généralement biométrique, dans les espaces publics pouvant être acceptables au regard notamment du bénéfice obtenu et des principes de nécessité et de proportionnalité ;

- en second lieu, d'établir un régime de redevabilité et de contrôle adapté, afin notamment d'assurer une information effective des personnes concernées. À défaut, le risque est celui d'une banalisation des technologies biométriques au détriment de l'élaboration d'une réponse collective à leur usage. Leur complexité ainsi que leur constante évolution rendent en effet délicate l'appréhension théorique de ces technologies par les citoyens. Il est donc impératif d'instruire le débat avec le résultat des expériences réalisées au cours des expérimentations.

Parallèlement, il importe d'assurer notre souveraineté technologique afin de renforcer la maîtrise des données de nos concitoyens. Il n'est pas acceptable que l'encadrement de la recherche et développement au niveau français et européen obère l'élaboration de solutions techniques souveraines et conduise les acteurs publics et privés à privilégier des solutions développées à l'étranger, avec des niveaux de contraintes bien moindre. La France et l'Union européenne ont un rôle à jouer dans l'encouragement de technologies de qualité développées de façon éthique.

L'ESSENTIEL

En octobre 2020, la commission des lois du Sénat a créé en son sein une mission d'information sur la reconnaissance faciale, une technologie qui se développe rapidement grâce aux algorithmes d'apprentissage et polarise l'opinion publique entre les tenants d'un moratoire portant sur toutes les technologies biométriques, qui seraient par nature attentatoires aux libertés, et ceux qui mettent en exergue leurs importants bénéfices potentiels.

À l'heure où une législation sur l'intelligence artificielle est en cours d'élaboration au niveau européen, il est indispensable de construire une réponse collective à l'utilisation des technologies de reconnaissance biométrique afin de ne pas être, dans les années à venir, dépassés par les développements industriels.

I. LA RECONNAISSANCE FACIALE : UNE TECHNOLOGIE AUX MULTIPLES FACETTES SOULEVANT DE NOMBREUX ENJEUX DE LIBERTÉ ET DE SOUVERAINETÉ

Parmi les techniques biométriques, qui regroupent l'ensemble des procédés automatisés permettant de reconnaître un individu à partir de la quantification de ses caractéristiques physiques, physiologiques ou comportementales, la reconnaissance faciale vise à reconnaître une personne sur la base des données caractéristiques de son visage .

Elle s'effectue en deux étapes : le visage de la personne est d'abord capté et transformé en un modèle informatique dénommé gabarit , puis ce gabarit est comparé, grâce à l'intelligence artificielle , avec un ou plusieurs autres gabarits afin de vérifier qu'il s'agit bien d'une seule et même personne ou de lui attribuer une identité. On parle dans le premier cas d'authentification et dans le second d'identification .

Les cas d'usage de cette technologie sont potentiellement illimités . Ainsi, sans que cette liste soit exhaustive, la reconnaissance faciale peut permettre de contrôler l'accès et le parcours des personnes pour les évènements ou locaux sensibles, d'assurer la sécurité et le bon déroulement d'évènements à forte affluence ou d'aider à la gestion des flux dans les lieux et environnements nécessitant une forte sécurisation.

En France, les usages pérennes dans les espaces accessibles au public sont extrêmement limités . Il s'agit pour l'essentiel du dispositif de rapprochement par photographie opéré dans le Traitement des antécédents judiciaires (TAJ) et du système PARAFE permettant une authentification sur la base des données contenues dans le passeport lors des passages aux frontières extérieures . Plusieurs expérimentations ont par ailleurs été menées, par la Ville de Nice ou Aéroports de Paris notamment, mais aucune d'entre elles n'a pour l'instant été pérennisée.

Les questions que pose le déploiement de la reconnaissance faciale sont nombreuses . Elles ont trait tant aux libertés publiques qu'à la souveraineté technologique de la France, les deux thématiques étant interdépendantes.

Dans ce contexte, il est surprenant que la reconnaissance faciale, et plus largement les techniques de reconnaissance biométrique, ne fasse pas l'objet d'un encadrement ad hoc . Elles sont actuellement exclusivement régies par le droit des données personnelles .

S'agissant de données « sensibles » au sens du règlement général sur la protection des données (RGPD), les données biométriques font l'objet d'une interdiction de traitement . Sur la base du RGPD, ces traitements ne peuvent être mis en oeuvre que par exception dans certains cas particuliers : avec le consentement exprès des personnes , pour protéger leurs intérêts vitaux ou sur la base d'un intérêt public important . Sur la base de la directive « Police-justice », ces traitements ne peuvent être réalisés par les autorités publiques compétentes qu'en cas de nécessité absolue et sous réserve de garanties appropriées pour les droits et libertés de la personne concernée.

II. ÉCARTER LE RISQUE D'UNE SOCIÉTÉ DE SURVEILLANCE EN EXPÉRIMENTANT AU CAS PAR CAS

A. DÉFINIR COLLECTIVEMENT UN CADRE COMPRENANT DES LIGNES ROUGES, UNE MÉTHODOLOGIE ET UN RÉGIME DE REDEVABILITÉ

a) Des lignes rouges écartant le risque d'une société de surveillance

Les rapporteurs considèrent qu'il est indispensable de fixer dans la loi quatre interdictions applicables aux acteurs publics comme privés :

- interdiction de la notation sociale . Cette interdiction irait au-delà de celle proposée par la Commission européenne dans le règlement sur l'intelligence artificielle puisque cette dernière ne s'intéresse qu'aux acteurs publics. Il est en effet nécessaire de protéger les consommateurs de méthodes commerciales intrusives et d'empêcher le recours à la notation sociale par surveillance de leurs comportements dans les espaces de vente, de restauration ou les centres de loisirs ;

- interdiction de la catégorisation d'individus en fonction de l'origine ethnique, du sexe, ou de l'orientation sexuelle , sauf dans le cadre de la recherche scientifique et sous réserve de garanties appropriées ;

- interdiction de l'analyse d'émotions , sauf à des fins de santé ou de recherche scientifique et sous réserve de garanties appropriées ;

- interdiction de la surveillance biométrique à distance en temps réel dans l'espace public , sauf exceptions très limitées au profit des forces de sécurité ; en particulier, cette interdiction porterait sur la surveillance biométrique à distance en temps réel lors de manifestations sur la voie publique et aux abords des lieux de culte .

Les rapporteurs préconisent également de poser trois principes généraux :

- le principe de subsidiarité, pour que la reconnaissance biométrique ne soit utilisée que lorsqu'elle est vraiment nécessaire ;

- le principe d'un contrôle humain systématique afin qu'il ne s'agisse que d'une aide à la décision ;

- et le principe de transparence pour que l'usage des technologies de reconnaissance biométrique ne se fasse pas à l'insu des personnes.

b) Une méthodologie claire : la voie expérimentale dans le cadre d'une loi

La mission est favorable à l'adoption d'une loi d'expérimentation pour créer le débat et déterminer les usages de la reconnaissance biométrique qui pourraient être pertinents et efficaces. L'expérimentation pourrait être autorisée pour une période de trois ans , ce qui obligerait le Gouvernement et le Parlement à réévaluer le besoin et recadrer le cas échéant le dispositif en fonction des résultats obtenus.

Pour que cette phase d'expérimentation soit utile, serait mise en place une évaluation publique et indépendante pour connaître l'efficacité de la technologie dans le cas d'usage testé. Elle serait conduite par un comité composé de scientifiques et de spécialistes des questions éthiques dont les rapports seraient rendus publics .

Pour que les Français s'emparent du sujet en étant suffisamment à même d'en comprendre les différents enjeux, il est préconisé de rendre accessible une information claire sur les techniques de reconnaissance biométrique , les bénéfices qui en sont attendus et les risques encourus.

c) Un régime de contrôle a priori et a posteriori

La mission souhaite que les usages soient autorisés a priori . En cas d'utilisation par les forces de sécurité intérieure , l'autorisation relèverait soit d'un magistrat, soit du préfet , selon qu'on s'insère dans un cadre de police judiciaire ou de police administrative. En cas de déploiement par un acteur privé dans un lieu accessible au public, la CNIL serait compétente.

La CNIL serait systématiquement consultée pour tout déploiement : pour les usages publics, parce que les analyses d'impact devraient impérativement lui être transmises pour avis, et pour les usages privés, parce qu'elle aurait à délivrer l'autorisation préalable.

Ces différentes autorisations feraient l'objet d'un recensement national pour garder une vision globale du recours aux techniques de reconnaissance biométrique, quelle que soit l'autorité ayant délivré l'autorisation.

Enfin, le pouvoir de contrôle de la CNIL serait réaffirmé afin qu'elle exerce son rôle de gendarme de la reconnaissance biométrique , qu'elle mène des contrôles a posteriori du bon usage des dispositifs et des éventuels détournements de finalité en dehors de l'autorisation. Dans ce cadre, les rapporteurs rappellent l'importance de lui accorder les moyens humains, financiers et institutionnels adéquats.

B. RECENTRER LE DÉBAT DU CADRE JURIDIQUE SUR LES CAS D'USAGE

a) Autoriser, à titre expérimental, le traitement des images à l'aide de l'intelligence artificielle dans le cadre des finalités attribuées au dispositif de vidéoprotection déployé

Les cas d'usage de la reconnaissance faciale étant multiples et potentiellement illimités, un raisonnement cas d'usage par cas d'usage s'impose , prenant en considération les finalités poursuivies par chacun d'entre eux. Plusieurs distinctions doivent ainsi être opérées, les risques pour les libertés étant dans une large mesure conditionnées par celles-ci.

Les dispositifs de traitement des images sans utilisation de données biométriques se multiplient . Il peut s'agir de dispositifs de suivi ou de traçage, de détection d'évènements suspects ou d'objets abandonnés, ou de caractérisation de personnes filmées. À ce jour cependant, les traitements des images issues de la voie publique en s'appuyant sur l'intelligence artificielle ne disposent pas d'un cadre juridique propre . Il y a donc un débat sur la possibilité de les déployer. Certaines communes ont d'ores et déjà mis en place des systèmes de détection automatique des dépôts sauvages d'ordures, par exemple.

Les rapporteurs considèrent que l'application de l'intelligence artificielle aux images issues de la vidéoprotection constitue un changement d'échelle dans l'exploitation de la vidéoprotection ce qui, étant susceptible de porter atteintes aux libertés individuelles, nécessite une base législative explicite . Cette base est d'autant plus urgente que le déploiement de systèmes de détection de colis abandonnés ou de mouvements suspects dans une foule sera nécessaire pour assurer la sécurité au moment des Jeux Olympiques de 2024.

Il est donc proposé d'établir, à titre expérimental , une base législative qui permettrait aux opérateurs des systèmes de vidéoprotection dans les espaces accessibles au public de mettre en oeuvre des traitements d'images par intelligence artificielle , sans traitement de données biométriques. Ces traitements devraient s'inscrire dans les missions des personnes publiques et privées concernées et, surtout, dans les finalités attribuées au dispositif de vidéoprotection déployé .

b) L'authentification biométrique en vue de permettre un contrôle d'accès sécurisé

S'agissant des logiciels de reconnaissance biométrique, notamment à partir de la biométrie du visage, une distinction doit être effectuée entre authentification et identification.

L'authentification biométrique, qui permet un contrôle sécurisé et fluidifié des accès, est plus propice au recueil du consentement de la personne, tout en constituant un système moins intrusif , car celui-ci peut dans certains cas être construit de façon à ce que le fournisseur de technologie n'ait pas accès aux données biométriques des personnes. Ainsi, dans le cadre français et européen actuel, des cas d'usage ont été mis en oeuvre sur la base du consentement des personnes.

La mission propose de donner une base légale à ces dispositifs imposant aux personnes souhaitant les mettre en place de nombreuses garanties permettant, d'une part, d' évaluer l'impact du dispositif et, d'autre part, de s'assurer du caractère libre, spécifique, éclairé et univoque du consentement donné .

Dans certains cas très particuliers et à titre expérimental, ces dispositifs pourraient également être rendus possibles de manière obligatoire, pour accéder à des zones nécessitant une sécurisation exceptionnelle.

c) L'identification biométrique, a posteriori ou en temps réel

Les opérations d'identification biométriques doivent, quant à elles, faire l'objet d'un encadrement extrêmement strict au regard des risques encourus et être proportionnées aux modalités d'usages, qu'il s'agisse d'une exploitation en temps réel , c'est-à-dire dans le cadre d'un processus permettant un usage immédiat des résultats pour procéder à un contrôle de la personne concernée, ou d'une utilisation a posteriori , par exemple dans le cadre d'une enquête. Dans ce second cas, les recherches se font généralement sur des enregistrements.

S'agissant d'abord de l' identification a posteriori , la mission propose :

- en premier lieu, de permettre une utilisation de la biométrie dans les fichiers de police, dans le cadre d'enquêtes judiciaires ou d'opérations de renseignement . Il s'agit d'un moyen de fiabilisation et d'opérationnalisation des fichiers, dont le mouvement est déjà enclenché au niveau européen ;

- en deuxième lieu, d'autoriser à titre expérimental et de manière subsidiaire, uniquement pour la recherche d'auteurs ou de victimes potentielles des infractions les plus graves , l'exploitation a posteriori d'images sous le contrôle du magistrat en charge de l'enquête ou de l'instruction ;

- en troisième lieu, de créer une technique de renseignement donnant aux services la possibilité d'utiliser des systèmes de reconnaissance faciale afin d'identifier une personne recherchée ou de reconstituer son parcours a posteriori . Un tel usage se révèlerait en particulier pertinent dans le cadre de la mission de prévention de toute forme d'ingérence étrangère, aux fins de détecter la présence sur le sol national d'agents de services étrangers qui entrent en France sous une fausse identité.

S'agissant ensuite de l' identification biométrique à distance en temps réel , les rapporteurs insistent sur leur volonté de lui conserver un caractère particulièrement exceptionnel . Sur leur proposition, la mission n'a donc prévu son déploiement que par exception, dans trois cas très spécifiques et circonscrits :

- dans le cadre d'enquêtes judiciaires , en vue de permettre, d'une part, le suivi d'une personne venant de commettre une infraction grave à partir des images issues de la vidéoprotection afin de faciliter son l'interpellation et, d'autre part, la recherche dans un périmètre géographique et temporel limité, des auteurs d'infractions graves recherchés par la justice ou des personnes victimes d'une disparition inquiétante . Les infractions concernées pourraient par exemple être limitées aux crimes menaçant ou portant atteinte à l'intégrité physique des personnes ;

- dans un cadre administratif , en vue de sécuriser de grands évènements présentant une sensibilité particulière ou les sites particulièrement sensibles face à une éventuelle menace terroriste . La détection ne pourrait se faire que sur un périmètre géographique limité et pour une période précisément déterminée ;

- dans un cadre de renseignement , en cas de menaces imminentes pour la sécurité nationale .

Ces déploiements devront en outre être entourés de solides garanties , notamment :

- la nécessité d'une autorisation et d'un contrôle d'une autorité, distincte en fonction des usages (magistrat, préfet ou Commission nationale de contrôle des techniques de renseignement) ;

- le caractère strictement subsidiaire de ces usages ;

- la traçabilité des usages ;

- la systématicité d'une supervision humaine, les technologies étant cantonnées à un rôle d'aide à la décision ;

- une information du public adaptée aux spécificités du déploiement.

d) Un usage de la reconnaissance biométrique par les acteurs privés fondé sur le consentement des usagers

S'agissant enfin des usages des technologies de reconnaissance biométrique par les acteurs privés , les rapporteurs considèrent qu'ils doivent être extrêmement limités et se baser, de manière générale, sur le consentement des personnes. En particulier, la mission souhaite interdire toute identification sur la base de données biométriques en temps réel ou en temps différé par des acteurs privés.

C. RENFORCER LA SOUVERAINETÉ TECHNOLOGIQUE DE LA FRANCE ET DE L'EUROPE

Les rapporteurs considèrent qu'en matière de reconnaissance biométrique, la protection de notre autonomie technologique et la sauvegarde des libertés publiques sont les deux faces d'une même médaille . L'usage d'algorithmes développés en Europe, à partir de données traçables et hébergées sur notre sol est par exemple largement préférable au recours à des algorithmes étrangers dont l'on ne sait parfois rien des conditions de création et d'entraînement.

Si la France dispose d'un écosystème de recherche et de développement très performant dans le champ de la reconnaissance biométrique, force est de constater que les acteurs du secteur évoluent dans un cadre juridique et matériel peu propice à la recherche et au développement . Ainsi, la mission d'information a identifié deux obstacles principaux :

- un cadre juridique applicable à la recherche et au développement particulièrement complexe , si bien que les acteurs du secteur n'arrivent pas toujours à distinguer ce qui est autorisé de ce qui ne l'est pas ;

- la difficile constitution des jeux de données destinés à l'apprentissage des algorithmes : l'obligation de recueillir le consentement de chaque personne figurant dans la base pour chaque projet de recherche rend très difficile la création de ce matériel. Cela est même quasiment impossible pour des laboratoires de recherche publique.

Pour renforcer la souveraineté technologique de l'Europe, les rapporteurs préconisent de confier à une autorité européenne la mission d'évaluer la fiabilité des algorithmes de reconnaissance biométrique et de certifier leur absence de biais , sur le modèle de ce qui existe déjà aux États-Unis. Il s'agit de réduire notre dépendance à l'extérieur sur cette mission d'apparence technique mais en réalité cruciale en termes de protection des libertés. Pour donner à cette autorité les moyens de son action, une base d'images à l'échelle de l'Union européenne pourrait être créée et alimentée, sous réserve de garanties appropriées, par la réutilisation de données détenues par les administrations des États membres ou par des contributions altruistes.

Pour lever les obstacles à la recherche et au développement, les rapporteurs plaident également pour l'établissement d'un cadre juridique spécifique et adapté à cette activité . Cela se traduirait, dans le respect des garanties prévues par le RGPD, par des assouplissements des modalités pratiques de recueil du consentement ou bien par des mécanismes sécurisés de mise à disposition de données biométriques détenues par l'État aux seuls laboratoires de recherche publique. Ce cadre juridique dérogatoire devrait être accompagné de fortes garanties. À titre d'exemple, cette réutilisation de données publiques serait subordonnée à un avis favorable de la CNIL.

LISTE DES PROPOSITIONS

I. DÉFINIR COLLECTIVEMENT UN CADRE COMPRENANT DES LIGNES ROUGES, UNE MÉTHODOLOGIE ET UN RÉGIME DE REDEVABILITÉ

1. Réaliser une enquête nationale visant à évaluer la perception de la reconnaissance biométrique par les Français, à cerner les cas d'usages auxquels ils se montrent plus ou moins favorables et à identifier les ressorts d'une meilleure acceptabilité de cette technologie.

Des lignes rouges écartant le risque d'une société de surveillance

2. Fixer dans la loi les cas où le développement, la mise sur le marché et l'utilisation de techniques de reconnaissance biométrique sont interdites, qu'elles soient mises en oeuvre par des acteurs publics ou privés. En particulier :

- les systèmes de notation sociale des personnes ;

- les systèmes de catégorisation des personnes selon une origine, des convictions religieuses ou philosophiques ou une orientation sexuelle, sauf à des fins de recherche scientifique et sous réserve de garanties appropriées ;

- les systèmes de reconnaissance d'émotions, sauf à des fins de santé ou de recherche scientifique et sous réserve de garanties appropriées.

3. D'une manière générale, interdire l'utilisation de la reconnaissance biométrique à distance en temps réel dans l'espace public, sauf exceptions très limitées (voir la proposition n° 22) ; en particulier, interdire clairement la surveillance biométrique à distance en temps réel lors de manifestations sur la voie publique et aux abords des lieux de culte.

4. Appliquer systématiquement le principe de subsidiarité et en particulier, conditionner le recours sans consentement à la reconnaissance biométrique à la démonstration d'un impératif particulier d'assurer un haut niveau de fiabilité de l'authentification ou de l'identification des personnes concernées et la démonstration de l'inadéquation d'autres moyens de sécurisation moins intrusifs.

5. Cantonner le recours aux algorithmes et à la technologie d'identification par reconnaissance biométrique, lorsqu'elle est déployée par exception, à un rôle d'aide à la décision et prévoir un contrôle humain systématique.

6. Assurer la transparence de l'usage de technologies de reconnaissance biométrique à l'égard des personnes par la fourniture d'informations claires, compréhensibles et aisément accessibles.

Une méthodologie claire : la voie expérimentale dans le cadre d'une loi

7. Fixer dans une loi d'expérimentation, pour une période de trois ans, les conditions dans lesquelles et les finalités pour lesquelles la reconnaissance biométrique pourra faire l'objet de nouvelles expérimentations par les acteurs publics ou dans les espaces ouverts au public et prévoir la remise de rapports annuels détaillés au Parlement sur son application, dont le dernier au plus tard six mois avant la fin de la période d'expérimentation.

8. Soumettre ces expérimentations à l'évaluation régulière d'un comité scientifique et éthique unique et indépendant dont les rapports seront rendus publics.

9. En accompagnement de ces expérimentations, apporter une information accessible à tous sur les techniques de reconnaissance biométrique, les bénéfices qui en sont attendus et les risques encourus afin de sensibiliser le public sur leurs enjeux.

Un régime de contrôle a priori et a posteriori

10. Soumettre le déploiement des technologies de reconnaissance biométrique par les pouvoirs publics à l'autorisation du préfet en matière de police administrative ou d'un magistrat en matière de police judiciaire.

11. Soumettre le déploiement des technologies de reconnaissance biométrique par les acteurs privés dans les espaces accessibles au public à l'autorisation de la Commission nationale de l'informatique et des libertés (CNIL).

12. Prévoir le recensement au niveau national des actes autorisant le déploiement des technologies de reconnaissance biométrique.

13. Renforcer les moyens de la CNIL afin qu'elle puisse, le cas échéant avec l'assistance du Pôle d'expertise de la régulation numérique (PEReN), assurer le suivi du déploiement des techniques de reconnaissance biométrique, détecter d'éventuels détournements de finalité ou des usages illégaux de ces technologies et sanctionner les contrevenants.

II. RECENTRER LE DÉBAT DU CADRE JURIDIQUE SUR LES CAS D'USAGE

Distinguer technologies de reconnaissance biométrique et technologies connexes

14. Autoriser, à titre expérimental, l'usage de traitements d'images issues des espaces accessibles au public à l'aide de l'intelligence artificielle sans utilisation de données biométriques dans le cadre des finalités attribuées au dispositif de vidéoprotection déployé, après autorisation du préfet territorialement compétent et consultation, le cas échéant, de la CNIL. Assurer l'information du public.

15. Prévoir les conditions dans lesquelles le droit d'opposition des personnes concernées peut être écarté lors du déploiement de dispositifs de traitements d'images provenant d'espaces accessibles au public n'impliquant pas des données sensibles à des fins de traitement statistiques d'un groupe de personnes.

L'authentification biométrique en vue de permettre un contrôle d'accès sécurisé

16. Créer, à titre expérimental, un cadre juridique permettant l'usage de technologies d'authentification biométrique pour sécuriser l'accès à certains évènements et fluidifier les flux, sur la base du consentement des personnes. Accompagner l'ouverture de cette possibilité de fortes garanties, comprenant notamment :

- la réalisation d'une étude d'impact justifiant l'intérêt de cette technologie ainsi que les mesures de protection des données personnelles mises en oeuvre, notamment en matière de sécurisation des systèmes informatiques ;

- les modalités de recueil du consentement des personnes concernées ;

- l'obligation de maintenir une alternative valable à l'usage de l'authentification biométrique ;

- l'absence de conservation des images collectées et analysées des personnes se présentant au contrôle d'accès ;

- le maintien d'un contrôle humain.

17. Tout en conservant le principe d'une interdiction de l'usage de la biométrie pour l'accès à certains lieux sans alternative non biométrique, permettre, à titre expérimental, aux acteurs étatiques, dans l'organisation de grands évènements, d'organiser par exception un contrôle exclusivement biométrique de l'accès aux zones nécessitant une sécurisation exceptionnelle.

Distinguer, au sein des dispositifs d'identification biométriques, l'identification en temps réel de celle réalisée a posteriori

18. Mettre en place, par la prise de décrets en Conseil d'État, la possibilité pour les forces de sécurité nationales d'interroger à l'occasion d'une enquête judiciaire ou dans un cadre de renseignement certains fichiers de police par le biais d'éléments biométriques. Opérer, par ce biais, une fiabilisation des fichiers concernés pour éviter les identités multiples.

19. Évaluer l'efficacité des modules de reconnaissance faciale dans le Traitement des antécédents judiciaires (TAJ) ainsi que, le cas échéant, dans les autres fichiers de police où un tel module serait mis en place.

20. Permettre, à titre expérimental, de manière subsidiaire et uniquement pour la recherche d'auteurs ou de victimes potentielles des infractions les plus graves, l'exploitation a posteriori d'images se rapportant à un périmètre spatio-temporel limité par le biais de logiciels de reconnaissance biométrique, sous le contrôle du magistrat en charge de l'enquête ou de l'instruction.

21. Autoriser, à titre expérimental, les services spécialisés de renseignement à traiter a posteriori les images issues de la voie publique à l'aide de systèmes de reconnaissance biométrique, dans le cadre des seules finalités mentionnées aux 1°, 2°, 4° et 5° de l'article L. 811-3 du code de la sécurité intérieure.

22. Créer un cadre juridique expérimental permettant, par exception et de manière strictement subsidiaire, le recours ciblé et limité dans le temps à des systèmes de reconnaissance biométrique sur la voie publique en temps réel sur la base d'une menace préalablement identifiée, à des fins de sécurisation des grands évènements et de sites sensibles face à une menace terroriste, pour faire face à une menace imminente pour la sécurité nationale, et à des fins d'enquête judiciaire relatives à des infractions graves menaçant ou portant atteinte à l'intégrité physique des personnes. Ce système devrait être strictement encadré, les garanties prévues incluant notamment :

- le caractère strictement subsidiaire du déploiement de cette technologie ;

- un déploiement du dispositif autorisé a priori et contrôlé a posteriori par une autorité adaptée à la finalité du traitement (magistrat, préfet, CNCTR), dans un périmètre spatiotemporel rigoureusement délimité ;

- en matière de police administrative, un nombre de caméras proportionné pouvant être utilisées dans ce cadre ;

- une minimisation des données utilisées et leur sécurisation ;

- une supervision humaine systématique ;

- une traçabilité des usages ;

- une information du public adaptée aux spécificités du déploiement et, en tout état de cause, une information générale réalisée par le Gouvernement.

Un usage de la reconnaissance biométrique par les acteurs privés fondé sur le consentement des usagers

23. Interdire tout usage privé des technologies de reconnaissance biométrique ne requérant pas le consentement des utilisateurs, à l'exception, dans quelques rares cas particuliers et dûment justifiés, de traitements pour contrôler l'accès aux lieux et aux outils de travail (accès à des zones ou à des produits nécessitant un niveau de protection particulièrement élevé).

III. RENFORCER LA SOUVERAINETÉ TECHNOLOGIQUE DE LA FRANCE ET DE L'EUROPE

La nécessaire création d'un tiers de confiance européen

24. Dans le cadre des négociations sur la législation européenne sur l'intelligence artificielle, promouvoir la création d'une autorité européenne ayant pour mission l'évaluation de la fiabilité des algorithmes de reconnaissance biométrique et la certification de leur absence de biais.

Assurer l'indépendance et la qualité de l'évaluation en garantissant la diversité des données qui y sont contenues et en ayant recours à la méthodologie des « données séquestrées », où les développeurs n'ont accès à la base de données ni pour l'entrainement des algorithmes ni pour la phase de test.

Mettre à disposition de l'autorité en charge de l'intelligence artificielle une base d'images à l'échelle de l'Union européenne afin de lui donner les moyens de son action. Alimenter cette base à travers plusieurs mécanismes s'inspirant de la proposition de règlement de l'Union européenne sur la gouvernance européenne des données.

Mettre en place des mécanismes adaptés d'information des citoyens et prévoir la possibilité de demander à tout moment le retrait de ses données de la base.

Lever les obstacles à la recherche et au développement par la mise en place d'un cadre juridique stable et spécifique, et faciliter l'accès aux jeux de données pour la recherche publique

25. Créer un cadre juridique spécifique et adapté à la recherche et au développement visant notamment à autoriser, sous réserve d'une déclaration préalable à la CNIL, la réutilisation de données par l'intermédiaire de recueils de consentement groupés.

26. Formaliser la doctrine de la CNIL sur la recherche et le développement en matière de reconnaissance biométrique au sein d'un document unique à destination des développeurs.

27. Anticiper l'adoption du règlement sur la gouvernance européenne des données en autorisant, sous réserve d'un avis favorable de la CNIL, la mise à disposition de données publiques biométriques à des fins de recherche publique sur la reconnaissance biométrique.

Imposer que la mise à disposition se fasse dans un environnement de traitement sécurisé fourni par l'État et sans possibilité d'en exporter les données.

28. Mettre en place au sein de l'État, un service dédié à l'accompagnement des demandes de réutilisation de données publiques de la part des acteurs de la recherche en reconnaissance biométrique.

Conserver la maîtrise technologique des algorithmes en assurant la traçabilité des données utilisées et la sécurité des infrastructures d'hébergement

29. Créer un dispositif de labellisation des logiciels de reconnaissance biométrique, en prenant notamment en compte l'origine et la traçabilité des données d'apprentissage.

30. Prévoir un contrôle régulier par l'Agence nationale de la sécurité des systèmes d'information (ANSSI) de la sécurité des infrastructures d'hébergement des données biométriques utilisées par la puissance publique à des fins expérimentales.

PREMIÈRE

PARTIE

UNE TECHNOLOGIE AUX MULTIPLES FACETTES SOULEVANT DE NOMBREUX

ENJEUX DE LIBERTÉ ET DE SOUVERAINETÉ

I. LA RECONNAISSANCE FACIALE : UNE TECHNOLOGIE AUX MULTIPLES FACETTES

A. DÉFINITION : UNE TECHNOLOGIE BIOMÉTRIQUE PROBABILISTE DESTINÉE À L'AUTHENTIFICATION OU À L'IDENTIFICATION DES INDIVIDUS

1. La reconnaissance faciale : une technologie biométrique informatique et probabiliste de reconnaissance des visages

Au cours des dernières années, le déploiement de dispositifs biométriques s'est fortement accéléré en France et en Europe. Cette accélération est principalement due aux avancées des algorithmes d'apprentissage sur lesquels s'appuient ces technologies, dont la puissance de calcul permet désormais une exploitation massive de grands ensembles de données .

Parmi les techniques biométriques, qui regroupent l'ensemble des procédés automatisés permettant de reconnaître un individu à partir de la quantification de ses caractéristiques physiques, physiologiques ou comportementales (empreintes digitales, iris, etc .) 1 ( * ) , la reconnaissance faciale vise à reconnaître une personne sur la base des données caractéristiques de son visage . Depuis son invention dans les années 1970, la reconnaissance faciale a énormément progressé et s'impose aujourd'hui comme une technologie mature permettant d'identifier ou de reconnaître une personne en s'appuyant sur les spécificités biométriques de son visage.

Données biométriques

Le règlement général sur la protection des données qualifie, dans son article 4-14, les données biométriques comme les « données à caractère personnel résultant d'un traitement technique spécifique, relatives aux caractéristiques physiques, physiologiques ou comportementales d'une personne physique, qui permettent ou confirment son identification unique, telles que des images faciales ou des données dactyloscopiques ».

Ces données sont considérées comme des données sensibles au sens de l'article 9 du RGPD.

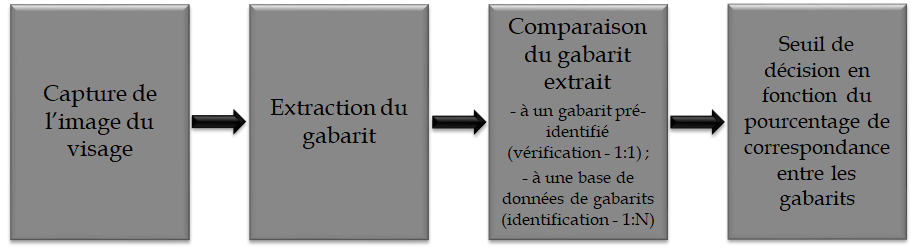

La reconnaissance faciale - ou reconnaissance à partir de la biométrie du visage - s'opère en deux étapes :

- d'abord, la collecte du visage et sa transformation en un gabarit : sur la base d'une image du visage de la personne, qui peut être recueillie à partir d'une photographie ou d'une vidéo, le logiciel de biométrie du visage extrait un modèle représentant d'un point de vue informatique certaines caractéristiques de ce visage. Ce modèle, dénommé « gabarit », est considéré comme unique et propre à chaque personne et est en principe permanent dans le temps ;

- ensuite, la reconnaissance de ce visage par comparaison du gabarit correspondant avec un ou plusieurs autres gabarits , préalablement réalisés ou calculés en direct à partir d'une image, photographie ou vidéo. Cette comparaison permet de déterminer si les gabarits concernés correspondent à une même personne.

La reconnaissance d'une personne à partir de la biométrie du visage est une technique probabiliste , car les résultats de comparaison entre les gabarits sont exprimés en pourcentage de correspondance. Si ce pourcentage dépasse un seuil déterminé par le système, celui-ci va considérer qu'il y a correspondance.

Source : Commission des lois du Sénat

2. Deux finalités : l'authentification et l'identification d'une personne

Comme toute technique biométrique, la reconnaissance faciale peut remplir deux fonctions distinctes.

L'authentification (ou la vérification) tout d'abord, qui consiste à vérifier qu'une personne est bien celle qu'elle prétend être . Le système compare alors un gabarit biométrique préenregistré avec celui extrait du visage de la personne concernée au moment du besoin d'identification, afin de vérifier que les deux gabarits correspondent. Il s'agit donc d'une comparaison « 1 contre 1 » . Cet usage vise à répondre à la question : « la personne qui se présente est-elle bien M. Untel ? ». C'est par exemple la technique utilisée lorsqu'un usager déverrouille son smartphone à partir de son visage.

L'identification ensuite, qui vise à retrouver une donnée biométrique parmi celles extraites de plusieurs personnes au sein d'une base de données . La comparaison effectuée est une comparaison « 1 contre N » , un gabarit avec une base de données de gabarits. Le système restitue alors un ensemble de correspondances candidates. Cet usage vise à répondre à la question : « qui est cette personne ? ». L'objectif poursuivi est de retrouver une personne au sein d'un groupe d'individus filmés dans un lieu, figurant sur une image ou dont la photographie est présente dans une base de données. Il permet par exemple de lier un état civil à un visage ou de suivre la trajectoire d'une personne dans une foule.

Le stockage des gabarits biométriques :

un élément distinctif des technologies de reconnaissance

faciale

Un autre élément à prendre en compte lors de l'étude des systèmes utilisant la biométrie du visage est constitué par les modalités de stockage des données biométriques. Trois modalités de stockage se distinguent :

- le gabarit biométrique de la personne est stocké sur un support dont elle a la maîtrise exclusive (passeport, badge, carte à puce, smartphone) - dit « gabarit de type 1 » ;

- le gabarit biométrique est sous maîtrise partagée : il est stocké au sein d'une base de données locale mais nécessite pour être exploité l'utilisation d'un « secret » détenu par la personne concernée (code personnel, par exemple) - dit « gabarit de type 2 » ;

- le gabarit biométrique non maîtrisé par la personne concernée est stocké sur une base de données et ne nécessite pas l'utilisation d'un « secret » par la personne concernée pour être exploité - dit « gabarit de type 3 ».

Source : Commission des lois du Sénat

3. Un sous-ensemble des systèmes de traitement d'images par intelligence artificielle

La reconnaissance faciale ne doit pas être confondue avec les systèmes de traitements d'images grâce à l'intelligence artificielle . Quatre niveaux de technologie permettent d'apporter une aide algorithmique au traitement d'une image ou d'une succession d'images, la reconnaissance biométrique n'en constituant que le quatrième niveau.

Un premier niveau permet de détecter la présence d'un objet ou d'une personne dans une image sans en déterminer sa nature , par comparaison avec une image de référence ou une image immédiatement antérieure. À titre d'exemple, la gendarmerie nationale utilise depuis 2017 un outil permettant d'exploiter a posteriori une vidéo de longue durée en filtrant les séquences au cours desquelles l'image est fixe.

Un deuxième niveau permet de reconnaître des catégories , par exemple la détection de types d'objets ou de piétons. Aucun élément supplémentaire sur les caractéristiques ou l'identité des personnes n'est alors rendu disponible. À titre d'exemple, le tournoi de tennis de Roland-Garros en 2020 a été l'occasion d'expérimenter le comptage de personnes présentes dans une file d'attente sur une voie privatisée ou dans une tribune et la détection de mouvements anormaux de foule. Un second exemple est constitué par l'expérimentation menée par la direction de l'ordre public et de la circulation (DOPC) de la préfecture de police de Paris permettant de détecter des types de véhicules circulant sans autorisation dans les couloirs de bus : ce système constitue une aide à la décision, dans lequel l'ensemble des opérations conduisant à une verbalisation reste décidé et réalisé par un agent de circulation. Peuvent également être cités la détection de comportements suspects, d'intrusions, de vols ou d'objets spécifiques.

Un troisième niveau permet d'identifier une personne ou un objet à partir de ses caractéristiques non biométriques , sans attacher à la personne une identité. Ces technologies permettent par exemple de suivre un individu dans une foule à partir de son habillement, comme a pu le faire par exemple la SNCF dans le cadre d'une expérimentation d'aide au suivi des personnes non-biométrique (projet PREVIENS).

Un quatrième niveau , qui inclut la reconnaissance faciale, vise à reconnaître un individu à partir de ses caractéristiques biométriques , qu'il s'agisse de son visage, son iris, sa démarche ou sa voix.

La reconnaissance faciale se distingue également des technologies d'analyse faciale , qui se rapportent au visage mais ne visent pas à en extraire le gabarit afin d'identifier ou d'authentifier la personne. Les technologies d'analyse faciale ou de reconnaissance des émotions ont ainsi pour objet de déterminer certaines caractéristiques des personnes présentes sur une image, comme leur âge, leur sexe, leur origine ou leurs émotions, mais pas leur identité. Ces technologies peuvent par exemple être utilisées pour assurer le suivi des personnes atteintes de troubles neurocognitifs, notamment pour analyser leurs interactions sociales et leurs gestes fins 2 ( * ) .

B. DES CAS D'USAGE MULTIPLES ET POTENTIELLEMENT ILLIMITÉS

Les algorithmes de reconnaissance biométrique du visage sont en constante évolution et ce mouvement connaît une accélération ces dernières années. De nombreux cas d'usage peuvent ainsi être distingués, poursuivant des finalités très diverses.

1. Les usages facilitant la gestion de l'identité

La reconnaissance faciale, utilisée pour l'établissement et le contrôle des titres d'identité , permet de s'assurer que chaque personne dispose d'une identité unique. L'usage de cette technologie vise à limiter les risques d'obtention et d'utilisation illégitime de titres d'identité et d'usurpation d'identité, et rend impossible les identités multiples pour une seule et même personne. Dans ce cadre, la reconnaissance faciale peut être utilisée pour lutter contre la fraude .

La reconnaissance faciale permet également de vérifier l'identité d'une personne à distance . Il s'agit en premier lieu d' offrir des solutions d'identification électronique sécurisées qui, en s'appuyant sur la biométrie, permettent aux consommateurs de confirmer leur identité à distance pour souscrire ou accéder à un service en conformité avec la règlementation, notamment la lutte contre la corruption ou le blanchiment. C'est ainsi que des acteurs privés ont développé des modules permettant, par le biais de la reconnaissance faciale, de déverrouiller un smartphone, d'ouvrir un compte bancaire ou encore de louer une voiture. Il s'agit en second lieu de sécuriser des transactions . Peuvent par exemple être cités l'utilisation de cartes de paiement biométriques, l'autorisation de paiements ou la signature de contrats grâce à la biométrie (empreintes digitales ou reconnaissance faciale) depuis un smartphone.

2. Les usages permettant d'assurer un contrôle des accès physiques sécurisé et fluidifié

La reconnaissance faciale permet également de vérifier l'identité des personnes accédant à un lieu par le biais d'une authentification biométrique . L'objectif poursuivi est alors d' optimiser les contrôles d'accès, en en permettant la sécurisation et la fluidification. Peuvent par exemple être concernés les accès à des zones dont l'accès doit être fortement sécurisé (frontières, zones sécurisées de grands évènements, installations industrielles sensibles de production d'énergie ou de télécommunications notamment), à des services confidentiels (dossiers médicaux, systèmes financiers) ou encore à des zones dont l'accès est restreint (zones réservées dans les grands évènements, terminaux d'aéroports).

3. L'identification et le suivi des personnes à des fins de police administrative et judiciaire

Les usages de la reconnaissance faciale les plus présents dans l'imaginaire collectif sont les usages d'identification à des fins policières ou de renseignement . Parmi eux, peuvent être distingués les usages à finalité administrative ou judiciaire.

L'identification par la biométrie du visage peut ainsi en premier lieu concourir à la sécurisation de certains espaces . C'est par exemple le cas lorsqu'elle est utilisée en temps réel en comparant des gabarits extraits à une base de personnes d'intérêt , afin notamment de faire un criblage de la foule aux abords d'un lieu sensible. L'objectif poursuivi est alors, d'une part, d'éloigner les personnes s'étant vu interdire leur présence dans ce lieu et, d'autre part, d'anticiper les risques afin de faciliter la gestion de l'évènement en cours et de donner des éléments à des fins d'enquête dans le cas de la survenue ultérieure d'un incident. Cet usage peut être comparé au travail réalisé par des physionomistes chargés d'identifier des personnes aux abords d'un lieu particulier, par exemple un stade un soir de match à haut risque. Plus largement, la reconnaissance faciale peut également être utilisée à des fins de vidéoverbalisation des piétons, voire d'identification de toutes les personnes circulant sur la voie publique.

En matière de renseignement , la reconnaissance faciale peut également permettre d'identifier des personnes d'intérêt ou de procéder au suivi de ces mêmes personnes afin de reconstituer leur parcours .

L'identification par reconnaissance faciale peut en second lieu constituer une aide à l'investigation judiciaire . C'est par exemple le cas lorsqu'elle permet de retrouver des personnes d'intérêt au sein d'une foule , qu'il s'agisse de personnes recherchées parce qu'elles ont commis une infraction, parce qu'elles ont été témoin d'un fait et peuvent être utiles à l'enquête, ou parce qu'elles sont portées disparues - enlèvement par exemple. C'est également le cas lorsqu'elle est utilisée pour identifier un suspect ou reconstituer a posteriori son parcours .

Ainsi, en résumé, la reconnaissance faciale peut permettre, sans que cette liste soit exhaustive, de contrôler l'accès et le parcours des personnes pour les évènements ou locaux sensibles, d'assurer la sécurité et le bon déroulement d'évènements à forte affluence ou d' aider à la gestion des flux dans les lieux et environnements nécessitant une forte sécurisation.

4. Les autres usages de l'identification des personnes par reconnaissance faciale

D'autres usages privés peuvent se développer dans un monde où la reconnaissance faciale n'est pas ou peu règlementée.

La société Facebook proposait ainsi la reconnaissance automatique des personnes présentes sur une image afin de suggérer l'identification nominative de ces personnes par comparaison entre les visages détectés sur l'image concernée et les gabarits de toutes les personnes présentes sur le réseau ayant consenti à cette fonctionnalité.

La société Clearview AI , une entreprise américaine qui a développé un logiciel de reconnaissance faciale dont la base de données repose sur la collecte de photographies et de vidéos publiquement accessibles sur internet, commercialise l'accès à sa base d'images sous la forme d'un moteur de recherche dans lequel une personne peut être recherchée à l'aide d'une photographie.

Au Royaume-Uni, la société Facewatch met à dispositions des gérants de commerce un logiciel de reconnaissance faciale les alertant lorsqu'une personne ayant été signalée par d'autres commerçants - dite « personne d'intérêt » - entre dans leur magasin. Le slogan de cette société est d'» arrêter le crime avant qu'il n'arrive ».

C. DANS LE MONDE, DES STRATÉGIES DIVERGENTES

1. La Chine : un développement à tout-va

La Chine est depuis quelques années à la pointe des technologies de reconnaissance faciale et plus largement biométrique. Selon les chercheurs de l'INRIA rencontrés par les rapporteurs, elle dispose d'une avance remarquable sur le plan de la recherche : 80 % des publications scientifiques relatives à la reconnaissance faciale proviennent actuellement de Chine . Les algorithmes chinois, entraînés sur des bases de données de milliards de visages, sont en tête des classements du National Institute of Standards and Technology américain, qui est la référence en la matière 3 ( * ) . Les entreprises chinoises fournissent des caméras à des prix imbattables qu'elles équipent sans surcoût de solutions logicielles pour les rendre « intelligentes ». Elles sont très désireuses de rentrer sur le marché européen 4 ( * ) .

Cette « force de frappe » scientifique et industrielle a avant toutes choses été développée pour des besoins domestiques . En 2019, sur les dix villes « championnes du monde de la vidéosurveillance », huit sont des villes chinoises, selon la revue Courrier international 5 ( * ) qui cite un palmarès établi par la société Comparitech. Les réseaux de caméras de surveillance, tous interconnectés, sont complétés par les applications numériques installées sur les téléphones mobiles des citoyens chinois , qui sont utilisées notamment à des fins de paiement. Les géants du net tels Alipay et Wechat, ont mis au point des systèmes avec QR codes permettant notamment la reconnaissance faciale et des systèmes de notation pour chaque geste de la vie quotidienne , ainsi que le documente le reportage « Ma femme a du crédit » , réalisé par Sébastien Le Belzic, journaliste français installé en Chine.

Depuis deux ans, a-t-il indiqué aux rapporteurs, l'État chinois a imposé à toute entreprise disposant de plus d'un million d'abonnés de lui transférer toutes ses données. Les autorités chinoises bénéficient ainsi de milliards de données permettant de reconstituer la vie quotidienne de ses citoyens . Selon lui, la pandémie de la Covid-19 a profondément aggravé le système de surveillance de masse avec, en particulier, la mise en place de QR codes de traçage et l'abandon progressif des paiements en argent liquide. Cet état de fait est pourtant bien accepté de la population , à l'exception des personnes âgées en raison de leur difficulté à s'adapter à cet environnement tout numérique.

Une surveillance biométrique renforcée est par ailleurs exercée sur la population ouïghoure du Xinjiang ainsi que l'a rapporté l'association Human Rights Watch : « dans le cadre de la campagne " Frapper fort ", les autorités du Xinjiang ont également collecté des données biométriques, notamment des échantillons d'ADN, des empreintes digitales, des analyses de l'iris et des groupes sanguins de tous les résidents de la région âgés de 12 à 65 ans. Les autorités exigent d'eux des enregistrements de leurs voix lorsqu'ils font une demande de passeport. Toutes ces données figurent dans des bases de données gouvernementales centralisées et exploitables. Bien que les systèmes en place au Xinjiang soient particulièrement intrusifs, leur conception de base ne diffère pas de celles que la police élabore et utilise dans toute la Chine » 6 ( * ) .

En 2014, le gouvernement chinois avait annoncé le lancement d'un « système de crédit social » dans le but d'assurer une meilleure application des lois et décisions de justice, sur le modèle des notes de fiabilité que certains services commerciaux délivrent à leurs usagers 7 ( * ) . Selon Sébastien Le Belzic, les autorités chinoises sont depuis restées discrètes sur ce projet en raison de la mauvaise publicité occasionnée et, à ce jour, le système de crédit social ne semble mis en place que pour restreindre l'accès aux transports (train et avion).

2. Le Royaume-Uni : la logique de l'empirisme

Au Royaume-Uni, deux forces de police ont décidé de mettre en place des dispositifs de reconnaissance faciale dans l'espace public . La police londonienne et la police du Pays de Galles déploient ainsi des dispositifs de reconnaissance faciale en temps réel visant à identifier dans l'espace public des personnes référencées sur une liste de surveillance ( watchlist ) établie pour chaque déploiement du dispositif, par comparaison avec les gabarits extraits des visages de toutes les personnes passant dans l'angle de la caméra. La police du Pays de Galles a également mis en place une application permettant aux policiers, en cas de doute sur l'identité déclinée par la personne au cours d'un contrôle d'identité, de recourir à la reconnaissance faciale pour vérifier que la personne concernée ne fait pas l'objet de recherches .

Les technologies de reconnaissance faciale automatisée sont utilisées comme un outil technique d'assistance à la reconnaissance de personnes impliquées dans des activités criminelles - la décision des suites à donner à une alerte est toujours humaine - dont les usages sont définis par les différentes polices en fonction de leurs besoins.

En l'absence de cadre législatif spécifique et dans un contexte de common law , il revient aux juridictions de s'assurer du caractère adapté et proportionné de ces déploiements . C'est ainsi que la Cour d'appel du Royaume-Uni, dans une décision du 11 août 2020, Bridges , a examiné le caractère proportionné de l'utilisation des outils de reconnaissance faciale par la police du Pays de Galles. Elle a jugé que le déploiement alors réalisé était illégal pour trois raisons : l'insuffisance de son régime juridique qui donnait trop de marge de manoeuvre aux policiers dans l'établissement de la liste de surveillance, l'insuffisance de l'évaluation des risques en matière de protection des données personnelles, et le non-respect du principe d'égalité en raison d'une évaluation insuffisante des potentiels biais du logiciel.

À la suite de cette décision, la police du Pays de Galles avait dû suspendre l'utilisation de la reconnaissance faciale. Sur la base des éléments avancés par la Cour d'appel, la police du Pays de Galles a décidé de reprendre ses essais en mars 2022, afin de s'assurer que le système ne présentait désormais plus de risque en matière d'égalité et que son déploiement était « responsable, proportionné et juste » 8 ( * ) .

Parallèlement, certains commerces ont acheté la solution fournie par la société Facewatch, qui permet la mise en place d'une liste de « personnes d'intérêt » partagée par tous les utilisateurs en vue de détecter les personnes signalées pour vol ou mauvais comportement dès leur entrée dans les commerces concernés. Ces usages, de même que ceux réalisés par les forces de police, ne sont pas règlementés et se développent au gré de leur adoption par les acteurs privés.

3. Les USA : des tendances contraires

a) Une multiplication des interdictions de la reconnaissance faciale au niveau municipal dont la portée concrète est à relativiser

Depuis l'adoption en mai 2019 par la ville de San Francisco d'une ordonnance 9 ( * ) interdisant l'usage de la reconnaissance faciale par la municipalité, le débat autour du développement, de l'usage et de l'encadrement de cette technologie est en plein essor aux États-Unis . Le symbole est d'autant plus fort que cette interdiction prend place au coeur de la « Silicon Valley » , dans une métropole qui abrite de nombreuses entreprises du numérique. Dans les motifs de cette décision, il est notamment avancé que « la propension de la technologie de reconnaissance faciale à mettre en danger les droits civiques et les libertés publiques l'emporte substantiellement sur ses prétendus bénéfices, et que cette technologie exacerbera les injustices raciales et menacera notre capacité à vivre en-dehors de toute surveillance continue du Gouvernement » 10 ( * ) .

Dans le sillage de la cité californienne, plusieurs grandes métropoles américaines ont entendu interdire ou règlementer le recours à la reconnaissance faciale. Cet encadrement s'opère sur un périmètre et selon des modalités variables en fonction de la ville concernée : il concerne l'usage d'algorithmes de reconnaissance faciale tantôt par les seuls services de police, tantôt par la totalité des services municipaux. Il peut même aller au-delà des seuls usages publics de cette technologie pour réguler des usages privés. Les exceptions prévues à ce principe d'interdiction diffèrent également à la marge , par exemple afin de laisser une latitude aux services de police dans l'usage de preuves obtenues par le biais de la reconnaissance faciale ou pour tolérer certains usages d'authentification privée.

Des interdictions de la reconnaissance faciale à

géométrie variable :

les exemples de Boston, Portland et

Baltimore

Boston : le conseil municipal a interdit, à compter de juin 2020, « l'obtention, la rétention, la possession, l'accès ou l'usage de tout système de reconnaissance faciale » 11 ( * ) par la ville de Boston ou ses agents, y compris par l'intermédiaire d'un accord avec un tiers. En revanche, le service de police est autorisé à utiliser des preuves issues de système de reconnaissance faciale dès lors que leur obtention n'est pas le résultat d'une requête interne . Certains usages limités à des fins d'authentification privée sont également exclus du champ de l'ordonnance.

Portland : la ville de l'Oregon a été la première à aller au-delà de l'interdiction des seuls usages publics de la reconnaissance faciale pour également viser les usages privés 12 ( * ) . Concrètement, l'usage de cette technologie par des entités privées est prohibé dans certains « lieux recevant du public » 13 ( * ) . Cette interdiction ne s'applique toutefois pas aux usages de technologies de reconnaissance du visage à des fins d'authentification sur des appareils personnels ou de détection automatique des visages sur les réseaux sociaux.

Baltimore 14 ( * ) : le conseil municipal a adopté en août 2021 un moratoire sur l'obtention, la détention, l'accès et l'usage d'algorithmes de reconnaissance faciale, ou de toute information obtenue par l'intermédiaire d'un tel système , applicable à la ville de Baltimore et à toute personne privée, physique ou morale 15 ( * ) . Ce moratoire arrivera à échéance le 31 décembre 2022, sauf si le conseil municipal décide de le proroger pour une durée maximale de cinq ans.

La violation de ce moratoire est passible d'une amende de 1 000 dollars et d'une peine de 12 mois de prison. Deux exceptions, dont une de taille, sont néanmoins prévues à ce principe général d'interdiction de la reconnaissance faciale :

- l'utilisation de systèmes de reconnaissance faciale par la police de Baltimore sur les données contenues par le « Maryland Image Repository System », dans le cadre d'investigations criminelles. Cette exception résulte du positionnement atypique de la police de Baltimore, laquelle est placée non pas sous l'autorité de la ville mais de l'État du Maryland ;

- les systèmes biométriques destinés à protéger l'accès à des lieux ou des systèmes d'informations particuliers.

Source : Commission des lois du Sénat

À l'image de la décision californienne, les motivations avancées résident en premier lieu dans la moindre efficacité des algorithmes de reconnaissance faciale lorsqu'ils sont utilisés sur des personnes de couleur ou des femmes . Il s'agit, en second lieu, de protéger les libertés publiques, singulièrement le droit à la vie privée et la liberté d'expression, face à une technologie au caractère particulièrement intrusif et soulevant de ce fait d'importants enjeux de transparence.

La portée concrète de ces interdictions doit néanmoins être relativisée . Premièrement, les usages préexistants de la reconnaissance faciale par les villes concernées étaient le plus souvent modestes. Par exemple, le responsable de la police de Boston a indiqué dans une audition publique en juin 2020, soit avant l'entrée en vigueur de l'ordonnance précitée, que ses services n'avaient pas recours à la reconnaissance faciale et que « cette technologie ne l'intéressait pas tant qu'elle n'était pas à 100 % efficace » 16 ( * ) . Deuxièmement, le contrôle de ces interdictions est délicat à mettre en oeuvre, voire à la limite de l'impossible dans le cas des usages privés. À Baltimore, aucune poursuite n'a à ce jour été engagée sur le fondement d'une violation du moratoire. Troisièmement, des exceptions importantes peuvent être prévues, en particulier s'agissant de l'usage de la reconnaissance faciale par les services de police dans le cadre d'investigations criminelles.

À certains égards, ce mouvement relève donc davantage d'une position de principe vis-à-vis de la reconnaissance faciale que d'un réel bouleversement des usages. Les débats relatifs aux biais des algorithmes se tiennent par ailleurs dans un contexte de montée en puissance du mouvement « Black Lives Matter » et de regain des tensions raciales aux États-Unis à la suite du décès de Georges Floyd en mai 2020. Ce contexte amplifie sans nul doute la dynamique observée de renonciation à la reconnaissance faciale.

Il serait toutefois réducteur de limiter l'analyse du développement de la reconnaissance faciale à cette seule succession d'interdictions locales. La structure fédérale des États-Unis fait qu'il existe potentiellement autant de doctrines d'usage que d'autorités susceptibles d'avoir recours à la reconnaissance faciale , que ce soit au niveau fédéral, des États ou encore municipal. Au-delà des ordonnances d'interdiction précitées, cette technologie peut également être utilisée par certaines autorités locales à grande échelle et sans encadrement ad hoc , ainsi que l'a démontré la controverse liée à l'utilisation par certains services de police de l'outil fourni par la société Clearview AI 17 ( * ) .

b) Des règlementations locales des usages policiers de la reconnaissance faciale : les exemples de New-York et de Baltimore

Les travaux des rapporteurs ont mis en lumière l'existence de règlementations locales de l'usage de la reconnaissance faciale par les services de police pouvant, par certains aspects, ressembler aux pratiques françaises 18 ( * ) . C'est par exemple le cas des services de police de Baltimore et de New-York, où la reconnaissance faciale peut être utilisée dans le cadre d'enquêtes policières afin de comparer, dans certains cas limitativement énumérés, le visage d'une personne d'intérêt avec ceux figurant dans une base de données de plus ou moins grande envergure :

- à New-York : la base de données contient uniquement des photos obtenues au cours d'arrestations et les visages des personnes en libération conditionnelle 19 ( * ) ;

- à Baltimore : tenue par le « Maryland Department of Public Safety and Correctional Services », la base de données est beaucoup plus importante, voire massive. Par exemple, l'intégralité des photos fournies à l'administration pour l'obtention d'un permis de conduire y figure.

Les six usages autorisés de la reconnaissance

faciale

par le New York City Police Department (NYPD)

(Patrol Guide

- Guide du policier en service)

Dans le cadre d'enquêtes policières conduites par le service de police de New-York, l'usage de la reconnaissance faciale est uniquement autorisé pour les six objectifs suivants :

« a) Identifier une personne lorsqu'il y a des raisons de croire qu'elle a commis, commet ou est sur le point de commettre une infraction ;

« b) Identifier une personne lorsqu'il y a des raisons de croire qu'elle est une personne disparue, la victime d'un crime ou le témoin d'une activité criminelle ;

« c) Identifier une personne décédée,

« d) Identifier une personne qui est incapable de s'identifier,

« e) Identifier une personne qui est en état d'arrestation et qui ne possède pas d'identification valide, qui ne dispose pas d'une pièce d'identité valide, ou qui semble utiliser l'identification de quelqu'un d'autre, ou une fausse identification,

« f) Atténuer une menace imminente pour la santé ou la sécurité publique (par exemple, pour contrecarrer un plan ou un complot terroriste actif, etc. ) »

Source : Commission des lois du Sénat

Les deux services de police ont établi des lignes directrices visant à encadrer l'usage de la reconnaissance faciale, qui se rejoignent sur la plupart des points . Au titre des garanties, la demande doit être déposée auprès d'une unité dédiée , seule autorisée à accéder au système. Il s'agit du « Real Time Crime Center, Facial Identification Section » à New-York et d'une « Open Source Unit » à Baltimore. Les enquêteurs de ces unités évaluent le bien-fondé de la demande et, le cas échéant, procèdent à la comparaison. Les potentielles correspondances sont ensuite confirmées par une analyse visuelle d'une part, et par la consultation des fichiers de police pertinents, d'autre part . La transmission des résultats au requérant est soumise à un double-degré de validation et, enfin, une trace est conservée de chacune des requêtes. La technologie est uniquement utilisée comme un instrument d'aide à l'enquête. Sur le plan juridique, l'établissement d'une correspondance ne constitue pas en elle-même une preuve justifiant par exemple une arrestation et elle doit systématiquement être accompagnée d'investigations complémentaires.