Avis n° 184 (2019-2020) de M. Yves BOULOUX , fait au nom de la commission des affaires économiques, déposé le 10 décembre 2019

Disponible au format PDF (648 Koctets)

-

L'ESSENTIEL

-

I. UNE PERSISTANCE DÉPLORABLE DES DISCOURS DE

HAINE EN LIGNE MALGRÉ L'EXISTENCE D'UN ARSENAL JURIDIQUE NON

NÉGLIGEABLE

-

II. UNE PROPOSITION DE LOI PERFECTIBLE

-

A. UNE DÉMARCHE AMBITIEUSE, MAIS UNE

MÉTHODE CONTESTABLE

-

B. LA PERTINENCE D'UNE RÉGULATION EX ANTE

DES PLATEFORMES LES PLUS STRUCTURANTES

-

1. D'importants doutes sur la

« disposition phare » du texte : l'obligation de

retrait en 24 heures (article 1er)

-

2. Une régulation ex ante pertinente,

à rendre plus efficace et davantage proportionnée

(articles 2, 3 et 4).

-

a) De nouvelles obligations de moyens à la

charge des plateformes, dont la proportionnalité doit être

assurée.

-

b) La nécessité d'un

régulateur en vue de créer un dialogue pérenne et

encadré entre les pouvoirs publics, les acteurs régulés et

la société civile

-

c) Un nouveau modèle de régulation du

numérique ?

-

a) De nouvelles obligations de moyens à la

charge des plateformes, dont la proportionnalité doit être

assurée.

-

3. Un dispositif peu lisible et inapplicable de

lutte contre les « contenus miroirs »

-

1. D'importants doutes sur la

« disposition phare » du texte : l'obligation de

retrait en 24 heures (article 1er)

-

A. UNE DÉMARCHE AMBITIEUSE, MAIS UNE

MÉTHODE CONTESTABLE

-

I. UNE PERSISTANCE DÉPLORABLE DES DISCOURS DE

HAINE EN LIGNE MALGRÉ L'EXISTENCE D'UN ARSENAL JURIDIQUE NON

NÉGLIGEABLE

-

EXAMEN EN COMMISSION

-

LISTE DES PERSONNES ENTENDUES

N° 184

SÉNAT

SESSION ORDINAIRE DE 2019-2020

|

Enregistré à la Présidence du Sénat le 10 décembre 2019 |

AVIS

PRÉSENTÉ

au nom de la commission des affaires économiques (1) sur la proposition de loi , adoptée par l'Assemblée nationale après engagement de la procédure accélérée, visant à lutter contre les contenus haineux sur internet ,

Par M. Yves BOULOUX,

Sénateur

|

(1) Cette commission est composée de : Mme Sophie Primas , présidente ; Mme Élisabeth Lamure, MM. Daniel Gremillet, Alain Chatillon, Martial Bourquin, Franck Montaugé, Mmes Anne-Catherine Loisier, Noëlle Rauscent, M. Alain Bertrand, Mme Cécile Cukierman, M. Jean-Pierre Decool , vice-présidents ; MM. François Calvet, Daniel Laurent, Mmes Catherine Procaccia, Viviane Artigalas, Valérie Létard , secrétaires ; M. Serge Babary, Mme Anne-Marie Bertrand, MM. Yves Bouloux, Bernard Buis, Henri Cabanel, Mmes Anne Chain-Larché, Marie-Christine Chauvin, Catherine Conconne, Agnès Constant, MM. Roland Courteau, Pierre Cuypers, Marc Daunis, Daniel Dubois, Laurent Duplomb, Alain Duran, Mmes Dominique Estrosi Sassone, Françoise Férat, M. Fabien Gay, Mme Annie Guillemot, MM. Xavier Iacovelli, Jean-Marie Janssens, Joël Labbé, Mme Marie-Noëlle Lienemann, MM. Pierre Louault, Michel Magras, Jean-François Mayet, Franck Menonville, Jean-Pierre Moga, Mmes Patricia Morhet-Richaud, Sylviane Noël, MM. Jackie Pierre, Michel Raison, Mmes Évelyne Renaud-Garabedian, Denise Saint-Pé, M. Jean-Claude Tissot . |

Voir les numéros :

|

Assemblée nationale ( 15 ème législ.) : |

1785 , 1989 , 2062 et T.A. 310 |

|

|

Sénat : |

645 (2018-2019) et 173 (2019-2020) |

|

L'ESSENTIEL

Réunie le mardi 10 décembre 2019, sous la présidence de Mme Sophie PRIMAS , la commission des affaires économiques a examiné le rapport de M. Yves BOULOUX sur les articles dont elle s'est saisie pour avis simple de la proposition de loi visant à lutter contre les contenus haineux sur internet 1 ( * ) , adoptée par l'Assemblée nationale après engagement de la procédure accélérée.

Si le phénomène est encore peu documenté, chaque utilisateur des réseaux sociaux peut aujourd'hui constater que les propos haineux répréhensibles par la loi s'y répandent quotidiennement. La question que pose cette proposition de loi est donc pleinement légitime. Mais la réponse qu'elle y apporte apparaît inaboutie.

La commission des affaires économiques s'est saisie de ce texte pour avis simple car il modifie la loi pour la confiance dans l'économie numérique de 2004 - dite « LCEN », dont elle avait été saisie au fond. De plus, si son objectif relève de la protection des libertés fondamentales, il affecte l'économie numérique, qui relève de la compétence de la commission.

La commission partage la démarche adoptée en l'espèce par le Gouvernement, qui consiste à faire de la France un laboratoire européen et mondial, sans attendre que des dispositions soient adoptées au niveau européen.

Elle soutient également les dispositions moins commentées - mais sans doute plus pertinentes -, qui visent à instaurer une régulation ex ante des plateformes en matière de lutte contre les contenus illicites. C'est pourquoi elle s'est attachée à en accroître l'efficacité.

La commission appuie en revanche les doutes de la commission des lois du Sénat sur la pertinence de la « disposition phare » du texte, à savoir son article premier, au regard des risques qu'elle fait peser sur la liberté d'expression.

À l'initiative de son rapporteur, la commission a adopté les amendements suivants, qui visent à :

- doter le régulateur d'un pouvoir d'évocation pour les plateformes sous les seuils amenés à être déterminés par décret, afin d'éviter un report des utilisateurs tenant des propos illicites vers des plateformes non régulées ;

- proportionner les obligations de moyen en fonction de la capacité des acteurs et du risque d'atteinte à la dignité humaine ;

- supprimer une disposition s'assimilant à une obligation générale de surveillance, afin de rendre le texte conforme au droit européen actuellement en vigueur ;

- permettre au régulateur d'encourager les acteurs concernés au partage d'informations .

Sous réserve de l'adoption de ses amendements, la commission a émis un avis favorable à l'adoption des articles de la proposition de loi dont elle s'est saisie pour avis.

Les amendements ont été examinés par la commission des lois lors de sa réunion du mercredi 11 décembre 2019.

I. UNE PERSISTANCE DÉPLORABLE DES DISCOURS DE HAINE EN LIGNE MALGRÉ L'EXISTENCE D'UN ARSENAL JURIDIQUE NON NÉGLIGEABLE

A. LE DROIT EN VIGUEUR ALLIE RESPONSABILITÉ EN L'ABSENCE DE PROMPT RETRAIT ET AUTO-RÉGULATION

1. La responsabilité des hébergeurs peut-être engagée en cas d'absence de prompt retrait d'un contenu illicite dûment notifié

Le droit applicable aux contenus publiés sur internet est issu de la directive sur le commerce électronique (ou directive « e-commerce »), adoptée en 2000 2 ( * ) , qui avait pour double objectif de favoriser le développement de l'économie numérique sur le marché intérieur en évitant d'imposer des contraintes trop lourdes aux intermédiaires et de préserver la liberté d'expression en ligne 3 ( * ) . Elle a été transposée en 2004 par l'article 6 de la loi pour la confiance dans l'économie numérique (ci-après, « LCEN ») 4 ( * ) , ultérieurement complétée d'un article 6-1 5 ( * ) .

En application de cet article 6, les hébergeurs 6 ( * ) sont tenus de retirer « promptement » les contenus illicites qui leur ont été notifiés dans les formes déterminées par la loi, sous peine d'engager leur responsabilité civile et pénale . Ce régime concerne tout type d'illicéité : contenus « haineux », mais aussi violation de droits d'auteurs, trafics illicites, fraude...

|

La responsabilité « limitée » des hébergeurs La LCEN distingue trois régimes de responsabilité (civile et pénale) : - un régime d' irresponsabilité des fournisseurs d'accès à internet (FAI) 7 ( * ) à raison des contenus qu'ils transportent ; - un régime allégé, qui concerne les hébergeurs à raison des contenus qu'ils hébergent, car ils sont considérés comme des intermédiaires techniques, dont l'activité se limite à rendre disponibles des contenus publiés par d'autres ; - un régime de responsabilité des éditeurs 8 ( * ) , qui choisissent les contenus publiés. S'agissant des hébergeurs, cela signifie, selon l'article 6 de la LCEN, qui découle des articles 14 et 15 de la directive sur le commerce électronique, que : - leur responsabilité (civile ou pénale) ne peut être engagée (i) s'ils n'avaient pas « effectivement » connaissance du caractère illicite du contenu « ou de faits et circonstances faisant apparaître ce caractère » ou si, (ii) « dès le moment où ils en ont eu connaissance, ils ont agi promptement pour retirer ces données ou en rendre l'accès impossible ». L'hébergeur est considéré avoir pris connaissance effective du caractère illicite de l'information stockée à partir du moment où une notification lui a été remise, dans des conditions de forme déterminées par la loi (la notification doit, en particulier, permettre d'identifier le notifiant, et de justifier d'une demande de retrait préalable adressée à l'éditeur ou à l'auteur du propos jugé illicite). Toute notification abusive est punie d'une peine pouvant aller jusqu'à un an d'emprisonnement et 15 000 euros d'amende). Dans sa décision n° 2004-496 DC du 10 juin 2004, le Conseil constitutionnel a de plus limité la portée de cette responsabilité, en indiquant que le contenu devait présenter un caractère manifestement illicite ; - ne pèse sur eux aucune obligation de surveillance générale des informations qu'ils stockent, ni aucune obligation générale de rechercher activement des faits ou des circonstances révélant des activités illicites. |

La LCEN prévoit également la possibilité pour l'autorité judiciaire de prescrire en référé ou sur requête toutes mesures permettant de prévenir un dommage ou de faire cesser un dommage occasionné par tout contenu illicite 9 ( * ) , autrement dit, elle autorise un blocage judiciaire de l'accès au contenu - l'autorité judiciaire pouvant s'adresser à l'hébergeur ou, à défaut, au fournisseur d'accès à internet (FAI) 10 ( * ) . La nécessité de s'adresser d'abord à l'hébergeur est connue sous le nom de « principe de subsidiarité ». Ce dernier a fait l'objet d'une interprétation relativement souple de la Cour de cassation 11 ( * ) , sans toutefois le priver de toute portée 12 ( * ) .

Enfin, les hébergeurs et FAI doivent prendre les mesures nécessaires pour conserver les données de nature à permettre l'identification de quiconque aurait contribué à la création du contenu illicite. Les autorités judiciaires peuvent, en effet, être amenées à souhaiter consulter lesdites données.

S'agissant des contenus « haineux » 13 ( * ) , la LCEN prévoit déjà des obligations renforcées à la charge des hébergeurs 14 ( * ) . Les hébergeurs et FAI doivent à ce titre :

- prévoir un dispositif de signalement « facilement accessible et visible » permettant à toute personne de porter à leur connaissance ce type de données ;

- informer « promptement » les autorités publiques compétentes de toutes activités illicites qui leur seraient signalées et qu'exerceraient les destinataires de leurs services - le signalement est traité par la plateforme Pharos 15 ( * ) , qui dépend de l'Office central de lutte contre la criminalité liée aux technologies de l'information et de la communication (OCLCTIC) du ministère de l'Intérieur ;

- rendre publics les moyens qu'elles consacrent à la lutte contre ces activités illicites.

Contrairement à l'absence de retrait du contenu dans un délai prompt, le fait de ne pas remplir ces obligations est un délit en tant que tel , passible d'un an d'emprisonnement et de 75 000 euros d'amende (375 000 euros d'amende pour une personne morale).

Pour certains types de contenus haineux illicites publiés en ligne 16 ( * ) , l'article 50-1 de la loi du 29 juillet 1881 sur la liberté de la presse prévoit également la possibilité d'un blocage judiciaire en référé en cas de « trouble manifestement illicite » 17 ( * ) .

Enfin, depuis 2014, pour les contenus terroristes ou pédopornographiques, un dispositif de blocage administratif s'appuyant sur les fournisseurs d'accès à internet a été mis en place à l'article 6-1 de la LCEN. En cas de non-respect de la demande de blocage par les FAI, ceux-ci s'exposent à une peine d'un an d'emprisonnement et 75 000 euros d'amende pour les personnes physiques (portée à 375 000 euros pour les personnes morales). Pour simplifier, le mécanisme tient en deux temps :

- d'abord, l'autorité administrative - en l'occurrence l'OCLCTIC - demande à l'éditeur du service ou à son hébergeur « de retirer les contenus » ; elle en informe simultanément les FAI ;

- en l'absence de retrait dans les 24 heures, l'OCLCTIC peut notifier ces contenus aux FAI, qui « doivent alors empêcher sans délai l'accès à ces adresses » .

Par précaution, le législateur a prévu que la mesure de blocage est placée sous le contrôle d'« une personnalité qualifiée, désignée en son sein par la Commission nationale de l'informatique et des libertés » (Cnil).

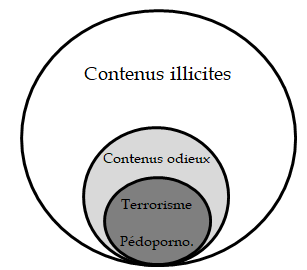

Représentation simplifiée des différents champs d'application des dispositions de la LCEN

Le droit en vigueur a fait l'objet d'un utile rappel de la ministre de la Justice dans une circulaire en date du 4 avril 2019 portant sur la lutte contre les discriminations, les propos et les comportements haineux.

2. Au-delà de la directive « e-commerce », la préférence européenne pour l'auto-régulation

Au-delà des dispositions en vigueur décrites au 1. et qui découlent en partie de la directive sur le commerce électronique, la Commission européenne favorise, sur ce sujet, une approche non coercitive. Celle-ci repose sur un code de conduite visant à lutter contre les discours haineux illégaux en établi en juin 2016. Il ne s'agit pas d'un texte officiel de l'UE, mais d'engagements pris par les grandes entreprises de l'Internet 18 ( * ) , encouragées par les autorités européennes.

|

Les engagements volontaires des entreprises figurant dans le code de conduite Figurent notamment dans le code de conduite les engagements suivants : - mettre en place des procédures claires et efficaces d'examen des signalements de discours haineux illégaux (ou non conformes aux règles d'utilisation) ; - confier le soin d'examiner le caractère illégal du contenu après signalement à des équipes spécialisées ; - examiner « la majorité des signalements » valides en moins de 24 heures et, s'il y a lieu, en bloquer l'accès ; - informer leurs utilisateurs et les sensibilisent aux types de contenus qui ne sont pas autorisés ; - fournir des informations sur les procédures et leur mise en oeuvre (signalement, blocage, retrait) ; - établir un point de contact dans chaque État membre pour échanger ces informations ; - favoriser la coopération dans la lutte contre les contenus haineux avec des associations en tant que « signaleurs de confiance », ou « trusted flaggers » ; en France, la DILCRAH (Délégation Interministérielle à la Lutte Contre le Racisme, l'Antisémitisme et la Haine anti-LGBT) et de nombreuses associations sont considérées comme « rapporteurs de confiance » ; - former leur personnel « aux évolutions actuelles de la société » ; - échanger les bonnes pratiques ; - promouvoir des contre-discours et des programmes éducatifs favorisant l'esprit critique. |

En mars 2018, la Commission a également formulé une recommandation sur « les mesures destinées à lutter, de manière efficace, contre les contenus illicites en ligne » 19 ( * ) , qui met en avant quelques grands principes et bonnes pratiques pour lutter contre les contenus illicites. Dans la foulée, la Commission a lancé une consultation sur la régulation des contenus illicites en ligne, afin d'apprécier, secteur par secteur, l'opportunité de renforcer la réglementation.

Plusieurs textes de nature contraignante viennent cependant compléter cette approche centrée sur l'autorégulation . La récente directive modifiant les règles applicables aux services de médias audiovisuels, dite « SMA », que la France n'a pas encore transposée, prévoit que les États doivent veiller à ce que les plateformes de partage de vidéos établies sur leur territoire prennent les mesures appropriées pour protéger « le grand public des programmes vidéos créés par l'utilisateur et communications commerciales audiovisuelles comportant des contenus dont la diffusion constitue une infraction pénale au titre du droit de l'Union », notamment les infractions relevant du racisme et de la xénophobie 20 ( * ) . Elle privilégie cependant assez largement « l'utilisation de la corégulation et la promotion de l'autorégulation au moyen de codes de conduite ».

La proposition de règlement relatif à la prévention de la diffusion de contenus à caractère terroriste en ligne 21 ( * ) adopte une approche davantage coercitive en exigeant des hébergeurs de prendre des mesures pour lutter contre la diffusion de ces contenus, à publier des rapports de transparence et à insérer leur politique de prévention dans leurs conditions commerciales. La mesure « phare » du règlement consiste en une obligation de retrait du contenu en une heure à compter de la réception d'une injonction administrative.

Enfin, la nouvelle commission européenne entend ouvrir le chantier d'un « Digital services Act » qui pourrait amener à une révision de la directive « e-commerce » elle-même, mais le processus n'en est encore qu'aux prolégomènes.

Au niveau international, une charte non contraignante pour un internet ouvert, libre et sûr a été signée par les grands réseaux sociaux lors du G7 qui s'est tenu à Biarritz en août dernier suite à l'Appel de Christchurch du 15 mai 2019 22 ( * ) .

|

La charte pour un internet ouvert, libre et sûr d'août 2019 On peut notamment relever, eu égard à la proposition de loi, les engagements suivants de la part des réseaux sociaux et plateformes numériques signataires : - établir des procédures simples, facilement accessibles, transparentes et efficaces de traitement et de notification des contenus illégaux, le cas échéant en collaboration avec les autorités administratives ; - examiner ces notifications dans les plus brefs délais et prendre rapidement les mesures appropriées ; - mettre à disposition en temps voulu des mécanismes de recours efficaces en cas de retrait ou de désactivation de contenus, et prendre des mesures de sauvegarde adéquates pour protéger la liberté d'expression, notamment en faisant preuve de transparence vis-à-vis des utilisateurs concernant les contenus supprimés et en les rétablissant en cas de décision erronée. La possibilité d'autres recours, notamment judiciaires, ne saurait nullement être entravée ; - accroître la transparence de leurs conditions d'utilisation, de leurs activités liées au retrait de contenus, et des procédures de modération. |

B. UNE PERSISTANCE DES CONTENUS HAINEUX QUI S'IMMISCE DANS LES FAILLES DU DROIT EN VIGUEUR ET DE SON APPLICATION PERFECTIBLE

1. Malgré les progrès réalisés par les plateformes, la persistance des contenus haineux en ligne

a) Un phénomène difficile à mesurer, mais persistant...

Le rapport de la « mission Facebook » le rappelait fort justement : les réseaux sociaux sont « une formidable avancée pour la liberté d'expression » 23 ( * ) . Mais, comme le soulignait aussi le rapport visant à renforcer la lutte contre le racisme et l'antisémitisme sur internet 24 ( * ) , on ne peut nier « la banalisation du racisme et de l'antisémitisme sur internet ».

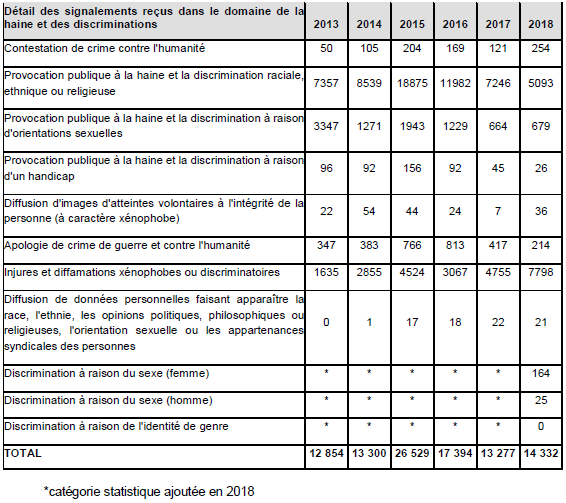

Il n'existe pas de statistiques officielles et exhaustives quantifiant l'ampleur du phénomène. En revanche, certains indices peuvent être utilisés, comme les signalements à la plateforme Pharos . En 2018, celle-ci dénombrait 163 723 signalements , dont 14 000 relevaient de la haine en ligne ou de discriminations 25 ( * ) . La majorité des signalements concerne des contenus présents sur les réseaux sociaux américains. Comme le montre le tableau suivant, plus de la moitié relevaient des injures ou diffamations xénophobes ou discriminatoires et plus du tiers de la provocation publique à la haine et la discrimination raciale, ethnique ou religieuse :

Source : ministère de

l'Intérieur,

contribution au rapport 2018 de la CNCDH sur la lutte

contre le racisme, janvier 2019

Malgré ces données lacunaires, il est indéniable qu'une réponse au sentiment d'impunité des discours de haine en ligne doit être apportée, et que « l'indifférence » des pouvoirs publics dénoncée par le rapport visant à renforcer la lutte contre le racisme et l'antisémitisme sur internet doit cesser .

b) ... malgré d'importants progrès réalisés par les plateformes

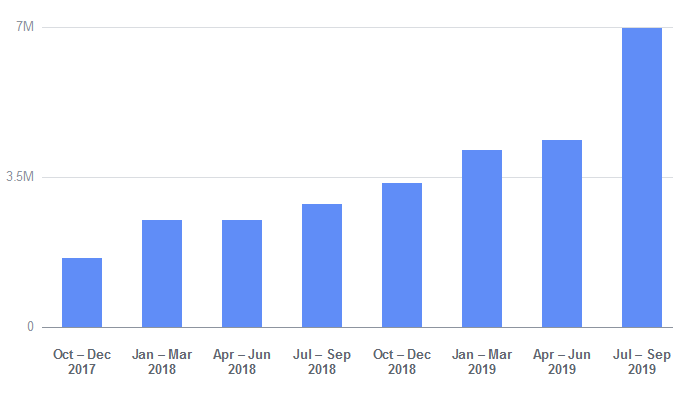

Les plateformes ont réalisé des progrès, comme cela a pu être souligné par le rapport de la « mission Facebook ». La plus grande attention donnée par les grandes plateformes à ce sujet se traduit d'abord par une hausse du nombre de contenus traités , comme le montrent, ci-dessous, les données publiées par Facebook dans son rapport de transparence sur les pratiques de l'entreprise en la matière 26 ( * ) .

Nombre de contenus considérés comme des

« discours haineux »

traités par Facebook dans le

monde

(en millions)

Source : Facebook, rapport de transparence

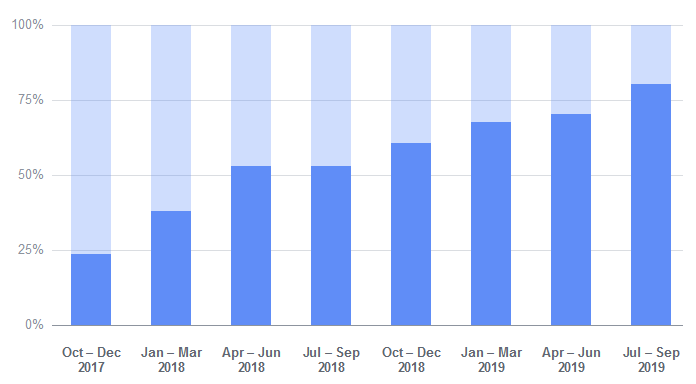

La très grande majorité des contenus traités aujourd'hui par l'entreprise le seraient d'ailleurs avant toute notification des utilisateurs , comme le montre le graphique ci-dessous.

Répartition des contenus traités avant ou après notification par les utilisateurs (en % du total des contenus traités)

Source : Facebook, rapport de

transparence.

Nb : la partie sombre représente les contenus

traités de façon proactive, c'est-à-dire avant

notification, et la partie claire représente les contenus traités

après notification.

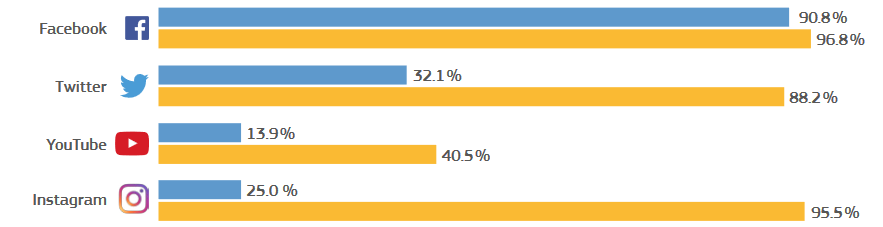

Dans le cadre de la mise en oeuvre du code de conduite au niveau européen, on constate effectivement une hausse du taux de notifications examinées en 24 heures pour l'ensemble des entreprises concernées , à près de 89 %. 72 % des contenus considérés comme des discours de haine illégaux seraient supprimés (contre 28 % lors de la première évaluation du dispositif). Cependant il existe de grandes disparités : quand Facebook retire 82,4 % des contenus notifiés et Youtube 85,4 %, Twitter ne retire que 43,5 %.

Les acteurs se sont dotés d'importants moyens humains . Facebook aurait recours aux services de 15 000 modérateurs de contenus dans le monde, avec l'aide de partenaires comme Accenture, Genpact, CCC et Majorel, répartis sur plus d'une vingtaine de sites dans le monde, notamment en Allemagne, en Irlande, en Lettonie, aux Philippines, en Espagne ou aux États-Unis.

Ils appliquent davantage de mesures de transparence, à travers les rapports réguliers, la publication des « standards de la communauté »... Facebook envisage même la création d'une instance d'appel indépendante pour gérer les cas les plus délicats.

Par ailleurs, les données publiées par Facebook font état d'un taux d'erreur relativement faible : sur les 7 millions de contenus haineux traités par l'entreprise entre juillet et septembre 2019, 1,4 million ont fait l'objet d'un recours, soit 20 %, mais seuls 169 700 ont été republiés suite au recours, soit 2,4 % des contenus traités mais 12 % des contenus ayant fait l'objet d'un appel. Enfin, 2 200 contenus ont été rétablis sans qu'un recours n'ait été effectué. Le taux d'erreur global est donc de 2,4 % sur cette période.

Enfin, il semble que la marge de progression la plus importante se trouve dans les mesures relatives à la transparence quant aux suites données aux notifications , comme le montre le graphique ci-dessous.

Information des utilisateurs suite à une notification

Source : Commission européenne, quatrième

évaluation du code de conduite

contre les discours de haine

illégaux en ligne, février 2019.

En sombre figurent les

réponses aux utilisateurs, en plus clair celles des tiers de

confiance.

La rapporteure de la commission des lois de l'Assemblée nationale souligne également le degré de coopération hétérogène des différentes plateformes avec les autorités publiques : si Youtube et Facebook retireraient près de 80 % des contenus haineux signalés dans les 24 heures par la plateforme Pharos, ce ne serait le cas que de 50 % des contenus signalés à Twitter.

2. Un droit en vigueur régulièrement contesté et insuffisamment appliqué.

On ne peut ignorer l'une des grandes limites de la directive « e-commerce » : elle était censée permettre l'émergence d'entreprises européennes du numérique ; mais elle ne fait aujourd'hui que protéger les grandes entreprises non européennes.

Deux dispositions font aujourd'hui l'objet d'une remise en cause : le principe du pays d'origine et le principe de la responsabilité limitée.

La remise en cause de la responsabilité limitée des hébergeurs est envisagée dans de nombreux domaines. Par exemple, au regard de la protection des consommateurs, la persistance de produits frauduleux sur les places de marché en ligne pourrait plaider pour un renforcement de leur responsabilité. C'est une piste sur laquelle travaille la direction générale de la concurrence, de la consommation et de la répression des fraudes.

S'agissant de la haine en ligne, le droit en vigueur est considéré comme inadapté à l'enjeu, selon des arguments bien résumés par le rapport de la députée Laëtitia Avia pour la commission des lois de l'Assemblée nationale :

- certains acteurs de l'internet ont un rôle actif, « d'accélération des contenus » 27 ( * ) , qui les distinguent de simples intermédiaires techniques et qui nécessitent d'aller au-delà de la responsabilité limitée ;

- l'absence de régulateur pour garantir l'application de la LCEN ;

- les procédures de signalement sont insuffisamment harmonisées, trop complexes pour les utilisateurs et la transparence des procédures en cas de retrait est insuffisante ;

- le montant maximal de la sanction (375 000 euros d'amende pour une personne morale) est jugé inadapté à la réalité du secteur (en 2018, le chiffre d'affaires de Facebook atteignait 55,8 milliards de dollars) ;

- des difficultés structurelles entravent le travail des enquêteurs et de l'autorité judiciaire (« défaut d'identification des titulaires de comptes à l'origine de la publication de contenus illicites (hébergements à l'étranger, réquisitions infructueuses, anonymat sur internet...), caractère massif du contentieux, absence d'obligation pour ces opérateurs de disposer d'une représentation légale en France »)... Ce dernier point est soulevé à plusieurs reprises par la circulaire du 4 avril dernier, qui incite à agir auprès des FAI plutôt qu'auprès des hébergeurs, souvent difficiles à identifier et à localiser. De plus, la mise en cause de la responsabilité pénale des hébergeurs est délicate car cela nécessite de prouver la complicité 28 ( * ) de l'hébergeur dans la commission du délit sous-jacent, et l'élément intentionnel de l'infraction. De fait, comme le souligne la rapporteure de la commission des lois de l'Assemblée nationale, on ne trouve aucun cas d'engagement de responsabilité pénale d'un hébergeur à raison des contenus stockés.

Par ailleurs, le blocage des sites internet s'est toujours heurté à une certaine inefficacité technique, contre laquelle il apparaît difficile de lutter à l'aide d'une loi : il est très facile de copier-coller un site en en changeant le nom de domaine. C'est le phénomène des « sites miroirs ».

Plusieurs personnes auditionnées ont néanmoins souligné que le droit en vigueur permet déjà de poursuivre les auteurs et les hébergeurs de propos haineux illicites. Ce qui ferait défaut serait donc, d'une part, la volonté politique au plus haut niveau de l'État - ce qui semble avoir changé, comme le démontre notamment la circulaire du 4 avril 2019 précitée -, d'autre part, les moyens mis à disposition de la justice sur ce sujet.

S'agissant de l'action au niveau européen, comme le remarquait le rapport visant à renforcer la lutte contre le racisme et l'antisémitisme sur internet, « la lutte contre la haine en ligne repose (...) actuellement (...) sur le volontarisme des plateformes, leur principale motivation affichée étant de protéger leur réputation ». Le rapport de la « mission Facebook » relevait « l'insuffisance et le manque de crédibilité des démarches d'autorégulation développées par les plus grandes plateformes », qui se traduisent notamment par une asymétrie extrême d'information entre les pouvoirs publics et les plateformes, un caractère trop « autocentré » de cette autorégulation. Il considérait que « l'insuffisance constatée (des) mécanismes de modération et le manque de transparence du fonctionnement de leur plateforme justifient une intervention des pouvoirs publics, nonobstant les efforts consentis par certains acteurs ».

II. UNE PROPOSITION DE LOI PERFECTIBLE

A. UNE DÉMARCHE AMBITIEUSE, MAIS UNE MÉTHODE CONTESTABLE

1. Le plein soutien de la commission sur la démarche : faire de la France un laboratoire européen et mondial

Le rapporteur salue le fait que le Gouvernement identifie l'échelon national comme l'échelon pertinent de régulation du numérique dans l'attente d'une solution harmonisée au niveau européen , comme pour la taxe sur les services numériques 29 ( * ) . Il s'agit, en quelque sorte, de faire de notre pays un laboratoire européen et mondial sur le sujet.

C'est cette même démarche que la commission des affaires économiques propose également au Gouvernement d'adopter à travers la proposition de loi visant à garantir le libre choix du consommateur dans le cyberespace 30 ( * ) .

C'est d'ailleurs la même approche qui a prévalu en Allemagne avec l'adoption de la loi visant à améliorer l'application de la loi sur les réseaux sociaux, dite « NetzDG » en octobre 2017 et entrée en vigueur en janvier 2018.

2. Le caractère contestable de la méthode

La proposition de loi examinée est issue d'une

réflexion engagée depuis un an et demi

. Le plan national

triennal 2018-2020 de lutte contre racisme et l'antisémitisme

publié en mars 2018 prévoyait de modifier

la

législation nationale en vue de lutter contre la haine en ligne.

En septembre 2018, Karim Amellal, Laëtitia Avia et Gil

Taïeb publiaient leur rapport intitulé «

Renforcer la

lutte contre le racisme et l'antisémitisme sur

Internet

». Le 22 février 2019, le

Président de la République annonçait, au dîner

annuel du Conseil représentatif des institutions juives de France,

qu'une initiative législative allait bientôt être

débattue.

Parallèlement, le Président de la République était convenu avec le président-directeur général de Facebook Mark Zuckerberg, d'envoyer auprès de l'entreprise un groupe d'experts en charge d'observer ses pratiques de modération et de formuler des propositions de régulation. Le rapport de la « mission Facebook », publié en mai 2019, prend le contrepied de l'approche adoptée par le précédent rapport, en prônant une régulation centrée sur les moyens mis en oeuvre pour lutter contre la haine illicite en ligne plutôt que sur une obligation de résultat de retrait en 24 heures.

Malgré cet important travail préparatoire, la méthode adoptée par le Gouvernement apparaît contestable à plusieurs égards. Il a, une fois de plus, choisi de recourir à une proposition de loi plutôt qu'à un projet de loi. S'il convient de saluer la saisine du Conseil d'État par le président de l'Assemblée nationale - dont les recommandations ont été suivies par les députés -, le véhicule d'une proposition de loi prive le Parlement d'une étude d'impact . Interrogé sur ce point par le rapporteur, le Gouvernement a admis ne pas avoir documenté ni l'ampleur du problème ni les dysfonctionnements liés au droit en vigueur.

De plus, le Gouvernement n'a pas pris le soin de demander l'avis de la Commission européenne préalablement au dépôt du texte.

En somme, alors même que la gestation de cette proposition de loi a été relativement longue, on dénote une certaine précipitation du Gouvernement, qui a préféré soumettre au Parlement un texte inabouti sans que les précautions préalables nécessaires n'aient été prises.

Enfin, plusieurs autres véhicules normatifs - adoptés ou en cours d'adoption - abordent des thématiques proches et pourraient entrer en contradiction avec la proposition de loi ou, à tout le moins, nécessiter un ajustement à court terme. Il en va notamment ainsi de la directive SMA et du règlement européen sur les contenus terroristes déjà évoqués, ainsi que du projet de loi sur la communication audiovisuelle et la souveraineté culturelle à l'ère numérique (ci-après, « projet de loi sur l'audiovisuel ») présenté en Conseil des ministres le 5 décembre dernier.

B. LA PERTINENCE D'UNE RÉGULATION EX ANTE DES PLATEFORMES LES PLUS STRUCTURANTES

La commission des lois du Sénat a été saisie au fond de l'ensemble du texte. Le rapporteur pour avis renvoie donc à ses travaux pour une présentation plus détaillée du texte, en particulier de son volet pénal. La proposition de loi appelle trois grandes observations du point de vue du rapporteur de la commission des affaires économiques.

1. D'importants doutes sur la « disposition phare » du texte : l'obligation de retrait en 24 heures (article 1er)

a) La « disposition phare » du texte fait peser un risque disproportionné d'atteinte à la liberté d'expression

La disposition la plus commentée de la proposition de loi, mais également la plus contestée, tant publiquement que lors des auditions menées par le rapporteur, figure aux alinéas 3 et 6 de l'article premier : l'obligation de retrait en 24 heures d'un contenu haineux notifié qui serait manifestement illicite sous peine de sanctions pénales .

Contenus concernés par l'obligation de retrait

|

Article |

Contenu |

Dans le champ du régime

|

Dans le champ du blocage administratif |

|

Cinquième alinéa de l'article 24 de la loi du 29 juillet 1881 sur la liberté de la presse |

Apologie des crimes suivants : - atteinte volontaire à la vie ou à l'intégrité de la personne, agression sexuelle, vol aggravé, extorsion, destruction, dégradation ou détérioration volontaire dangereuse pour les personnes, - crimes de guerre, crimes contre l'humanité, crimes de réduction en esclavage ou d'exploitation d'une personne réduite en esclavage, ou crimes et délits de collaboration avec l'ennemi, y compris si ces crimes n'ont pas donné lieu à la condamnation de leurs auteurs. |

Oui |

Non |

|

Septième alinéa de l'article 24 de la loi du 29 juillet 1881 sur la liberté de la presse |

Provocation à la discrimination, à la haine ou à la violence à l'égard d'une personne ou d'un groupe de personnes à raison de leur origine ou de leur appartenance ou de leur non-appartenance à une ethnie, une nation, une race ou une religion |

Oui |

Non |

|

Huitième alinéa de l'article 24 de la loi du 29 juillet 1881 sur la liberté de la presse |

Provocation à la haine ou à la violence à l'égard d'une personne ou d'un groupe de personnes à raison de leur sexe, de leur orientation sexuelle ou identité de genre ou de leur handicap ou ayant provoqué, à l'égard des mêmes personnes, aux discriminations prévues par les articles 225-2 et 432-7 du code pénal |

Oui |

Non |

|

Article 222-33 du code pénal |

Harcèlement sexuel |

Oui |

Non |

|

Article 225-4-1 du code pénal |

Traite des êtres humains |

Oui |

Non |

|

Articles 225-5 et 225-6 du code pénal |

Proxénétisme |

Oui |

Non |

|

Article 227-23 du code pénal |

- Captation, enregistrement, transmission, offre, mise à disposition, diffusion, importation ou exportation, acquisition ou détention d'image pornographique d'un mineur - Consultation habituelle ou en contrepartie d'un paiement d'un service de communication au public en ligne mettant à disposition des images pornographiques de mineurs |

Oui |

Oui |

|

Article 227-24 du code pénal |

Fabrication, transport, diffusion ou commerce de message violent ou pornographique susceptible d'être vu ou perçu par un mineur |

Oui |

Non |

|

Article 421-2-5 du code pénal |

Provocation directe à des actes de terrorisme ou apologie publique de ces actes |

Oui |

Oui |

|

Troisième et quatrième alinéas de l'article 33 de la loi du 29 juillet 1881 sur la liberté de la presse |

Injure publique commise envers une personne ou un groupe de personnes à raison de leur origine ou de leur appartenance ou de leur non-appartenance à une ethnie, une nation, une race ou une religion déterminée ou à raison de leur sexe, de leur orientation sexuelle ou identité de genre ou de leur handicap |

Non |

Non |

Il apparaît que cette disposition est surtout critiquée au regard des risques qu'elle fait peser sur la protection de la liberté d'expression considérée comme « un des droits les plus précieux de l'homme » par l'article 11 de la Déclaration des droits de l'Homme et du Citoyen de 1789 31 ( * ) . Le rapporteur fait siens les mots tenus par le professeur Annie Blandin lors de son audition : sur de tels sujets, il faut légiférer « la main tremblante ».

L'exemple de la loi allemande a d'ailleurs fait l'objet d'appréciations contrastées . Centrée sur les réseaux sociaux ayant plus de deux millions d'inscrits, elle prévoit, entre autres, une obligation supprimer dans les 24 heures les contenus manifestement illégaux, au regard d'une liste de plus de vingt infractions. Cependant, seuls les réseaux sociaux qui ne rempliraient pas leurs obligations de façon systématique peuvent être sanctionnés d'une amende pouvant aller jusqu'à 50 millions d'euros : la sanction n'est pas encourue à chaque absence de retrait. De plus, le dispositif permet aux plateformes de saisir un organisme agréé en cas de doute sur la qualification du contenu.

Bien que moins contraignant que le dispositif de la présente proposition de loi, la loi allemande a fait l'objet de très nombreuses critiques, notamment au regard des risques qu'elle ferait peser sur la liberté d'expression et sur la « privatisation » de la censure. Son application a déjà donné lieu à quelques polémiques à propos de retraits non justifiés. Lors d'une audition par la commission des lois de l'Assemblée nationale, le secrétaire d'État chargé du numérique Cédric O avait lui-même souligné les imperfections de la loi allemande : selon lui, celle-ci « n'a pas fait la preuve son efficacité » 32 ( * ) . Selon les informations recueillies par le rapporteur, une seule sanction a été prononcée, contre Facebook, pour défaut de motivation de suppression de contenu. En revanche, de nombreux recours ont été intentés contre la suppression de contenus. Compte tenu de certains de ses défauts, le Gouvernement allemand souhaiterait d'ailleurs déjà faire évoluer la loi.

Du point de vue de la commission des affaires économiques, la critique quant au risque d'atteinte à la liberté d'expression appelle les remarques suivantes :

- il apparaît évident que les plateformes tiendront un raisonnement de nature économique : elles préféreront retirer un contenu en cas de doute plutôt que de risquer le paiement automatique d'une amende dont le montant serait d'1,25 million d'euros par contenu non retiré dans les temps, sans que le contexte du retrait ne puisse être analysé - ce que permet, à l'inverse, la notion de « prompt retrait » figurant dans la LCEN. Autrement dit, il existe bien, en l'état du texte, un risque de sur-censure ;

- le principe du retrait en 24 heures après notification ne semble pas réellement efficace par rapport à l'objectif poursuivi : d'une part, cela ne permettrait pas aux opérateurs de prioriser les notifications en fonction de leur degré de gravité et d'importance, les obligeant à traiter tous les signalements de façon uniforme ; d'autre part, un contenu odieux et manifestement répréhensible par la loi, propagé massivement sur les réseaux sociaux, ne devrait-il pas être retiré dès que la plateforme en a connaissance, et non 24 heures après ? Quelle serait la réaction de nos concitoyens victimes de propos répréhensibles s'il leur était répondu que la plateforme ne sera pas condamnée car elle a retiré le contenu 23 heures et 59 minutes après la notification ?

- enfin, le retrait ou le déréférencement ne constituent pas les seuls moyens de lutter contre la diffusion d'un contenu : comme l'a souligné le rapport de la « mission Facebook », il y a également la mise en quarantaine, la décélération, la démonétisation, le rappel au règlement de la communauté, la pédagogie ciblée...

Par ailleurs, une telle disposition risquerait de conférer une responsabilité exorbitante, s'apparentant à une compétence régalienne, à des entreprises déjà qualifiées de « souveraines » par certains observateurs 33 ( * ) . En effet, elles se substitueraient au juge dans l'analyse des limites à poser à la liberté d'expression, sans que soit garanti le respect des droits de la défense. Pour le cas particulièrement grave des contenus terroristes, le projet de règlement présenté par la Commission européenne déjà évoqué envisage de se passer du contrôle du juge, mais il ne ferait partir le délai de retrait d'une heure qu'à compter de la notification par une autorité administrative compétente.

D'un point de vue économique en revanche, cette disposition ne semblerait pas disproportionnée tant qu'elle ne s'appliquerait qu'aux plus grandes plateformes . Le rapporteur rejoint cependant l'analyse du rapporteur de la commission des lois quant aux risques pesant sur la préservation des libertés fondamentales et de manque d'efficacité de la sanction pénale.

b) Une conformité au droit européen perfectible, soulignée par la Commission européenne

L'avis de la commission européenne, dont le rapporteur n'a eu connaissance que par voie de presse malgré la demande de transmission envoyée au Gouvernement, émet de substantielles réserves quant à la conformité de la proposition de loi au droit européen : elle « conclut qu'il existe un risque que le projet (...) viole les articles 3, 14 et 15§1 de la directive "e-commerce" ».

Selon l'avis, il n'est pas certain que l'exception au principe du pays d'origine que constitue la proposition de loi soit suffisamment ciblée dans son champ d'application personnel et proportionnée à l'objectif poursuivi dans les obligations mises à la charge des plateformes.

L'avis conteste en particulier les dispositions suivantes de la proposition de loi :

- l'article 1 er , en ce qu'il prévoit un délai de retrait obligatoire sans ménager une certaine flexibilité dans certains cas justifiés , « par exemple lorsque la nature du contenu nécessite une évaluation de son contexte plus conséquente qui ne pourrait être raisonnablement effectuée dans le délai », ce qui créerait une charge disproportionnée sur les plateformes et constituerait un risque d'atteinte à la liberté d'expression ;

- les articles 1 er bis et 1 er ter A, qui diminuent les exigences légales quant au contenu de la notification en vue de la simplifier, se heurteraient à la jurisprudence de la Cour de justice de l'Union européenne 34 ( * ) selon laquelle une notification ne saurait se révéler insuffisamment précise et étayée, en ce qu'il ne serait pas nécessaire d' identifier l'emplacement exact du contenu faisant l'objet de la notification ou d' identifier les dispositions légales prétendument enfreintes, ce qui, du reste, pourrait entraîner une violation du principe selon lequel les plateformes ne sont pas soumises à une obligation de surveillance générale des contenus.

Le rapporteur de la commission des lois propose des modifications des articles premier et suivants permettant de rendre le texte conforme aux observations de la Commission européenne, que le rapporteur soutient.

2. Une régulation ex ante pertinente, à rendre plus efficace et davantage proportionnée (articles 2, 3 et 4).

Les articles 2, 3 et 4 proposent de mettre un régulateur là où il n'y en a pas. Ce régulateur aurait la charge de préciser et de vérifier la bonne application des obligations définies par la loi. Il s'agirait d'une régulation dite ex ante , centrée sur des obligations de moyens, sur le modèle de la régulation bancaire, qui présenterait l'avantage de s'adapter à la réalité des pratiques et des modèles d'affaires en fonction de leur évolution.

La grande majorité des personnes auditionnées ont soutenu ce volet de la proposition de loi. Pour le rapporteur, c'est là que se situe le coeur de la proposition de loi et c'est de ces dispositions que dépendra l'efficacité de cette nouvelle régulation de la haine en ligne . C'est d'ailleurs l'approche prônée tant par la « mission Facebook » que par le livre blanc britannique sur les dommages en ligne 35 ( * ) . La régulation ex ante faisait également partie des orientations prônées par la commission d'enquête sénatoriale sur la souveraineté numérique pour mieux réguler ce secteur, et en particulier ses géants. Enfin, c'est également cette philosophie qui anime la proposition de loi visant à garantir la liberté de choix du consommateur dans le cyberespace précitée.

a) De nouvelles obligations de moyens à la charge des plateformes, dont la proportionnalité doit être assurée.

Les articles 2 et 3 introduisent un nouvel article 6-3 dans la LCEN. Cet article définirait les obligations à respecter par les opérateurs entrant dans le champ d'application de la loi.

Ils devraient :

- se conformer aux prescriptions édictées par le Conseil supérieur de l'audiovisuel ;

- mettre en place un dispositif de notification directement accessible et uniforme ;

- se conformer à des exigences procédurales une fois la notification reçue : accuser réception, informer le notifiant des suites données à la notification, des risques encourus en cas de notification abusive et des motifs de la décision dans un certain délai, permettre au notifiant comme à l'auteur du contenu de contester la décision ;

- mettre en oeuvre les procédures et les moyens humains et, le cas échéant, technologiques proportionnés permettant de garantir le traitement approprié et dans les meilleurs délais des notifications reçues ;

- mettre à disposition une information publique, claire et détaillée, facilement accessible et visible, permettant d'informer leurs utilisateurs sur les modalités générales du dispositif qu'ils mettent en place pour la modération de ces contenus, sur les sanctions encourues par les auteurs des contenus ou par les auteurs de notifications abusives, sur les dispositifs de recours et sur les acteurs en mesure d'accompagner les victimes de propos haineux illicites ;

- rendre compte auprès du régulateur des moyens humains et technologiques mis en oeuvre et des résultats obtenus, le régulateur décidant ensuite lesquelles de ces informations peuvent être rendues publiques ;

- formuler en termes précis les conditions générales d'utilisation relatives aux contenus haineux ;

- désigner un représentant légal exerçant les fonctions d'interlocuteur référent des pouvoirs publics ;

- prévoir une information du mineur ou des titulaires de l'autorité parentale lors de son inscription sur les risques encourus en cas de diffusion de contenus haineux illicites.

En l'état, le texte ne prévoit pas de modulation de ces obligations selon la gravité des contenus et leur niveau d'exposition ou selon le type de plateforme concernée. Or, les modèles d'affaires des plateformes susceptibles d'être concernées par le texte sont souvent différents. Il serait ainsi contestable que Wikipédia ait à respecter des obligations strictement similaires à Facebook, alors que les enjeux de lutte contre les contenus haineux sont bien différents sur l'une et l'autre plateforme 36 ( * ) . Pis, une application uniforme à toutes les plateformes risquerait de favoriser les plus importantes d'entre elles et les mieux avancées dans la modération, au détriment de leurs concurrents actuels et futurs. Il ne faudrait pas conférer un avantage aux plateformes les plus avancées sur le marché de la modération en érigeant des barrières réglementaires disproportionnées.

C'est pourquoi la commission a adopté un amendement exigeant que les obligations mises à la charge des plateformes soient proportionnées et nécessaires au regard tant des capacités dont elles disposent que de l'atteinte susceptible d'être portée à la dignité humaine par les contenus concernés ( AFFECO.2 ) .

Par ailleurs, conformément aux observations de la Commission européenne, la commission a adopté un amendement supprimant l'obligation de « mettre en oeuvre les moyens appropriés pour empêcher la rediffusion de contenus » haineux illicites (dite obligation de « stay-down »), car, en ce qu'elle imposerait aux plateformes une obligation de surveillance générale, elle contreviendrait au droit européen 37 ( * ) ( AFFECO.3 ).

b) La nécessité d'un régulateur en vue de créer un dialogue pérenne et encadré entre les pouvoirs publics, les acteurs régulés et la société civile

L'article 4 de la proposition de loi confie au Conseil supérieur de l'audiovisuel (CSA) la charge de réguler les acteurs économiques dans leurs comportements de modération des propos haineux illicites en ligne. Autrement dit, le régulateur ne devra pas apprécier au cas par cas les contenus notifiés mais, de façon systémique, les moyens mis en oeuvre pour lutter contre la haine en ligne.

Le CSA est apparu le régulateur le plus indiqué dans la mesure où il s'agit d'une régulation se situant davantage dans le champ des libertés fondamentales que dans le champ économique, dans la continuité de la mission qui lui a été confiée par la loi de 1986 relative à la liberté de communication 38 ( * ) . De plus, le CSA régule de plus en plus d'activités en ligne (loi sur la manipulation de l'information 39 ( * ) , directive « services de médias audiovisuels » révisée dont la transposition devra encore être assurée 40 ( * ) ).

Il serait doté d'un pouvoir réglementaire d'application de la loi, d'un pouvoir de recommandation permettant d'orienter les acteurs et d'un pouvoir de sanction en cas de manquement des acteurs à leurs obligations. Il pourra, par ailleurs, pratiquer le « name and shame » en publiant chaque année un bilan de l'application de leurs obligations. Il sera, enfin, en mesure de recueillir toutes les informations nécessaires au contrôle de leurs obligations, sans que le secret des affaires puisse lui être opposé. Il aura également la tâche d'encourager la coopération entre plateformes. La commission a proposé de préciser ce dernier point en insérant que cette coopération pouvait porter sur le partage d'informations afin de rendre le dispositif plus efficace ( AFFECO.4 ).

Le dispositif de régulation ne sera crédible qu'à la condition de prévoir une sanction potentiellement très élevée. Le seuil de 4 % du chiffre d'affaires global, qui s'inspire, entre autres, de l'article 18 du projet de règlement relatif au retrait de contenus terroristes, apparaît bienvenu à cet égard.

Enfin, afin d'éviter le report d'usagers coutumiers des propos haineux illicites vers des plateformes qui échapperaient à toute obligation de lutte contre la diffusion de tels contenus, la commission a entendu doter le régulateur d'un pouvoir d'évocation pour les opérateurs ne dépassant pas les seuils définis par décret qui détermineront le champ d'application ( AFFECO.1 ).

Il conviendra cependant que le régulateur soit doté des moyens suffisants pour exercer ses nouvelles fonctions. Le rapport visant à renforcer la lutte contre le racisme et l'antisémitisme sur internet estimait le besoin entre 30 et 50 personnes. Selon le jaune budgétaire relatif aux autorités administratives et publiques indépendantes annexé au projet de loi de finances 2020, en prévision de la nouvelle mission confiée par la proposition de loi, « un relèvement du plafond des emplois autorisés à 290 équivalents temps plein travaillé (ETPT) au lieu de 284 ETPT, soit 6 équivalents temps plein (ETP) supplémentaires ». Selon les informations transmises au rapporteur, le CSA devrait renforcer ses équipes en profils disposant d'une expertise forte en matière de traitement de la donnée en masse ( data scientists ), de connaissance des algorithmes et de modalités techniques de fonctionnement des plateformes. La fusion à venir avec l'Hadopi dans le cadre du projet de loi audiovisuel pourrait également permettre à l'Autorité de redéployer quelques emplois. Enfin, le Gouvernement entend mettre en place, à l'occasion du projet de loi sur l'audiovisuel, un service à compétence nationale mutualisant les compétences numériques de haut niveau pour répondre aux besoins des administrations et des régulateurs, qui pourra être mobilisé.

Par ailleurs, il conviendrait que l'observatoire de la haine en ligne prévu à l'article 7 soit hébergé par le CSA. La nécessité de créer un tel observatoire, qui serait une instance de dialogue et de collecte des données pertinentes relatives à la manifestation de la haine en ligne, fait l'objet d'un certain consensus. Les associations professionnelles du numérique ont d'ailleurs souligné l'existence informelle d'une telle instance en matière de lutte contre le terrorisme depuis 2015 (« groupe de contact permanent » avec le ministère de l'Intérieur), dont cet observatoire pourrait s'inspirer.

c) Un nouveau modèle de régulation du numérique ?

Le texte examiné propose un nouveau modèle de régulation du numérique, qui comporte trois grandes caractéristiques : un régulateur spécialisé, des obligations de moyens et une régulation qui s'applique en priorité aux acteurs les plus structurants du marché.

Une régulation qui s'applique de façon prioritaire aux plus grands, c'est-à-dire une régulation asymétrique, est la seule façon de permettre à d'éventuels nouveaux entrants de pénétrer le marché 41 ( * ) ! Sur ce point, le texte est assez évasif quant aux critères que le Gouvernement entend retenir pour déterminer ces plateformes structurantes.

En l'état, la proposition de loi s'appliquerait à toutes les plateformes 42 ( * ) « qui proposent un service de communication au public en ligne reposant sur la mise en relation de plusieurs parties en vue du partage de contenus publics ou sur le classement ou le référencement, au moyen d'algorithmes informatiques, de contenus proposés ou mis en ligne par des tiers et dont l'activité sur le territoire français dépasse des seuils déterminés par décret sont tenus ». Autrement dit, sont principalement visés les réseaux sociaux et les moteurs de recherche 43 ( * ) , s'ils dépassent les critères qui seront définis par décret.

L'argumentaire transmis à la Commission européenne par le Gouvernement se limite à expliquer que le dispositif a « vocation à s'appliquer essentiellement aux grandes plateformes qui disposent de ressources substantielles pour faire face à leur responsabilité. La loi épargnera en revanche les plus petites plateformes. » La commission européenne a soulevé, dans son avis, que « le champ d'application du projet notifié reste vague ».

Il apparaît nécessaire que le Gouvernement retienne une pluralité de critères afin de bien cibler le dispositif sur les plateformes sur lesquelles les enjeux sont les plus prégnants. Un simple seuil de connexion ne suffirait pas à éviter d'imposer des obligations disproportionnées à des services émergents, sauf à ce qu'il soit particulièrement élevé. Le rapporteur souligne que l'association d'un critère relatif à la viralité des contenus à celui de l'audience de la plateforme serait conforme à l'idée « d'accélérateurs de contenus » dégagée par le rapport visant à renforcer la lutte contre le racisme et l'antisémitisme sur internet.

|

Les seuils actuellement en vigueur Le code de la consommation et le décret d'application de la loi sur les fausses informations retiennent un critère unique de cinq millions de visiteurs uniques par mois, par plateforme, calculé sur la base de la dernière année civile 44 ( * ) . Médiamétrie publie une liste des 50 marques les plus visitées en France, ce qui correspond à un seuil de 13,2 millions de visiteurs uniques par mois 45 ( * ) . Y figurent notamment le coeur de cible de la proposition de loi, à savoir Facebook, YouTube, Instagram, Snapchat, Twitter, mais aussi d'autres sites reposant sur la mise en relation de plusieurs parties en vue du partage de contenus publics, tels que Wikipédia, Leboncoin.fr, LinkedIn. |

3. Un dispositif peu lisible et inapplicable de lutte contre les « contenus miroirs »

Aujourd'hui, les FAI coopèrent pleinement aux demandes de blocage judiciaire pour tout contenu illicite ou de blocage administratif pour les contenus terroristes et pédopornographiques.

L'article 6 du texte examiné propose, d'une part, de supprimer le principe de subsidiarité inscrit dans la LCEN - qui exige du juge judiciaire de se tourner en premier lieu vers l'hébergeur du contenu, et dans un second temps, vers le fournisseur d'accès à internet ; d'autre part, de créer un nouveau dispositif de blocage mixte, c'est-à-dire mélangeant demande administrative et décision judiciaire 46 ( * ) .

Sur le premier point, la jurisprudence permet au juge d'ordonner le blocage directement à l'opérateur s'il a de fortes raisons de croire que l'hébergeur ne se conformera pas à l'injonction de blocage. Le droit en vigueur ménage donc un équilibre satisfaisant entre, d'une part, la nécessité d'agir vite, d'autre part, celle d'agir d'abord à la source - c'est-à-dire vers l'auteur et l'hébergeur. La nécessité de supprimer le principe pour tous les cas d'illicéité constatés dans la loi mériterait une instruction plus approfondie .

Sur le second point, il s'agit de lutter plus efficacement contre la propagation de « contenus miroirs » en permettant à l'autorité administrative d'obtenir le blocage de la reprise partielle ou totale de contenus reconnus comme propos haineux illicites. En l'état, il apparaît à la fois ambigu et inapplicable.

Il est ambigu car il vise à bloquer l'accès à « tout site, tout serveur ou à tout autre procédé électronique donnant accès aux contenus jugés illicites », autrement dit, il permettrait de bloquer un site entier pour la simple raison qu'un contenu illicite y figure. Or, le blocage dit « DNS » (pour Domain Name Server ) 47 ( * ) actuellement pratiqué par les FAI ne permet pas de bloquer des contenus particuliers sur une page (ex : un tweet ) ou une seule et unique page d'un site (ex : une page Facebook) : il permet seulement le blocage d'un site entier.

De plus, il vise les fournisseurs de nom de domaine mais, d'une part, compte tenu des attributions respectives de l'Icann 48 ( * ) , de l'Afnic 49 ( * ) et des différents bureaux d'enregistrement comme de l'absence de définition juridique des fournisseurs de noms de domaine, l'obligation de blocage serait difficile à mettre en oeuvre. Elle serait, d'ailleurs, largement inefficace dans la mesure où ils ne pourraient que remettre en cause l'attribution de l'adresse URL et non procéder à un blocage.

Au demeurant, s'il revêtait une portée obligatoire, il serait sans doute nécessaire de prévoir une compensation des coûts de mise en conformité, comme cela existe dans le cadre des procédures de blocage des sites de jeux illégaux 50 ( * ) .

En réalité, cette disposition n'est accompagnée d'aucune sanction : elle n'est donc pas contraignante. De plus, elle prévoit seulement que l'autorité administrative « peut demander » à ces acteurs de prendre ces mesures, contrairement aux blocages dits « mixtes » actuellement en vigueur, qui reposent sur une mise en demeure par une autorité administrative indépendante de régulation sectorielle. Or, une autorité administrative peut, dans les faits, déjà demander à ces acteurs d'agir pour faire cesser un dommage. En cas de refus, elle doit alors se tourner vers le juge. La disposition proposée apparaît donc superfétatoire en ce qu'elle ne semble rien ajouter au droit en vigueur.

C'est pour ces raisons que la commission soutient la suppression de l'article 6 proposée par le rapporteur de la commission des lois.

Comme l'a souligné la Fédération Française des Télécoms devant le rapporteur, il est surtout nécessaire de renforcer les moyens alloués à la justice et à l'OCLCTIC afin de mieux lutter contre la réapparition d'un site manifestement haineux, à l'image de l'exemple souvent cité du site « Démocratie participative » ouvertement raciste et antisémite.

EXAMEN EN COMMISSION

Réunie le mardi 10 décembre 2019, la commission a examiné le rapport pour avis de M. Yves Bouloux sur la proposition de loi n° 645 (2018-2019) visant à lutter contre les contenus haineux sur internet.

Mme Sophie Primas , présidente . - Nous écoutons le rapport pour avis d'Yves Bouloux sur la proposition de loi visant à lutter contre les contenus haineux sur internet.

M. Yves Bouloux , rapporteur pour avis . - Cette proposition de loi pose une question légitime. Si le phénomène est encore peu documenté, chaque utilisateur des réseaux sociaux peut constater que des propos haineux, répréhensibles par la loi, s'y répandent quotidiennement.

Néanmoins, la réponse apportée à cette question apparaît inaboutie, même s'il faut avoir l'humilité de reconnaître qu'aucune solution simple n'existe. La commission des lois devrait aller plus loin que nous dans la mesure où le texte pose surtout problème au regard de la protection des libertés publiques. D'un point de vue économique, le texte s'appliquera en priorité aux plateformes les plus structurantes et les obligations qui y figureront seront proportionnées, de sorte qu'elles seront soutenables par les acteurs économiques concernés. Notre commission s'est saisie de cette proposition de loi car elle modifie la loi pour la confiance dans l'économie numérique de 2004 (LCEN) dont nous avions été saisis au fond. De plus, si son objectif relève de la protection des libertés fondamentales, elle affecte l'économie numérique, qui est aujourd'hui au coeur de la compétence de notre commission.

Tout d'abord, je souhaite revenir sur le cadre juridique applicable et issu de la LCEN, qui transposait la directive européenne dite « e-commerce » . Elle pose un principe de responsabilité - mais de responsabilité limitée - des hébergeurs de contenus, c'est-à-dire de la plupart des sociétés chargées d'héberger des sites internet, mais qui ne choisissent pas les contenus concernés. Ce principe se traduit concrètement par une obligation de prompt retrait de tout contenu manifestement illicite qui leur aurait été notifié par les utilisateurs, sous peine d'engager leur responsabilité civile ou pénale. Cela recouvre à la fois les contenus haineux illicites, mais aussi les contenus frauduleux, les atteintes au droit d'auteur, etc. L'objectif poursuivi à l'époque - nous étions au début des années 2000 - était à la fois de préserver la liberté d'expression en ligne, mais aussi de favoriser le développement des services sur internet. Ce régime est de plus en plus remis en cause compte tenu du poids et du rôle acquis par certaines plateformes en ligne. Par exemple, au regard de la protection des consommateurs, la persistance de produits frauduleux sur les places de marché en ligne pourrait plaider en faveur du renforcement de leur responsabilité. La question de la remise en cause de cette responsabilité limitée se pose actuellement au niveau européen. La nouvelle commission s'empare du sujet dans le cadre du Digital Services Act qu'elle entend mener à bien dans les années à venir.

S'agissant des contenus haineux illicites, le législateur français est déjà intervenu pour obliger les plateformes à mettre en place un dispositif de signalement facilement accessible et visible, à informer promptement les autorités publiques lorsqu'elles ont connaissance de tels contenus, et à rendre publics les moyens qu'elles y consacrent. Par ailleurs, la Commission européenne a déjà obtenu des progrès de la part des plateformes dans le cadre d'un code de conduite, attestés par des rapports d'évaluation périodiques. Selon ces rapports, les plateformes analyseraient dans les 24 heures 89 % des contenus signalés et 72 % des contenus considérés comme des discours de haine illégaux seraient supprimés. Facebook mobiliserait 15 000 personnes réparties sur une vingtaine de sites dans le monde pour modérer les contenus.

Ensuite, la proposition de loi qui nous intéresse entend aller plus loin. Elle prévoit deux mesures. La première consiste à renforcer la législation en créant un nouveau délit de non-retrait sous 24 heures des contenus haineux manifestement illicites. Cette disposition n'appelle que peu de remarques de la part d'un rapporteur de la commission des affaires économiques dans la mesure où elle pose essentiellement des questions quant au risque de sur-censure, quasi unanimement soulevé lors de nos auditions. Tout au plus peut-on se limiter à souligner que, face au risque d'une sanction pénale en cas de non-retrait, les acteurs économiques seront incités à retirer massivement les contenus, de sorte que le risque de sur-censure est bien caractérisé. Par ailleurs, le fait de fixer un seuil de 24 heures ne semble pas efficace : d'une part, il serait choquant qu'un contenu manifestement illicite et massivement diffusé mais retiré à 23h59 n'entraîne aucune mise en cause de la responsabilité de la plateforme, et d'autre part, le fait de devoir traiter tous les contenus indistinctement en 24 heures empêcherait d'effectuer une priorisation, de sorte que les contenus vraiment problématiques pourraient, in fine, ne pas être retirés. Enfin, faire peser sur des entreprises, fussent-elles très puissantes, une responsabilité qui appartient à l'État, à savoir juger des contenus haineux manifestement illégaux, apparaît exorbitant. C'est pourquoi je soutiens le parti pris par notre collègue de la commission des lois de faire évoluer de manière significative ce dispositif.

Je souhaite surtout m'arrêter sur le second point essentiel de cette proposition de loi, à savoir la régulation dite ex ante . Elle confie à un régulateur - en l'espèce, le Conseil supérieur de l'audiovisuel (CSA) - la mission de réguler les plateformes quant aux moyens qu'elles mettent en oeuvre pour lutter contre la haine en ligne, selon deux axes : l'efficacité et le respect des utilisateurs. Selon l'avis de la très grande majorité des personnes auditionnées, ce dispositif est bienvenu, car il permettra d'établir un dialogue entre les autorités publiques et les plateformes afin d'améliorer la lutte contre la haine en ligne. Ce volet du texte rejoint à la fois les orientations de la commission d'enquête sur la souveraineté numérique et celles de la proposition de loi de notre commission visant à garantir le libre choix du consommateur dans le cyberespace. Il s'agit de mettre un régulateur là où il n'y en a pas pour construire, de façon agile et évolutive, les bonnes pratiques à mettre en place destinées à lutter contre la haine en ligne. En cas d'insuffisance du dispositif mis en place par la plateforme, le régulateur pourra sanctionner fermement les opérateurs en question : cette régulation sera crédible car elle s'appuiera sur d'importantes sanctions financières : jusqu'à 4 % du chiffre d'affaires mondial ! Ce n'est pas rien !

Il apparaît toutefois nécessaire d'améliorer le texte sur ce volet. C'est pourquoi je vous propose quatre pistes d'amélioration. La première consiste à éviter que des plateformes qui ne correspondent pas aux seuils qui seront établis par décret, mais sur lesquelles il existe un défaut caractérisé de lutte contre la haine en ligne, puissent échapper à la supervision du régulateur. Le CSA pourrait donc imposer certaines obligations à ces plateformes sous les seuils, afin d'éviter le déport des auteurs de propos haineux vers d'autres sites qui ne seraient pas soumis à la réglementation. De cette façon, la balance entre liberté d'entreprendre et protection de la dignité humaine serait garantie.

La deuxième consiste à s'assurer que les obligations mises à la charge des plateformes seront proportionnées tant à la capacité des plateformes à les mettre en oeuvre qu'à l'ampleur du risque du préjudice, lequel croît nécessairement à mesure du nombre de vues. Autrement dit, il s'agit de s'assurer que le dispositif sera adapté au modèle d'affaires des plateformes et prendra en compte la viralité du contenu.

Par ailleurs, et c'est ma troisième piste, nous ne pouvons ignorer que la Commission européenne a émis un avis particulièrement réservé sur la proposition de loi quant à sa conformité au regard du droit européen. Sur ce volet de la proposition de loi, elle a en particulier pointé une disposition particulièrement problématique au regard du droit européen car elle imposerait une obligation générale de surveillance des contenus publiés sur la plateforme. C'est pourquoi je propose de supprimer ce point.

Enfin, quatrième piste d'amélioration, le texte prévoit que le régulateur pourra encourager les plateformes à coopérer pour lutter contre la diffusion de contenus haineux répréhensibles par la loi. Je propose de préciser que cette coopération pourra également porter sur le partage d'informations entre plateformes. Cela pourrait conduire à la création d'un pot commun de données afin de renforcer l'efficacité du dispositif.

Je conclurai par quelques remarques générales. Si l'on prend du recul, on s'aperçoit que ce texte propose un nouveau modèle de régulation du numérique. Il comporte trois grandes caractéristiques : un régulateur spécialisé, des obligations de moyens et une régulation qui s'applique en priorité aux acteurs les plus structurants du marché, ceux qui ont un impact massif.

Une régulation qui s'applique avant tout aux plus grands, et représente donc une régulation asymétrique, est la seule façon de permettre à d'éventuels nouveaux entrants de pénétrer le marché ! Sur ce point, le texte est assez évasif quant aux critères que le Gouvernement entend retenir pour déterminer ces plateformes structurantes. Il apparaît nécessaire que le Gouvernement retienne une pluralité de critères afin de bien cibler le dispositif sur les plateformes où les enjeux sont les plus prégnants.

Quelques mots enfin, sur la méthode adoptée par le Gouvernement. Alors que le Gouvernement a réfléchi au sujet pendant de longs mois, il est dommage qu'il ait choisi de faire déposer à la hâte une proposition de loi mal ficelée, largement remaniée suite à l'avis du Conseil d'État. Elle pourrait d'ailleurs être à nouveau retouchée à la faveur de l'adoption de différents textes abordant le même thème tant au niveau français qu'au niveau européen. Surtout, je déplore que le Gouvernement n'ait pas jugé nécessaire de nous transmettre l'avis de la Commission européenne. Malgré nos demandes, nous avons dû en prendre connaissance par voie de presse ! De même, je n'ai reçu les réponses à mon questionnaire écrit, envoyé le 8 octobre, que le 4 décembre, soit moins d'une semaine avant le passage en commission. Cependant, nous ne pouvons que soutenir l'option politique retenue par le Gouvernement, consistant à agir d'abord à l'échelon national, dans l'attente d'une réponse pérenne au niveau européen. Cette approche rejoint celle que notre commission a adoptée à travers la proposition de loi sur le libre choix du consommateur dans le cyberespace. Espérons que le Gouvernement soit aussi allant sur ce sujet tout aussi fondamental !

M. Pierre Cuypers . - Dispose-t-on des moyens techniques pour identifier des propos haineux ?

M. Franck Montaugé . - Certains éléments de cette proposition de loi rejoignent les propositions de la commission d'enquête sur la souveraineté numérique, que j'ai eu l'honneur de présider. La définition de la plateforme systémique est compliquée mais il faut, je crois, en passer par là. Il nous paraît indispensable de placer sous l'autorité d'un régulateur indépendant les opérations de régulation ex ante .

L'auditabilité des algorithmes n'a pas été évoquée. Elle conditionne toutefois le fonctionnement des plateformes. Lorsqu'elles laissent passer des choses, c'est que les algorithmes le permettent, car ils représentent le point d'entrée de tous les systèmes. Nous pourrions aborder ce thème en séance.

Nous regrettons la présentation hâtive de ce texte. J'ai compris que le Président de la République souhaitait se rendre au prochain dîner du Conseil représentatif des institutions juives de France (CRIF) pour y présenter la traduction des engagements qu'il avait pu formuler. Ce sujet est sérieux et aurait mérité d'y consacrer davantage de temps.

Mme Anne-Catherine Loisier . - Je salue la volonté de ne pas laisser les plateformes s'emparer de la régulation - je pense au projet de « cour suprême » de Facebook . Il est important que l'État reprenne la main sur ces sujets. Il est également nécessaire que la question soit prise en considération au niveau européen. Il va y avoir 28 législations, 28 types de sanctions. L'applicabilité pourrait être compliquée et derrière, il existe un véritable enjeu : la réouverture de la directive e-commerce et le Digital Services Act .

Mme Élisabeth Lamure . - Pour quelles raisons la Commission européenne est-elle aussi frileuse sur ces questions ? Quels sont ses arguments ? C'est difficile à comprendre car tous les pays sont concernés.

M. Yves Bouloux , rapporteur pour avis . - Notre capacité à détecter les propos haineux dépend des propos tenus. S'il faut tenir compte du contexte, cela ne peut pas être automatisé. Le régulateur qu'est le CSA devra être doté des moyens nécessaires.

Je partage les remarques de Franck Montaugé. Les algorithmes sont un vrai sujet. Effectivement, à ce stade, ils ne sont pas abordés dans ce texte.

M. Franck Montaugé . - Nous n'en sommes qu'au stade de la commission !

M. Yves Bouloux , rapporteur pour avis . - Comme le dit très bien Anne-Catherine Loisier, il s'agit d'un sujet de régulation complexe et en construction.

Les réticences de la Commission européenne sur ce texte s'expliquent par des raisons juridiques liées à la directive sur le commerce électronique.

Sachez que nous avons travaillé en excellente intelligence tant avec la commission des lois, qui examine le texte au fond, qu'avec la commission de la culture, qui s'est également saisie pour avis. Je présenterai demain l'avis de notre commission devant la commission des lois.

M. Franck Montaugé . - Le noeud central, c'est le modèle économique des plateformes, qui ont un statut d'hébergeur et non d'éditeur. Si on les mettait au même niveau que la presse, leur modèle s'écroulerait. Cela explique le comportement des acteurs. Devant la commission d'enquête sur la souveraineté numérique, les hébergeurs nous ont fait part de leur refus d'une responsabilité accrue sur les données qu'ils hébergent.

Mme Anne-Catherine Loisier . - J'ajoute que certaines de ces données ne sont pas hébergées en France. La réglementation américaine interdit la transmission de toutes les données relatives aux citoyens américains.

M. Yves Bouloux , rapporteur pour avis . - La LCEN est un outil intéressant, avec notamment la distinction entre éditeur, hébergeur et fournisseur d'accès à internet : chacun a son rôle et ses responsabilités.

EXAMEN DES AMENDEMENTS

M. Yves Bouloux , rapporteur pour avis . - Je vais vous présenter quatre amendements ciblés sur le dispositif de régulation administrative. Ils ont été élaborés en bonne intelligence avec la commission des lois.

L'amendement AFFECO.1 vise à éviter le report d'usagers habitués à tenir des propos haineux illicites vers des plateformes non régulées. Le régulateur pourrait ainsi, sur décision motivée et en application de critères définis par décret, imposer des obligations de lutte contre la haine en ligne aux plateformes qui n'entreraient pas dans le champ de la régulation administrative.

M. Franck Montaugé . - Nous sommes favorables à cet amendement et nous le voterons, mais qu'est-ce qu'un « rôle significatif » ? Il faudra que cette notion soit définie.

M. Yves Bouloux , rapporteur pour avis . - Effectivement, cette notion sera définie par décret.

L'amendement AFFECO.1 est adopté.

M. Yves Bouloux , rapporteur pour avis . - L'amendement AFFECO.2 a pour objet de s'assurer que les obligations imposées aux plateformes prendront en compte les capacités de chacune à mettre en oeuvre des moyens de lutte contre la haine en ligne et qu'elles seront adaptées à l'ampleur du risque d'atteinte à la dignité humaine. En effet, toutes les plateformes ont des modèles d'affaires différents : certaines permettent de publier du contenu éphémère, d'autres du contenu conservé sur un fil d'actualité. En outre, il faut tenir compte de la viralité des contenus, qui détermine l'ampleur du préjudice subi.

L'amendement AFFECO.2 est adopté.

M. Yves Bouloux , rapporteur pour avis . - Une des dispositions de la proposition de loi instaure, à la charge des hébergeurs, une obligation de surveillance générale des contenus. Elle est incompatible avec le droit européen en vigueur. L'amendement AFFECO.3 vise donc à la supprimer.

L'amendement AFFECO.3 est adopté.

M. Yves Bouloux , rapporteur pour avis . - La proposition de loi prévoit que le régulateur pourra encourager la coopération entre plateformes pour lutter contre la diffusion des contenus haineux illicites. Notre amendement AFFECO.4 vise à compléter ce dispositif en prévoyant également le partage d'informations entre plateformes.

Mme Anne-Catherine Loisier . - C'est d'ailleurs une demande des plateformes, qui souhaitent mutualiser leurs recherches. C'est une disposition de bon sens.

L'amendement AFFECO.4 est adopté.

LISTE DES PERSONNES ENTENDUES

Mardi 8 octobre 2019

- Mission « régulation des réseaux sociaux - expérimentation Facebook » - Ministère de l'Économie et des Finances - Secrétariat d'État chargé du numérique : MM. Frédéric POTIER (préfet - délégué interministériel de la délégation interministérielle à la lutte contre le racisme, l'antisémitisme et la haine anti-LGBT) et Benoît LOUTREL (inspecteur général à l'Institut national de la statistique et des études économiques).

- Conseil supérieur de l'audiovisuel : MM. Roch-Olivier MAISTRE , président, et Yannick FAURE , directeur de cabinet.

- Snap Inc. (Snapchat) : M. Jean GONIÉ , directeur des affaires publiques pour l'Europe.

Mercredi 9 octobre 2019

- La Quadrature du Net : MM. Martin DRAGO et Arthur MESSAUD , juristes.

- Conseil national du numérique : M. Charles-Pierre ASTOLFI , secrétaire général, Mme Marylou LE ROY , responsable juridique et des affaires institutionnelles.