III. CLARIFIER, ÉVALUER, VALORISER : CONSTRUIRE UNE VÉRITABLE POLITIQUE PUBLIQUE DE LA FORMATION CONTINUE

A. CRÉER UN PARCOURS DE FORMATION PAR LE DÉPLOIEMENT D'OUTILS INFORMATIQUES ADAPTÉS

1. Un suivi de la formation continue qui doit passer par la mise en place de nouveaux outils informatiques

Comme cela a été largement développé plus haut, les outils informatiques dont dispose le ministère, obsolètes et limités, ne permettent pas de suivre le parcours de formation des enseignants tout au long de leur carrière, sans compter qu'il n'existe qu'une traçabilité très faible des moyens financiers. Il est donc urgent de disposer d'un système d'information plus adapté, à la fois sur le volet budgétaire et sur le volet ressources humaines.

Concernant le premier aspect, le ministère a lancé le projet de logiciel Virtuo, dont l'objectif est de permettre de dépasser la gestion actuelle pour retracer les formations et aboutir à une cartographie des compétences, en remplaçant Gaia. Cet outil, qualifié de future « révolution » par la direction des ressources humaines lors de son audition, devait initialement être déployé à la fin 2024. Cette première échéance a déjà fait l'objet d'ajustements, et Virtuo devrait être en place d'ici à la fin 2025, sous réserve de ne pas être repoussé une nouvelle fois.

Il est certain que Virtuo est un projet coûteux et de grande ampleur. Le ministère a ainsi indiqué au rapporteur spécial que le coût total de Virtuo était de 20,8 millions d'euros sur 8 ans. Mais le rapporteur spécial insiste sur le fait que la mise en place d'un nouveau système n'est pas une option dans l'objectif de déploiement d'une réelle gestion des ressources humaines de proximité voulu par le ministère. À ce titre, Virtuo ne doit pas être considéré comme une variable d'ajustement, d'autant plus qu'une partie des montants ont déjà été engagés.

En revanche, le rapporteur spécial attire l'attention sur la nécessaire réflexion sur l'utilisation des données et des informations contenues dans Virtuo. En particulier, dans la mesure où le logiciel est amené à recouper un certain nombre d'informations sur les formations suivies par les enseignants tout au long de leur carrière, se pose par exemple la question de l'accès des chefs d'établissement à ces données. Enfin, il semble indispensable que le nouveau logiciel soit également pensé comme un portail national d'information et de recensement des formations proposées, afin d'améliorer la lisibilité de l'offre par rapport à Gaia. Il conviendrait sur ce point de s'inspirer des bonnes pratiques de certaines académies. Selon le rapport de 2020 de l'IGESR, l'académie de Créteil a par exemple relié la base de données des formations dispensées (public, thématique, formateur...) à un logiciel de cartes géographiques afin de pouvoir disposer de données objectives et précises selon des critères multiples (type de formation, public cible, zone géographique...) créant ainsi un outil de cartographie dynamique.

L'enjeu principal de pilotage est d'opérer une véritable coordination entre toutes les bases de données et les informations existantes au niveau académique ou infra-académique, dans l'objectif de disposer d'une véritable consolidation des informations au niveau national.

Recommandation n° 4 : développer rapidement un outil informatique permettant de disposer au niveau national d'un suivi budgétaire fin et d'une base de données dynamique sur les formations suivies par les enseignants.

2. Développer la politique d'évaluation de la formation continue

Selon le rapport de l'IGESR de 2020 précédemment mentionné, l'évaluation constitue le « point faible du dispositif » de formation continue, ajoutant que « s'il existe une prise de conscience de l'existence de marges de progrès importantes sur le sujet, les réflexions engagées demeurent modestes et non prioritaires ».

D'une part, le dispositif d'évaluation est plus que lacunaire, au point qu'une part très importante des formations ne contient pas de module de suivi ou d'évaluation d'impact une fois les enseignants de retour devant leurs classes. D'après l'enquête Talis, seuls 27 % des enseignants français déclarent que leur formation prévoyait des activités de suivi contre 52 % dans l'OCDE.

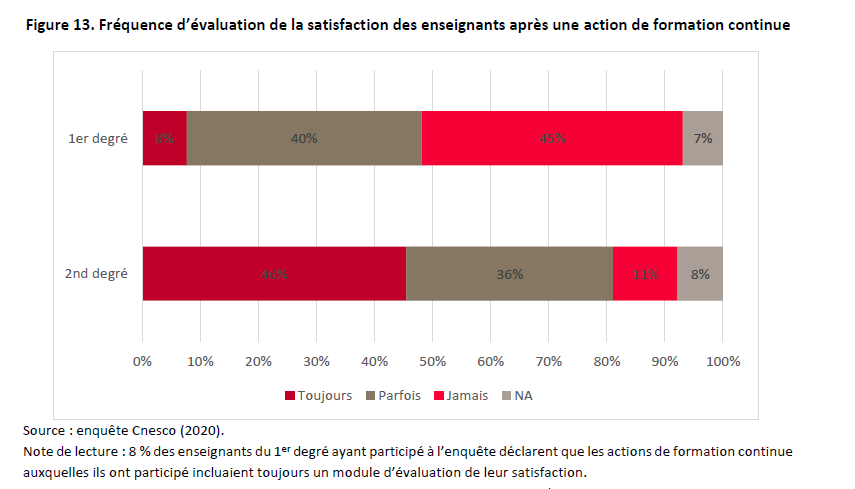

D'autre part, lorsqu'une évaluation de la formation existe, elle relève davantage de l'enquête de satisfaction des enseignants que d'une réelle mesure de l'impact de la formation sur leurs pratiques pédagogiques. Celles-ci sont plus fréquentes, et concernent d'après l'enquête du Cnesco 90 % des enseignants du second degré mais uniquement 55 % de ceux du premier degré.

Évaluation de la satisfaction des

enseignants

après le suivi d'une formation continue

(en %)

Source : Cnesco

Les indicateurs suivis par le ministère se concentrent sur le volet quantitatif (nombre de modules suivis, nombre de diplômés, taux de participation, etc), mais ne permettent aucunement de déterminer l'efficacité de ces formations et leur effet sur les apprentissages des élèves.

Cela semble d'autant plus regrettable que, d'après les enquêtes auprès des enseignants, peu déclarent qu'ils considèrent l'impact de la formation suivie comme étant positif. D'après la direction de l'évaluation, de la prospective et de la performance (DEPP), dans le premier degré, les enseignants français sont 62 % à déclarer qu'au moins une des formations suivies au cours des douze derniers mois a eu un impact positif sur leur manière d'enseigner, ce qui est beaucoup moins que dans la plupart des pays européens ayant participé à l'enquête Talis (91 % en Angleterre par exemple ou 73 % au Danemark pour le taux le plus bas). Au collège, les enseignants français sont 71 % à déclarer un impact positif, soit un écart de 10 points avec la moyenne de l'Union européenne en 2018.

Comparaison de la proportion d'enseignant

indiquant un impact positif

des activités de formation continue sur

les pratiques enseignantes

dans le premier degré

(en %)

|

France |

Espagne |

Angleterre |

Pays-Bas |

Suède |

Belgique (Flandre) |

Danemark |

|||||||||

|

Impact positif de l'une (au moins) des activités de formation continue suivies sur la manière d'enseigner |

62 % |

84 % |

91 % |

87 % |

81 % |

84 % |

73 % |

||||||||

Source : commission des finances d'après la DEPP d'après Talis 2018

À l'école comme au collège, les enseignants français sont moins nombreux que leurs collègues européens à déclarer (par ordre décroissant d'écart) que l'activité de formation continue ayant eu l'impact le plus positif sur leur manière d'enseigner se déroulait sur une longue période, se déroulait dans l'établissement, prévoyait des activités de suivi, ou était construite sur des connaissances préalables avec, pour le collège, des écarts avec la moyenne UE allant de - 30 points à - 18 points.

Le rapporteur spécial considère que l'amélioration du dispositif de performance de la formation continue constitue un axe fondamental pour le ministère. S'il est conscient de la difficulté de mesurer l'évaluation de pratiques enseignantes, le rapporteur spécial insiste sur le fait qu'une gestion efficace des ressources humaines d'une part, et des financements publics d'autre part, ne peut faire l'économie d'une réflexion approfondie sur le sujet.

Recommandation n° 5 : renforcer le dispositif d'évaluation de la formation continue en systématisant le déploiement d'indicateurs adaptés et en établissant un suivi postérieur à la formation.