- LISTE DES RECOMMANDATIONS

DE LA MISSION D'INFORMATION

- AVANT-PROPOS

- I. PETIT PRÉCIS HISTORIQUE ET TECHNIQUE DE

L'INTELLIGENCE ARTIFICIELLE

- A. DES AUTOMATES ANTHROPOMORPHES DE

L'ANTIQUITÉ À L'AGENT CONVERSATIONNEL CHATGPT : L'AVENTURE

DE L'INTELLIGENCE ARTIFICIELLE

- B. GLOSSAIRE DE L'INTELLIGENCE ARTIFICIELLE

- C. LA CONCEPTION ET LE FONCTIONNEMENT D'UN

MODÈLE D'INTELLIGENCE ARTIFICIELLE GÉNÉRATIVE

- A. DES AUTOMATES ANTHROPOMORPHES DE

L'ANTIQUITÉ À L'AGENT CONVERSATIONNEL CHATGPT : L'AVENTURE

DE L'INTELLIGENCE ARTIFICIELLE

- I. II. LA CRÉATION ARTISTIQUE FACE À

LA VAGUE DE L'INTELLIGENCE ARTIFICIELLE : NOUVEL HORIZON ARTISTIQUE OU

PARASITISME CRÉATIF ?

- A. COMMENT L'INTELLIGENCE ARTIFICIELLE BOULEVERSE

LE PROCESSUS DE CRÉATION

- 1. Des premières expériences

artistiques recourant à l'intelligence artificielle aux premières

oeuvres intégralement générées par celle-ci

- 2. Une échelle de gradation de la place de

l'intelligence artificielle dans le processus créatif

- 3. Principaux cas d'usage de l'intelligence

artificielle dans les industries culturelles et créatives

- 1. Des premières expériences

artistiques recourant à l'intelligence artificielle aux premières

oeuvres intégralement générées par celle-ci

- B. LA CONCURRENCE D'UNE NOUVELLE FORME DE

CRÉATION QUI POSE UN DÉFI ÉCONOMIQUE, SOCIAL ET

CULTUREL

- A. COMMENT L'INTELLIGENCE ARTIFICIELLE BOULEVERSE

LE PROCESSUS DE CRÉATION

- I. III. UN ENCADREMENT JURIDIQUE EN CONSTRUCTION

AU NIVEAU MONDIAL

- A. LA DIRECTIVE

DU 17 AVRIL 2019 SUR LES DROITS D'AUTEUR :

UN SOCLE DÉSORMAIS DÉPASSÉ

- 1. Les exceptions « text en data mining

« (TDM)

- 2. Une exception

détournée ?

- 3. L'intervention des tribunaux

- a) En Europe : la prudence dans l'utilisation

de l'exception TDM

- (1) Une première décision à

Hambourg...

- (2) ...en attendant la Cour de Justice de l'Union

européenne

- b) Aux États-Unis : quelles limites au

« fair use » ?

- (1) Un « fair use »,

très largement invoqué

- (2) Une première décision dans le

Delaware

- (3) Une forte pression de la nouvelle

administration américaine pour protéger les géants de la

tech

- a) En Europe : la prudence dans l'utilisation

de l'exception TDM

- 1. Les exceptions « text en data mining

« (TDM)

- B. UNE LÉGISLATION EUROPÉENNE QUI

CHERCHE UNE DIRECTION

- 1. La nécessité d'un cadre, la

difficulté d'y parvenir

- 2. Les avancées et les incertitudes du

RIA

- a) La conformité au droit de l'Union

- (1) Un simple rappel des

règles...

- (2) ... qui doit être

complété par un code de bonne pratique

- (3) Des versions successives de moins en moins

protectrices des droits d'auteur

- (4) La forte opposition du secteur culturel

- b) Le résumé des sources

utilisées

- (1) Des termes volontairement ambigus

- (2) Une obligation indissociable de la

conformité

- (3) Une mise en oeuvre qui interroge

- a) La conformité au droit de l'Union

- 1. La nécessité d'un cadre, la

difficulté d'y parvenir

- C. EN AVAL : QUEL STATUT JURIDIQUE POUR LES

oeUVRES GÉNÉRÉES PAR UNE IA ?

- A. LA DIRECTIVE

DU 17 AVRIL 2019 SUR LES DROITS D'AUTEUR :

UN SOCLE DÉSORMAIS DÉPASSÉ

- I. IV. TRANSPARENCE ET RÉMUNÉRATION

DANS L'INTÉRÊT DE TOUS

- A. L'INSOUTENABLE GRATUITÉ DES

DONNÉES

- B. UNE SITUATION PRÉJUDICIABLE À

TOUS

- A. L'ABSENCE PRÉOCCUPANTE D'UN

MARCHÉ DES DONNÉES

- B. HUIT GRANDS PRINCIPES À RESPECTER DANS

LE CADRE DE L'ÉLABORATION CONCERTÉE D'UN MODÈLE DE

RÉMUNÉRATION DES CONTENUS CULTURELS UTILISÉS PAR

L'IA

- 1. Premier principe : le droit à

rémunération des ayants droit est légitime et

incontestable

- 2. Deuxième principe : la transparence

sur les données utilisées doit être garantie

- 3. Troisième principe : la

rémunération doit être fonction des flux de revenus

générés par l'IA

- 4. Quatrième principe : la

création de bases de données harmonisées, aux conditions

d'utilisation clairement définies, est un préalable indispensable

à l'existence d'un marché de la donnée

- 5. Cinquième principe : le

passé doit être soldé

- 6. Sixième principe : un avantage

comparatif doit être donné aux fournisseurs d'IA respectueux du

cadre légal

- 7. Septième principe : la

diversité culturelle et la créativité humaine doivent

continuer à être encouragées

- 8. Huitième principe : les

créations générées par l'IA doivent être

étiquetées

- 1. Premier principe : le droit à

rémunération des ayants droit est légitime et

incontestable

- C. DONNER SA CHANCE AU RIA ET GARANTIR SON

EFFECTIVITÉ

- 1. Une mise en oeuvre entravée

- 2. Une réponse graduée pour parvenir

enfin à une rémunération appropriée des ayants

droit culturels

- a) Premier temps : attendre les

résultats du cycle de concertation entre les développeurs d'IA et

les ayants droit culturels

- b) Deuxième temps : en cas

d'échec de la concertation, inscrire dans la loi une présomption

d'utilisation des données

- c) Troisième temps : en cas

d'échec de la mise en oeuvre d'une présomption d'utilisation,

créer une taxation du chiffre d'affaires des acteurs de l'IA

- a) Premier temps : attendre les

résultats du cycle de concertation entre les développeurs d'IA et

les ayants droit culturels

- 1. Une mise en oeuvre entravée

- A. L'INSOUTENABLE GRATUITÉ DES

DONNÉES

- I. PETIT PRÉCIS HISTORIQUE ET TECHNIQUE DE

L'INTELLIGENCE ARTIFICIELLE

- EXAMEN EN COMMISSION

- LISTE DES PERSONNES ENTENDUES

ET DES CONTRIBUTIONS ÉCRITES

- DÉPLACEMENT

- TABLEAU DE MISE EN oeUVRE ET DE SUIVI

DES RECOMMANDATIONS

LISTE DES RECOMMANDATIONS

DE LA MISSION D'INFORMATION

Assurer le respect des huit principes suivants, présentés sous forme de recommandations, dans la mise en place de relations équilibrées entre les ayants droit culturels et les fournisseurs d'IA :

Recommandation n° 1 : Réaffirmer et garantir le droit à rémunération des ayants droit culturels pour l'utilisation de leurs contenus par les fournisseurs d'IA.

Recommandation n° 2 : Garantir la transparence complète des données utilisées par les fournisseurs d'IA.

Recommandation n° 3 : Définir des modalités de rémunération qui soient fonction des flux de revenus générés par les fournisseurs et déployeurs d'IA.

Recommandation n° 4 : Inciter le secteur culturel et celui de la presse à constituer des bases de données larges et de qualité, facilement exploitables par les fournisseurs, assorties de conditions d'utilisation précisément définies.

Recommandation n° 5 : Parvenir à un règlement financier pour les usages passés des contenus culturels, afin de compenser les ayants droit culturels et sécuriser juridiquement les fournisseurs d'IA.

Recommandation n° 6 : Créer les conditions d'un réel avantage comparatif pour les fournisseurs d'IA vertueux qui sauront nouer les meilleurs accords avec les ayants droit culturels.

Recommandation n° 7 : Tirer profit des revenus générés par le marché de l'IA pour promouvoir la diversité de la création culturelle et le pluralisme de la presse.

Recommandation n° 8 : Travailler à la mise en place d'un système technique permettant d'identifier les contenus intégralement générés par l'IA.

Appliquer une méthode sous la forme d'une réponse graduée en trois temps :

Recommandation n° 9 : Garantir l'effectivité du droit d'auteur en suivant une réponse graduée :

- attente des conclusions, à l'automne prochain, de la concertation lancée par le ministère de la culture et le ministère de l'économie entre les fournisseurs d'IA et les ayants droit culturels ;

- en cas d'échec de cette concertation à trouver des solutions adaptées, dépôt d'une proposition de loi d'initiative sénatoriale visant à mettre en oeuvre une présomption d'utilisation des contenus culturels par les fournisseurs d'IA ;

- en cas de nouvel échec, mise en place d'une taxation du chiffre d'affaires réalisé en France par les fournisseurs et déployeurs d'IA, afin de compenser le secteur culturel.

AVANT-PROPOS

La fascination de l'homme pour la création d'entités autonomes, dotées de caractéristiques humaines, irrigue toute l'histoire occidentale, des mythes de l'Antiquité à la cybernétique des années 1950, en passant par l'art de la Renaissance, le rationalisme philosophique du XVIIe siècle et la littérature de science-fiction du XIXe siècle.

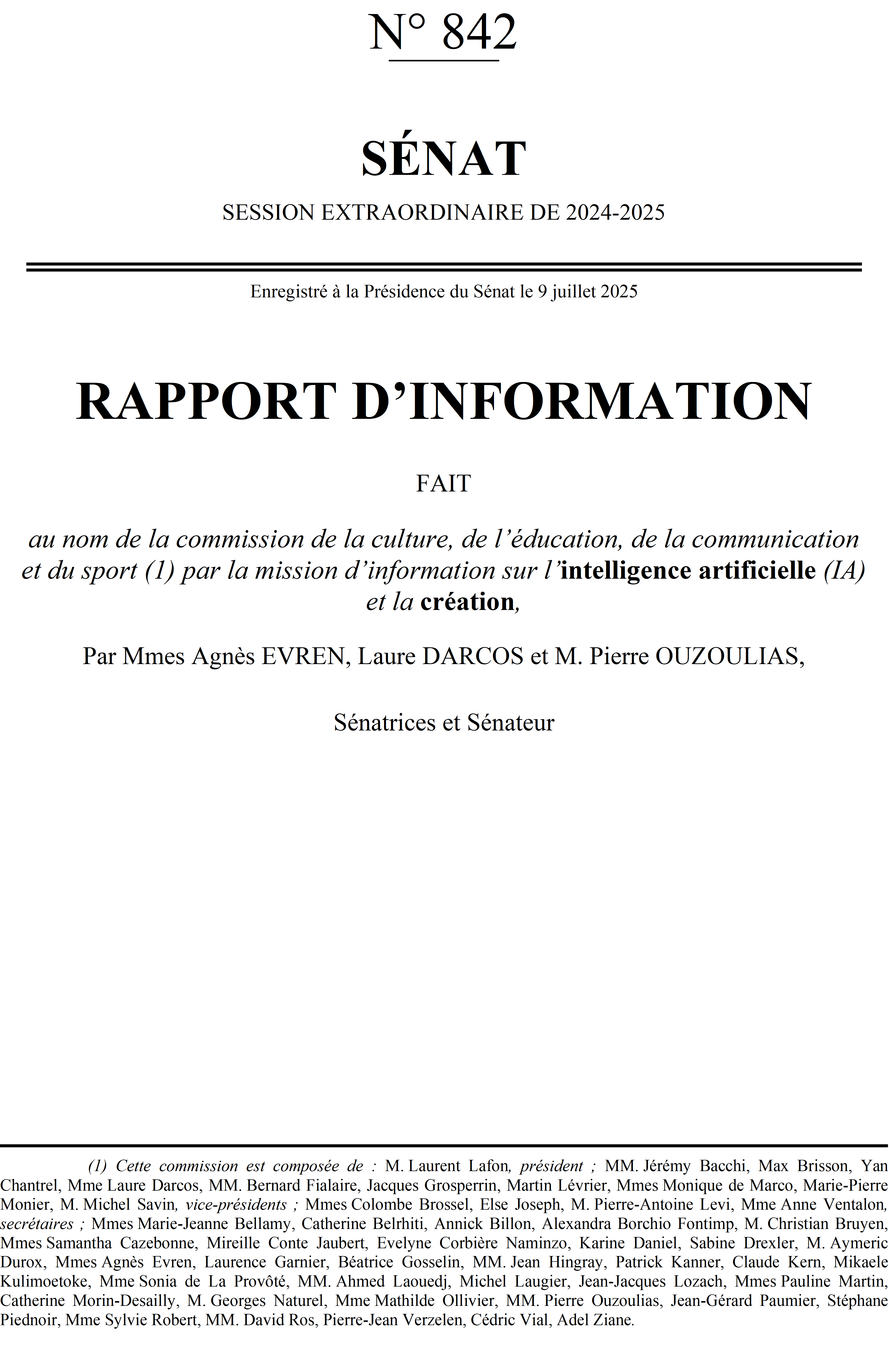

Si l'espoir de modéliser l'intelligence humaine se concrétise dans les années 1950 grâce aux progrès de l'informatique, l'optimisme des débuts de l'intelligence artificielle (IA) - définie à la fois comme un domaine de recherche scientifique et une technologie - s'est rapidement heurté aux capacités restreintes des premiers ordinateurs. S'en suit, au cours des décennies suivantes, un parcours accidenté, fait de périodes de pics et de creux.

Le développement, dans les années 2010, des techniques d'apprentissage profond, puis l'apparition, au début des années 2020, des premières IA dites « génératives » marquent un changement de paradigme : pour la première fois, l'IA sort des sphères scientifique et technologique pour investir l'ensemble des pans de l'économie et de la société.

Moins de trois ans après le lancement, le 30 novembre 2022, par la société OpenAI de son agent conversationnel ChatGPT, l'IA est passée de fantasme scientifique à réalité technologique pour des centaines de millions d'utilisateurs chaque jour sur toute la planète. En 1993, l'écrivain et mathématicien américain Vernor Vinge prédisait, à l'horizon de trente ans, la « Singularité technologique », soit le moment où l'intelligence de l'homme serait dépassée par celle de la machine. À quelques mois près, cette prophétie correspond à la mise sur le marché de ChatGPT.

En quelques années, l'IA a réussi à pénétrer l'ensemble des strates de notre société : l'organisation sociale, l'économie, la politique, mais aussi notre rapport aux autres. Elle occupe désormais une place centrale dans le monde professionnel, ouvrant la voie à des processus de réorganisation des entreprises et des administrations porteurs de promesses d'efficience et de croissance. Certains secteurs, comme la médecine ou la logistique, font d'ores et déjà un usage intensif de modèles d'IA spécialisés. L'IA s'impose également dans l'espace privé, avec l'utilisation en pleine expansion des grands modèles de langage (LLM1(*)) tant pour structurer des informations que pour répondre à des demandes de leurs utilisateurs.

Cet essor fulgurant a pris de court nos modes de pensée et de régulation traditionnels. Le monde que l'IA promeut ne s'insère en effet que difficilement dans nos systèmes économiques, juridiques et démocratiques.

Les concepteurs d'IA ont jusqu'à présent suivi un chemin déjà balisé par la précédente révolution numérique et largement inspiré de la doctrine libertarienne : agir vite de manière agressive, créer une situation de fait pour s'imposer, et renvoyer les conséquences à plus tard. La conception et le fonctionnement des modèles d'IA reposent ainsi sur l'utilisation de quantités massives de contenus culturels, collectés sans que leurs détenteurs légitimes n'aient à aucun moment pu autoriser ou non leur exploitation, encore moins percevoir une rémunération appropriée. Ce comportement peut être résumé par une formule de Grace Hopper, informaticienne américaine conceptrice des premiers compilateurs dans les années 1950 : « Il est plus facile de demander pardon que de demander la permission2(*) ».

Si le secteur culturel est loin d'être le seul à être inquiété par la vague de l'IA, il est peut-être le plus emblématique. En effet, alors que les précédentes révolutions technologiques avaient largement pour conséquence de décharger l'homme de tâches pénibles ou d'exécution, l'IA est désormais en capacité d'investir des domaines que l'on croyait jusqu'à présent réservés aux êtres humains. Si une telle substitution est, dans certains domaines, un facteur précieux de connaissance et de progrès, elle peut, s'agissant du secteur culturel, constituer une menace quasi existentielle dans la mesure où les productions générées par la machine entrent en concurrence directe avec les oeuvres de l'esprit. Cette évolution de nature anthropologique interroge profondément notre conception de l'humanité et réactive les peurs ancestrales sur le remplacement de l'Homme par la machine.

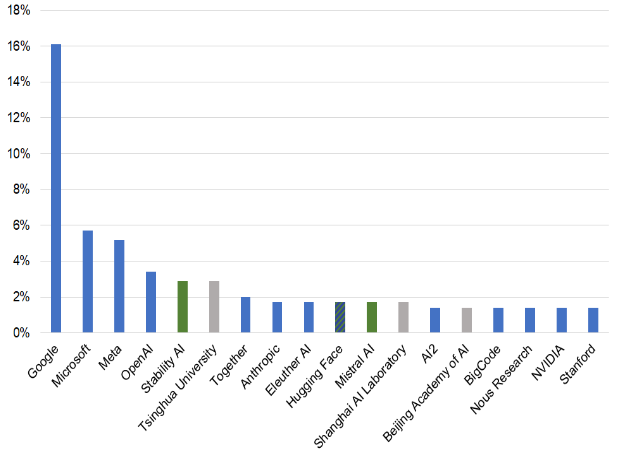

Les questions posées par l'IA sont d'autant plus complexes que ses conséquences ne se cantonnent pas aux seules sphères économique et sociale. L'IA est devenue un enjeu géopolitique de souveraineté, à tel point que les négociations douanières actuellement en cours entre les États-Unis et la Chine traitent pour partie autour de ce sujet : accès aux terres rares, aux puces, aux meilleurs talents...

Dans cette bataille pour la souveraineté numérique en matière d'IA, l'Europe est une nouvelle fois ramenée à ses faiblesses structurelles, déjà lourdement creusées par la révolution numérique des années 2000 au cours de laquelle notre continent a été plus spectateur qu'acteur. La maîtrise de notre destin en tant que continent souverain est directement liée à notre capacité à rattraper notre retard technologique en matière d'IA. Or cette prise de conscience s'est accompagnée d'un mouvement presque de panique en faveur d'une absence de régulation, ou d'une régulation très limitée, présumée favorable au développement des acteurs de l'IA. Sur cette question, la France a souvent tenu un rôle plus ambigu que sa défense traditionnelle et inconditionnelle du droit d'auteur n'aurait pu le laisser présager.

C'est dans ce contexte disruptif que la commission de la culture du Sénat a souhaité sortir du débat manichéen qui oppose souvent, dans l'espace public, les défenseurs de la création aux thuriféraires de la technologie. Elle a donc décidé, au début de l'année 2025, de mettre en place une mission d'information pour analyser les liens entre l'IA et la création artistique.

Confiée aux sénatrices Laure Darcos et Agnès Evren et au sénateur Pierre Ouzoulias, cette mission d'information a organisé une quarantaine d'auditions et débattu avec une centaine d'interlocuteurs, parmi lesquels de nombreux représentants des ayants droit culturels, toutes filières confondues, des acteurs du secteur de la tech, ainsi que des experts juridiques et économiques. Compte tenu de la dimension fortement européenne du dossier, elle a aussi tenu à se déplacer à Bruxelles pour échanger avec les principales parties prenantes.

À l'issue de son travail, la mission s'est forgé la conviction que l'opposition entre IA et création artistique était non seulement stérile, mais également mortifère pour les deux secteurs. La France et l'Europe ont tout à gagner, non pas à s'inscrire dans les pas d'autres puissances devenues peu amicales, mais à profiter de leurs atouts, au premier rang desquels la qualité et la diversité de leurs contenus culturels, pour ouvrir une réelle troisième voie de l'IA, respectueuse des droits et inspiratrice pour la création.

I. PETIT PRÉCIS HISTORIQUE ET TECHNIQUE DE L'INTELLIGENCE ARTIFICIELLE

A. DES AUTOMATES ANTHROPOMORPHES DE L'ANTIQUITÉ À L'AGENT CONVERSATIONNEL CHATGPT : L'AVENTURE DE L'INTELLIGENCE ARTIFICIELLE

1. Aux origines imaginaires et rationnelles de l'intelligence artificielle

Si l'IA en tant que discipline scientifique et technologie est née au milieu du XXe siècle, elle puise ses racines à la fois dans la mythologie antique, l'histoire des sciences et la littérature. L'idée de construire une intelligence, qui n'est pas d'origine humaine, fascine depuis des milliers d'années.

Les mythes antiques, grecs particulièrement, sont riches de créatures imaginaires douées d'attributs humains, voire de raison. Le personnage de Talos, dont l'un des mythes raconte qu'il a été créé à la demande de Zeus par Héphaïstos, dieu de la forge, était un immense automate de bronze ayant pour mission de protéger Europe - la mère du roi de Crète Minos - des envahisseurs, pirates et autres ennemis. Considéré comme l'une des premières manifestations de l'idée de robot de l'Histoire, Talos pouvait faire chauffer son corps de bronze dans le feu pour ensuite étreindre ses adversaires jusqu'à ce qu'ils périssent brûlés. Dans l'Iliade d'Homère, de nombreux objets ou créatures agissent par eux-mêmes : les navires des Phéaciens se pilotent de manière autonome, des trépieds se mettent en mouvement pour servir le vin aux dieux de l'Olympe, des servantes taillées en or par Héphaïstos sont dotées d'une conscience et anticipent les besoins de leur maître. Ainsi que le montrent les travaux d'Adrienne Mayor3(*), chercheuse américaine en lettres classiques et en histoire des sciences, les mythes antiques ont ainsi posé, de manière visionnaire, les interrogations éthiques qui émergent, des siècles plus tard, avec l'accélération du progrès technique et qui trouvent une nouvelle actualité avec l'essor de l'IA : la puissance de la machine, la quête d'immortalité, le risque d'hubris...

Au-delà de ce vivier mythologique, la future IA se nourrit du développement, au fil des siècles, des sciences, en tout premier lieu des mathématiques et, au sein de celles-ci, de l'algorithmique. Le mot algorithme vient de la latinisation du nom d'un mathématicien perse du IXe siècle, Al-Khwârizmî, considéré comme le père de l'algèbre. L'origine des algorithmes est toutefois bien plus ancienne puisque des procédés algorithmiques ont été retrouvés sur des tablettes écrites en cunéiforme par les Babyloniens au IIIe millénaire avant J.C. et que des formules algorithmiques ont été développées entre 300 et 200 avant notre ère par les mathématiciens grecs Euclide, Archimède et Ératosthène.

Qu'est-ce qu'un algorithme ? Il s'agit d'une suite finie et non ambiguë d'opérations ou d'instructions qui, à partir de données fournies en entrée (entrants ou inputs), permet d'obtenir un résultat sortant (ou output).

De manière imagée, un algorithme s'apparente à une recette de cuisine où les ingrédients, en suivant des étapes successives, permettent d'obtenir un plat.

Au XVIIe siècle, le philosophe et mathématicien allemand Gottfried Leibniz apporte une contribution notable au développement de la pensée algorithmique, qui préfigure les fondements de l'informatique moderne. Convaincu que mathématiques et pensée métaphysique ne font qu'un, il théorise le calculus ratiocinator, algorithme ou machine calculatoire permettant de démêler le vrai du faux dans toute discussion dont les termes seraient exprimés dans une langue philosophique universelle. Leibniz est aussi le concepteur d'un prototype de machine à calculer, capable d'effectuer les quatre opérations de l'arithmétique.

Au cours du XIXe siècle, de nouvelles machines à calculer, ancêtres mécaniques des ordinateurs, sont mises au point par des scientifiques britanniques, notamment celle du mathématicien Charles Babbage sur laquelle sa compatriote Ada Lovelace développe le premier programme informatique de l'Histoire.

Parallèlement à ces progrès scientifiques, la littérature du XIXe siècle, sous l'effet des bouleversements technologiques provoqués par la révolution industrielle, se passionne pour les formes d'hybridation entre l'homme et la machine et interroge la capacité de cette dernière à développer une conscience, contribuant ainsi à dessiner l'avenir de l'IA. Des ouvrages de science-fiction comme Frankenstein de Mary Shelley ou les romans de Jules Verne forgent l'imaginaire collectif et ouvrent la voie aux oeuvres d'anticipation du siècle suivant, particulièrement dans le Septième Art.

2. Naissance et développement de l'intelligence artificielle : une histoire non linéaire

a) Les années 1950 : l'époque des pionniers de l'intelligence artificielle

Ce n'est que dans la première moitié du XXe siècle que les avancées réalisées dans les domaines de la logique formelle et de l'informatique permettent de poser les premiers jalons de l'IA telle que la notion émergera dans les années 1950.

Considéré comme l'un des pères fondateurs de l'informatique, le mathématicien britannique Alan Turing publie en 1936 un article, On Computable Numbers (« De la calculabilité des nombres »), dans lequel il imagine une machine dotée d'une bande de papier équipée d'une tête d'écriture et de lecture, pouvant théoriquement réaliser n'importe quel type de calcul, ce qui la rendait, d'après son concepteur, universelle. Cette « machine de Turing », comme elle sera nommée plus tard, préfigure le fonctionnement théorique des ordinateurs modernes.

Après la Seconde Guerre mondiale, Turing envisage progressivement la possibilité de construire une machine pouvant développer une forme d'intelligence grâce à une méthode d'entraînement. En 1950, il fait publier dans la revue de philosophie Mind son article le plus célèbre, souvent considéré comme l'acte fondateur de l'idée d'IA, Computing Machinery and Intelligence (« Les ordinateurs et l'intelligence »). Il y propose un test, qu'il nomme imitation game (jeu de l'imitation), désormais connu sous le nom de « test de Turing », dont le principe consiste à mettre en confrontation verbale un humain avec une machine imitant la conversation humaine et un autre humain. Dans le cas où l'homme qui engage la conversation n'est pas capable de dire lequel de ses interlocuteurs est une machine, on peut considérer que cette dernière a passé le test avec succès et qu'elle peut donc être qualifiée d'intelligente. Turing fait alors le pari que les machines vont réussir son test à moyen terme (« d'ici à cinquante ans, il n'y aura plus moyen de distinguer les réponses données par un homme ou un ordinateur, et ce sur n'importe quel sujet »).

Aujourd'hui encore, le test de Turing est régulièrement utilisé pour évaluer les IA contemporaines. En février 2024, trois chercheurs américains de l'université Stanford ont ainsi conclu que ChatGPT, l'agent conversationnel d'OpenAI, « présente des traits de comportement et de personnalité qu'il est statistiquement impossible de distinguer d'un humain ».

C'est à l'été 1956, lors d'une conférence organisée au Collège de Dartmouth dans le New Hampshire, que l'expression « intelligence artificielle » est officiellement utilisée pour définir un nouveau domaine de recherche. Les instigateurs de cette conférence, parmi lesquels figurent des personnalités scientifiques éminentes telles que John McCarthy et Marvin Minsky, sont animés par une conviction forte : celle de la faisabilité de construire des machines capables de simuler les capacités cognitives humaines. En créant les conditions d'un dialogue interdisciplinaire, où les connaissances issues de l'informatique, de la psychologie, de la philosophie, des neurosciences et des mathématiques pourraient s'enrichir mutuellement, ils aspirent à jeter les bases d'un domaine de recherche qui, jusqu'alors, n'a pas de contours clairement définis.

Véritable acte de naissance de l'IA, la Conférence de Dartmouth pose ainsi le présupposé selon lequel « chaque aspect de l'apprentissage ou toute autre caractéristique de l'intelligence artificielle peut en principe être décrit avec une telle précision qu'une machine peut être fabriquée pour le simuler ». L'IA devient donc la science et l'ingénierie de fabrication de machines pouvant simuler tel ou tel aspect de l'intelligence humaine. Il est intéressant de noter que, dans cette acception, l'IA est à la fois une discipline scientifique et un savoir-faire pratique.

En 1959, le terme machine learning (apprentissage automatique) apparaît pour la première fois, utilisé par Arthur Samuel pour son programme capable d'apprendre à jouer aux dames au fil des parties. Cette technique, qui permet aux algorithmes d'apprendre ou d'améliorer leurs performances en fonction des données qu'ils reçoivent, devient une sous-branche à part entière de l'IA.

Définitions de l'intelligence artificielle

Il n'existe pas de définition unique de l'IA, mais le terme désigne généralement la capacité de machines à effectuer des tâches associées à l' intelligence humaine, comme l' apprentissage, le raisonnement, la résolution de problème, la perception ou la prise de décision. L'IA désigne également le domaine de recherche qui s'intéresse au développement de telles machines et la technologie qui permet de les fabriquer.

Définition de John MacCarthy : l'IA est « la science et l'ingénierie de la fabrication de machines intelligentes ».

Définition du Parlement européen : l'IA représente tout outil utilisé par une machine afin de « reproduire des comportements liés aux humains, tels que le raisonnement, la planification et la créativité ».

Définition du Larousse : l'IA est « un ensemble de théories et de techniques mises en oeuvre en vue de réaliser des machines capables de simuler l'intelligence humaine ».

b) Les « printemps » et les « hivers » de l'intelligence artificielle

L'engouement suscité par la Conférence de Dartmouth ouvre une période d'âge d'or pour l'IA, qui court jusqu'au début des années 1970. Ce « premier printemps » se caractérise par un fort optimisme et des objectifs ambitieux, l'IA étant perçue comme un domaine de recherche très prometteur.

Portés par un soutien financier important tant de la part des pouvoirs publics (par exemple, l'agence américaine pour les projets de recherche avancée de défense) que des entreprises privées (par exemple, IBM), les chercheurs explorent l'IA dite « symbolique ». Celle-ci repose sur l'idée que la logique mathématique peut représenter, au moyen de symboles, des connaissances et modéliser des raisonnements. C'est au cours de cette première période qu'une première concrétisation des réseaux de neurones artificiels voit le jour sous la forme du Perceptron de Frank Rosenblatt et que le premier agent conversationnel (chatbot), baptisé Eliza, est mis au point par Joseph Weizenbaum.

À l'enthousiasme des deux premières décennies succède une phase de stagnation, qui s'étend de 1970 à 1980, marquée par une prise de conscience croissante des défis inhérents à la réalisation des ambitions initiales de l'IA et une baisse des financements publics et privés. Les recherches se concentrent alors sur la programmation logique et la représentation des connaissances. Cette décennie moins dynamique, connue sous le nom de « premier hiver de l'IA » en référence au contexte de la guerre froide, témoigne de la cyclicité de son histoire, qui est faite de pics et de creux d'investissements et de confiance.

Au cours des années 1980, l'IA bénéficie d'un regain d'intérêt sous l'effet de nouveaux investissements publics de la part des États-Unis, de l'Europe et du Japon. Cette période voit le développement des systèmes experts, c'est-à-dire des programmes conçus pour imiter l'expertise humaine dans des domaines spécifiques et capables de résoudre des problèmes complexes. Même si cette nouvelle approche montre le potentiel pratique de l'IA, ses succès restent très relatifs car cantonnés à des domaines trop restreints et spécialisés.

Ce bilan en demi-teinte annonce un « second hiver de l'IA » dans les années 1990, celle-ci n'étant de nouveau plus une priorité des pouvoirs publics. Un événement majeur marque tout de même la décennie : en 1997, le système d'expert Deep Blue d'IBM bat le champion du monde d'échecs Garry Kasparov. Pour la première fois, une intelligence artificielle est capable de l'emporter sur une intelligence humaine.

Il faut attendre les années 2010 pour que l'IA connaisse un nouvel âge d'or ou « second printemps », cette fois-ci spectaculaire. Le saut qualitatif qu'elle accomplit durant cette décennie est rendu possible par un contexte très porteur, qui se dessine à partir des années 2000. Avec l'apparition d'Internet puis le développement exponentiel de ses usages, le volume de données disponibles en ligne explose ; cette massification des données numériques (big data) constitue un formidable tremplin pour l'IA qui a besoin de « carburant » pour progresser. Parallèlement, les avancées technologiques en informatique permettent d'augmenter considérablement les capacités de calcul des ordinateurs. La combinaison entre la masse de données accessibles et la puissance des machines permet de faire décoller l'apprentissage profond (deep learning), grâce notamment aux travaux des scientifiques américains Yoshua Bengio, Geoffrey Hinton et du chercheur français Yann Le Cun. Cette technique d'apprentissage basée sur des réseaux de neurones artificiels (voir infra), sous-discipline du machine learning, permet de réaliser des avancées très significatives en matière de reconnaissance vocale, de traitement du langage naturel (NLP), de reconnaissance visuelle et d'apprentissage par renforcement. En 2015, le programme AlphaGo, mis au point par la société Google DeepMind et qui a appris à jouer au jeu de go par le biais du deep learning, bat le champion européen Fan Hui par cinq parties à zéro.

En 2017, l'IA franchit une nouvelle étape charnière avec la montée en puissance de l'IA dite « générative », elle-même issue du deep learning et rendue possible par l'invention cette année-là de la technologie Transformer (cf. infra). C'est de cette technologie que naissent les grands modèles de langage ou LLM (Large Language Model), dont l'exemple le plus célèbre est ChatGPT, lancé en 2022 par l'entreprise américaine OpenAI.

B. GLOSSAIRE DE L'INTELLIGENCE ARTIFICIELLE

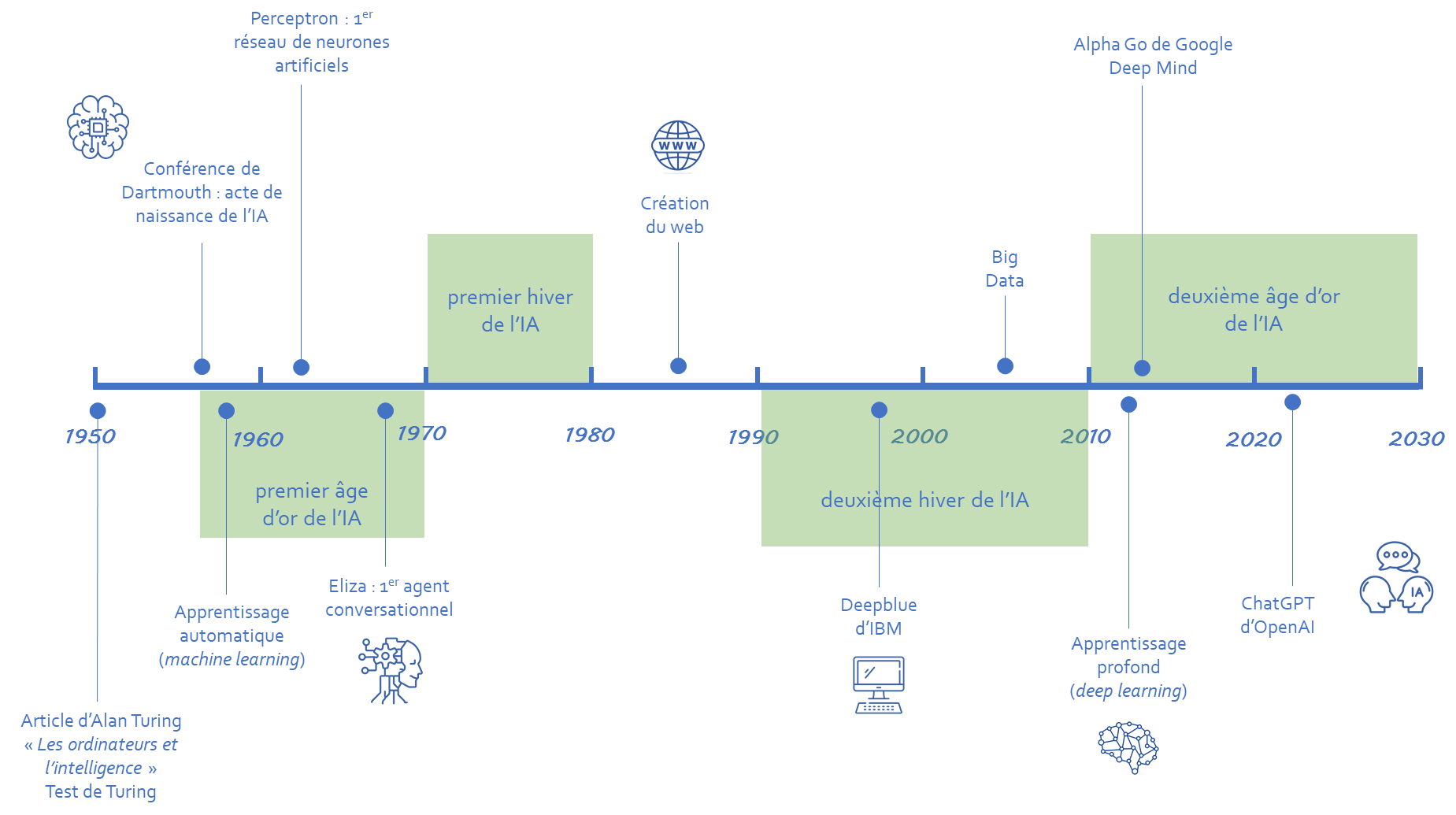

Le vocabulaire autour de l'IA est composé d'une multitude de termes et d'expressions, souvent techniques et pas toujours utilisés à bon escient. L'objectif ici est de faciliter la compréhension des différentes notions relatives à l'IA, en identifiant ce qui les lie et les différencie.

1. L'intelligence artificielle et ses sous-domaines

Au fur et à mesure de ses avancées scientifiques et technologiques, l'IA, qui est en quelque sorte la discipline-mère, a donné naissance à des sous-domaines, qui peuvent être représentés en sous-ensembles concentriques.

a) L'apprentissage automatique (machine learning)

Le machine learning est un champ d'études au sein de l'IA qui vise à donner aux machines la capacité d'apprendre à partir de données, via des modèles mathématiques utilisant des algorithmes probabilistes.

Plus précisément, il s'agit du procédé par lequel une machine, au moyen de techniques algorithmiques et sans l'intervention additionnelle de son programmateur, traite et analyse des données, apprend de ces données, estime la probabilité de résultats et prend des décisions fondées sur ce qu'elle a appris. Plus la machine réalise cet apprentissage, plus ses performances s'améliorent. En outre, plus le volume de données auquel elle a accès est important, plus ses résultats progressent.

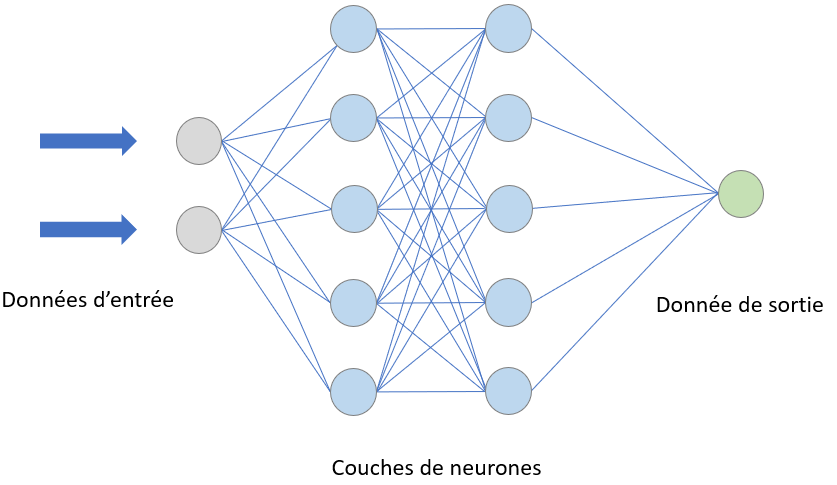

Schéma d'un modèle d'apprentissage automatique (machine learning)

Le machine learning se décline en quatre principaux modèles d'apprentissage, qui emploient chacun des techniques algorithmiques différentes :

· l'apprentissage supervisé : dans ce premier modèle, la machine s'entraîne, au moyen d'un algorithme, à une tâche déterminée (ou clef de réponse) en utilisant un jeu de données assorties chacune d'une annotation (ou données étiquetées) indiquant le résultat attendu ;

· l'apprentissage non supervisé : dans ce deuxième modèle, la machine s'entraîne, au moyen d'un algorithme, sans tâche déterminée (sans clef de réponse) en utilisant un jeu de données brutes (sans étiquetage). En détectant des récurrences, des similarités, des corrélations entre certaines de ces données, elle obtient un résultat ;

· l'apprentissage semi-supervisé : dans ce troisième modèle, intermédiaire entre les deux premiers, la machine s'entraîne, au moyen d'un algorithme, à partir de petits volumes de données étiquetées pour analyser de gros volumes de données non étiquetées ;

· l'apprentissage par renforcement : dans ce quatrième modèle, la machine, qui connaît la clef de réponse, apprend en expérimentant différentes actions et en attribuant une valeur positive ou négative à chacune d'entre elles en fonction du résultat obtenu. Elle cherche, au fil des expériences, à maximiser la somme des récompenses, donc à parvenir à une solution décisionnelle optimale.

Dans chacun de ces modèles, une ou plusieurs techniques algorithmiques peuvent être appliquées ; tout dépend des jeux de données qui seront utilisés et de l'objectif visé au niveau des résultats. Par nature, les algorithmes du machine learning sont conçus pour classifier des éléments, repérer des motifs récurrents (patterns), prévoir des résultats (analyse probabiliste) et prendre des décisions éclairées. Les algorithmes peuvent être mis en oeuvre individuellement ou en groupe dans le but d'atteindre la plus grande précision possible lorsque les données utilisées sont complexes et imprévisibles.

b) L'apprentissage profond (deep learning)

Le deep learning est un sous-ensemble du machine learning qui recourt à l'apprentissage supervisé, mais avec une architecture bien spécifique, celle d'un réseau de neurones artificiels agencé sous la même forme que les neurones d'un cerveau biologique. Les neurones artificiels composant un réseau s'appellent des « noeuds », qui sont connectés et regroupés en « couches ». Lorsqu'un noeud reçoit un signal digital, il le transmet alors à d'autres neurones appropriés, qui fonctionnent en parallèle.

Réseau de neurones artificiels

Cet apprentissage, qui fait appel à d'énormes volumes de données, complexes et disparates, est qualifié de « profond » (deep) car il fonctionne par « couches » : les résultats de la première « couche » de neurones vont servir d'entrée au calcul des autres, et ainsi de suite. Plus on augmente le nombre de couches, plus les réseaux de neurones apprennent des choses compliquées, abstraites, se rapprochant de plus en plus du fonctionnement d'un cerveau humain.

Par exemple, un modèle d'apprentissage profond qui traite des images de la nature et recherche des roses jaunes va d'abord reconnaître une plante dans la première couche. Au fur et à mesure qu'il va avancer dans les couches, il va ensuite identifier une fleur, puis une rose, et enfin une rose jaune.

Il existe différents types de réseaux neuronaux artificiels, parmi lesquels :

· les réseaux neuronaux convolutifs (CNN) : ils sont basés sur la structure du cortex visuel et utilisent des couches convolutives pour extraire les caractéristiques d'une image d'entrée. Ces CNN sont principalement utilisés pour des tâches de reconnaissance d'images ;

· les réseaux neuronaux récurrents (RNN) : ils permettent de « se souvenir » des informations passées et de les utiliser pour prendre des décisions en temps réel. Ces RNN sont spécialement utilisés pour l'analyse de séquences de données ;

· les réseaux antagonistes génératifs (GAN) : introduite pour la première fois en 2014, cette architecture repose sur deux réseaux neuronaux qui s'affrontent. L'un des réseaux, le générateur, crée des données originales, tandis que l'autre, le discriminateur, évalue si les données sont générées par l'IA ou réelles. Grâce à une méthode d'apprentissage profond et à une boucle de rétroaction qui pénalise le discriminateur en cas d'erreur, les GAN apprennent à générer un contenu de plus en plus réaliste ;

· les réseaux neuronaux Transformer (TNN) : cette architecture de réseau neuronal, introduite par l'article « Attention is All You Need » publié par des chercheurs de Google en 2017, est très novatrice par rapport aux architectures traditionnelles de traitement de séquences de données comme les CNN ou les RNN. Transformer repose sur un mécanisme d'auto-attention : au lieu de traiter les données dans l'ordre, il examine simultanément différentes parties de la séquence et détermine lesquelles sont les plus importantes. Ce fonctionnement non séquentiel, qui apporte flexibilité, adaptation et rapidité, permet de réaliser une multitude de tâches (génération d'images, traduction automatique, compréhension des séquences, détection d'anomalies...).

c) L'intelligence artificielle générative et sa capacité créatrice

L'IA dite « générative » (qualificatif dérivé du supin latin generatum, qui signifie « pour créer ») est un type d'IA capable de générer des contenus nouveaux couvrant un spectre très large (texte, code informatique, images, musique, audio, vidéos, etc.), à partir des données grâce auxquelles elle a été formée. Ces contenus nouveaux ressemblent à ce que l'on peut trouver dans ces données dites « d'entraînement », mais ils ne sont pas semblables, d'où leur caractère original.

C'est cette créativité - entendue au sens de la capacité à générer une production originale - qui distingue l'IA générative de l'IA prédictive, laquelle prévoit et anticipe mais ne crée pas.

L'IA générative repose principalement sur des techniques d'apprentissage profond. Autrement dit, elle est une application du deep learning qui se concentre sur la génération de contenus nouveaux.

L'IA générative, tout comme l'apprentissage automatique dont elle est issue, est par nature probabiliste : à partir des données d'entraînement, elle va estimer la probabilité de différents résultats et générer des contenus sortants qui découlent des probabilités apprises. Cela explique pourquoi elle est susceptible de produire des résultats erronés ou de pures inventions, appelées hallucinations, qui sont à l'origine de sa dégénérescence (voir infra).

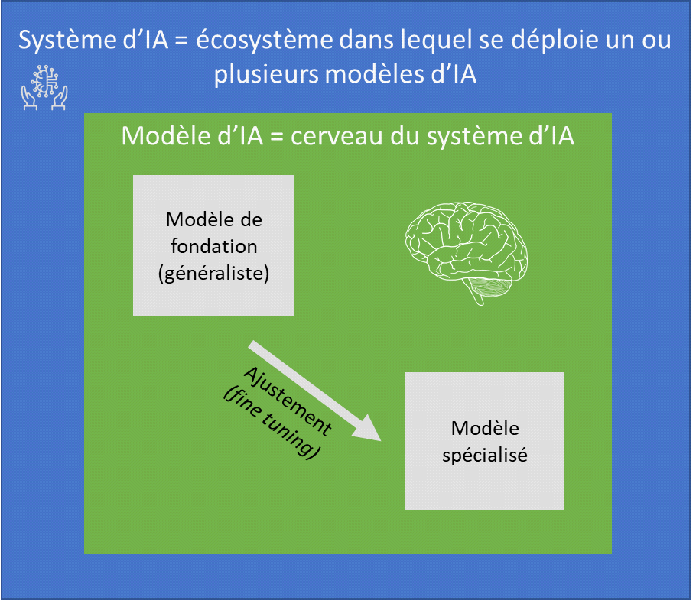

2. Modèle d'intelligence artificielle vs système d'intelligence artificielle

Un modèle d'IA est un programme informatique qui applique un ou plusieurs algorithmes à un jeu de données pour reconnaître des motifs, réaliser des tâches spécifiques ou prendre des décisions. Un modèle d'IA est intégré à un système d'IA, dont il est une composante essentielle, son cerveau en quelque sorte. Il est construit et optimisé à travers un processus d'entraînement, où il apprend à partir de données entrantes pour améliorer sa précision et son efficacité.

Un système d'IA est une application plus large qui englobe non seulement un ou plusieurs modèles d'IA, mais aussi tout l'écosystème nécessaire à leur fonctionnement. Il inclut des processus de collecte de données, des interfaces utilisateurs, une infrastructure technique (serveurs, bases de données) pour déployer efficacement l'IA dans des environnements pratiques. En d'autres termes, un système IA est une solution complète qui met en oeuvre des modèles IA dans un cadre opérationnel.

Au sein des modèles d'IA, on distingue les modèles de fondation, à usage général, et les modèles spécialisés :

· un modèle de fondation désigne un modèle d'IA de très grande taille, entraîné sur d'énormes quantités de données brutes (non étiquetées), dont les capacités sont générales, et qui peut être adapté à une grande diversité de tâches distinctes (compréhension du langage, génération de textes et d'images, conversation en langage naturel...), notamment après un ajustement (fine-tuning) supplémentaire. Cette flexibilité, combinée à la capacité à apprendre à partir de vastes ensembles de données, le rend particulièrement puissant. Un modèle de fondation peut être adapté à des tâches non génératives, comme la classification, l'analyse, la prédiction, ou à des tâches génératives ; il est donc plus large dans sa conception et son application potentielle qu'un modèle d'IA générative ;

· à l'inverse, un modèle qui est d'emblée spécialisé, sans passer par l'ajustement d'un modèle de fondation, n'est dédié qu'à une seule fonction ou appliqué qu'à un seul domaine. Un modèle spécialisé n'est toutefois pas forcément de petite taille.

C. LA CONCEPTION ET LE FONCTIONNEMENT D'UN MODÈLE D'INTELLIGENCE ARTIFICIELLE GÉNÉRATIVE

1. Une diversité de modèles et d'acteurs

Un modèle d'IA générative est un modèle d'IA qui a la capacité de générer un contenu nouveau et original (un texte, une image, une vidéo...), en se basant sur ce qu'il a appris. Un modèle d'IA générative n'est pas forcément un modèle de fondation (voir supra).

Il existe plusieurs types de modèles d'IA générative :

· un modèle de langage est un modèle d'IA générative capable de générer un contenu textuel. On parle de grand modèle de langage (Large Language Model ou LLM) lorsque le modèle possède un grand nombre de paramètres. Les LLM sont les modèles d'IA générative les plus courants aujourd'hui ; ChatGPT est le plus connu d'entre eux ;

· un modèle de diffusion est un modèle d'IA générative capable de générer un contenu visuel. C'est le cas, par exemple, de DALL-E et de Midjourney ;

· un modèle multi-modal est un modèle d'IA générative capable de générer un contenu sous différents formats (texte, image, son, vidéo...) ; GPT-4 en est.

Différents acteurs interviennent dans la chaîne de développement et d'utilisation d'un modèle d'IA, parmi lesquels :

· le « fournisseur » : selon la définition qu'en donne le règlement européen établissant des règles harmonisées concernant l'intelligence artificielle (RIA) du 13 juin 2024, il s'agit d' « une personne physique ou morale, une autorité publique, une agence ou un autre organisme qui développe ou fait développer un système d'IA ou un modèle d'IA à usage général et le met sur le marché ou met le système d'IA en service sous son propre nom ou sa propre marque, que ce soit à titre onéreux ou gratuit ».

Exemples de fournisseurs d'IA : OpenAI, Google, Amazon, Microsoft, IBM, Mistral AI...

· le « développeur » : il s'agit du professionnel capable de concevoir un modèle d'IA. Ses missions incluent l'analyse des besoins, la collecte et la préparation des données, le choix de la technique d'apprentissage, l'entraînement du modèle, son évaluation, son intégration dans une application ou un système, sa surveillance...

· le « déployeur » : selon la définition du RIA, il s'agit de « toute personne physique ou morale, autorité publique, agence ou autre organisme qui utilise un système d'IA sous sa responsabilité, sauf si l'utilisation est à des fins personnelles non professionnelles ».

exemples de déployeurs d'IA : une banque qui a recours à une IA pour analyser les dossiers de prêt, un cabinet RH qui déploie une IA pour trier automatiquement des CV, une entreprise de cybersécurité qui utilise l'IA pour détecter des fraudes, un organisme public qui met en place un chatbot (assistant virtuel de conversation) automatisé pour répondre aux citoyens...

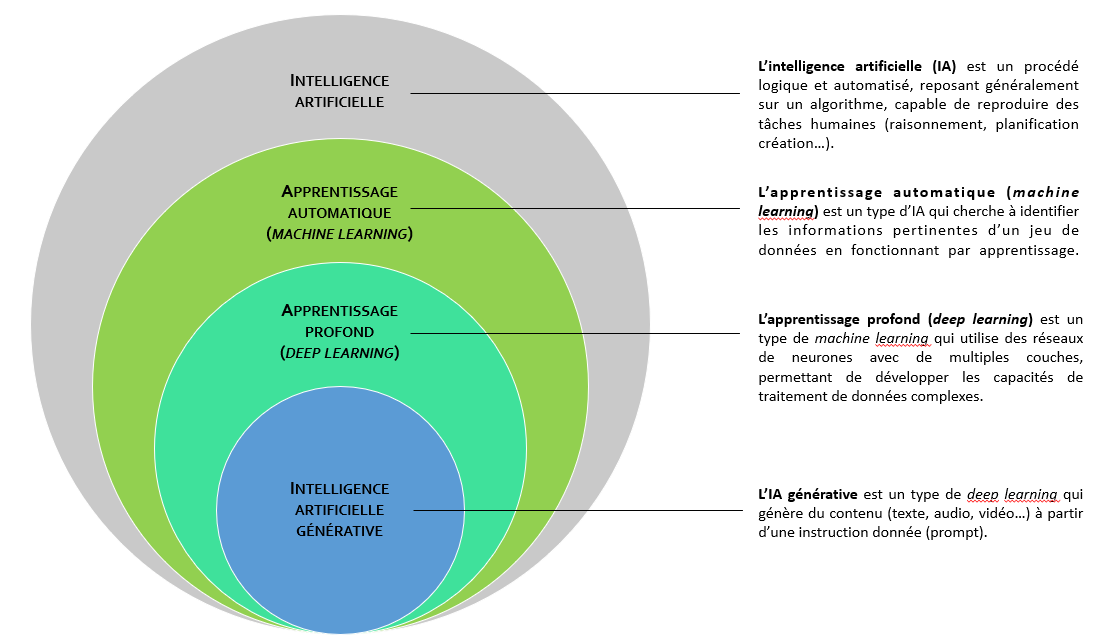

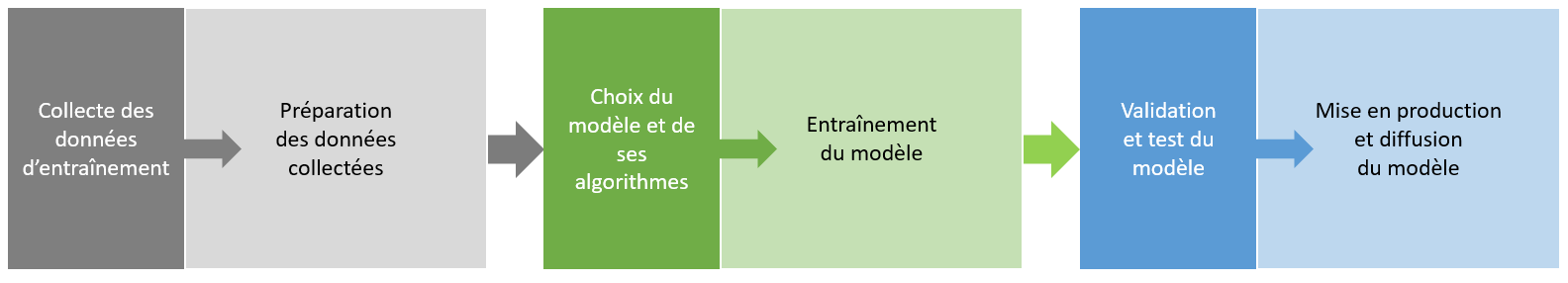

2. Les différentes étapes de la conception d'un modèle d'intelligence artificielle générative

La chaîne de conception d'un modèle d'IA générative comprend plusieurs étapes :

a) La collecte des données d'entraînement ou le grand moissonnage

Les données d'entrée (aussi dénommées données brutes) sont un élément-clef pour la création d'un modèle d'IA : ce sont en quelque sorte les ingrédients sans lesquels « la recette » IA ne peut être cuisinée. Sans données, une IA reste inerte, incapable d'apprendre et encore moins de prendre des décisions pertinentes.

Le terme « données » revêt ici un sens générique : il peut s'agir de données textuelles, de données d'image, de données sonores, de données vidéo, ou de données multi-supports...

Pour garantir l'efficacité, la précision et la fiabilité du modèle d'IA, les données doivent répondre à plusieurs critères :

- elles doivent être en quantité suffisante : pour qu'un modèle soit bien entraîné, il a besoin d'analyser beaucoup d'exemples, donc un volume très important de données ;

- elles doivent être de qualité : sans données pertinentes, précises et fiables, même les modèles d'IA les plus sophistiqués peuvent générer des résultats biaisés ou erronés ;

- elles doivent être diverses : plus les données sont variées, plus le modèle améliore la précision et la pertinence de ses réponses.

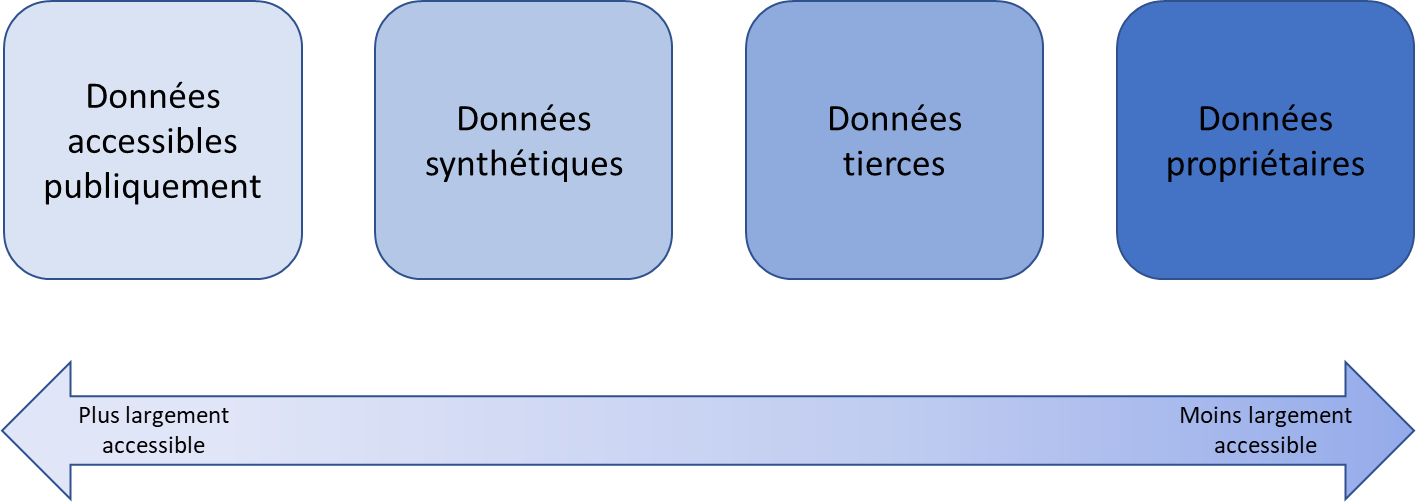

Il existe différents canaux de collecte de données d'entraînement.

La plus grande source d'approvisionnement est constituée de données accessibles publiquement en ligne. Le fait que ces données soient « publiques » ne signifie pas qu'elles soient librement exploitables - certaines peuvent être protégées par des droits, comme le droit de la propriété intellectuelle s'il s'agit d'un contenu considéré comme « original » (texte, image, vidéo...) ou le droit au respect de la vie privée s'il s'agit de données à caractère personnel (nom, image ou vidéo identifiant une personne physique), ni qu'elles soient licites - certaines peuvent avoir été piratées.

L'accès à ces données publiques se fait via des moteurs de recherche généralistes comme Google ou Yahoo, des bases de données spécialement constituées pour servir à alimenter les modèles d'IA comme Laion, des bases de données spécialisées dans certains domaines comme Library Genesis (LibGen) pour les contenus scientifiques, ou la base de données de l'organisation Common Crawl qui constitue une sorte de répertoire recensant tous les contenus trouvés sur Internet depuis une dizaine d'années4(*).

Pour collecter massivement et automatiquement des données librement accessibles en ligne, il est fait recours à la technique du web scraping qui signifie littéralement « raclage », mais qui est plus couramment traduite par le terme « moissonnage ». Elle permet, à l'aide de bots (applications logicielles automatisées) fonctionnant comme des robots « racleurs » ou « moissonneurs », de récupérer des données à partir du code source des pages Web concernées, puis de les restituer dans une base de données organisées de type tableur. De manière imaginée, cette opération revient à envoyer un robot dans une librairie pour qu'il rapporte des livres spécifiques. Dans le cas d'espèce, la librairie est un site Web et les livres sont des données.

Bien que les pratiques de moissonnage offrent des avantages importants en termes de rapidité, de quantité et de diversité des données collectées, elles posent de nombreuses questions sur la protection de la vie privée, le respect de la propriété intellectuelle, la rétribution des ayants droit. La Cnil a d'ailleurs régulièrement appelé à la vigilance concernant ces pratiques, dont la généralisation opère selon elle « un changement de nature quant à l'utilisation d'Internet, dans la mesure où toutes les données publiées en ligne par une personne sont désormais susceptibles d'être lues, collectées et réutilisées par des tiers, ce qui constitue un risque important et inédit pour les personnes ». En conséquence, la Cnil recommande la mise en place d'un encadrement législatif ad hoc5(*), qui permettrait à la fois de sécuriser les organismes y ayant recours, de réguler cette pratique et de protéger les données librement accessibles en ligne.

Il existe trois autres sources d'approvisionnement en données d'entraînement, qui sont d'un accès moins facile que la première :

· les données synthétiques, c'est-à-dire des données artificiellement conçues pour imiter les données du monde réel. Elles sont générées par des méthodes statistiques ou par des techniques d'IA ;

· les données propriétaires de tiers, à savoir des données collectées par des entités externes comme des courtiers en données. Les principales entreprises de ce secteur sont Experian, Equifax, Acxiom et Epsilon ;

· les données internes qui sont directement détenues par les entreprises développant des modèles d'IA.

Dans son récent rapport sur la rémunération des contenus culturels utilisés par les systèmes d'IA6(*) commandé par le Conseil supérieur de la propriété littéraire et artistique (CSPLA), la professeure Joëlle Farchy résume le degré d'accessibilité des différentes sources de données d'entraînement par le schéma suivant :

b) La préparation des données collectées

Avant d'être utilisées, les données brutes collectées doivent être préparées. Elles peuvent en effet comporter des anomalies, des incohérences, des doublons ou des valeurs manquantes. Une préparation rigoureuse permet de corriger ces problèmes qui pourraient entraîner des imprécisions, des biais, des erreurs, voire des hallucinations.

Cette étape comprend plusieurs tâches successives :

· le nettoyage des données : il vise à éliminer les anomalies, à corriger les erreurs, à supprimer les doublons, à remplacer les valeurs manquantes ;

· la structuration et la transformation des données : une fois nettoyées, les données doivent être préparées pour s'adapter aux exigences des algorithmes d'apprentissage. C'est là qu'intervient le processus dit de « tokenisation », par lequel les données sont segmentées en unités plus petites appelées tokens, plus faciles à appréhender par le modèle. S'en suit un processus d'encodage ou de vectorisation, au cours duquel chaque token est converti en valeur numérique que le modèle pourra directement traiter ;

· la normalisation et la mise à l'échelle des données : les données peuvent présenter des écarts importants en termes de grandeur ou d'échelle, ce qui peut perturber certains algorithmes d'apprentissage. La normalisation et la mise à l'échelle permettent de les harmoniser en ajustant leur valeur à une plage standard ;

· l'étiquetage des données : cette étape consiste à associer une annotation spécifique à chaque donnée. Cet étiquetage sert de guide pour l'apprentissage des modèles et garantit que les données sont interprétées correctement pendant l'entraînement ;

· l'enrichissement des données : pour améliorer la pertinence et l'affinage des données brutes, des informations supplémentaires peuvent être ajoutées. Cet enrichissement inclut l'intégration de métadonnées (c'est-à-dire de données fournissant des informations sur d'autres données), l'ajout de contextes ou la combinaison avec des données externes complémentaires ;

· l'équilibrage des données : un jeu de données déséquilibré, où certaines catégories sont sur-représentées, peut introduire des biais dans les modèles d'IA. L'équilibrage consiste à ajuster la distribution des données en réduisant ou en augmentant certaines catégories de données par rapport à d'autres ;

· la validation des données : cette étape inclut des contrôles automatiques ou manuels pour détecter d'éventuelles anomalies restantes et vérifier que le jeu de données est conforme aux exigences du projet ;

· le partitionnement des données : la dernière étape de la préparation des données consiste à les diviser en trois ensembles distincts :

ü un premier ensemble, comprenant généralement entre 70 % et 80 % des données, est consacré à l'entraînement du modèle ;

ü un deuxième ensemble, composé entre 10 % à 15 % des données, à sa validation ;

ü un troisième ensemble, également composé de 10 % à 15 % des données, à son test.

c) L'entraînement du modèle à partir des données préparées

Si la collecte et la préparation des données s'apparentent en quelque sorte à la base de la construction « IA », le choix de la technique d'entraînement (machine learning, deep learning) et des algorithmes associés constituent son architecture générale.

Une fois cette architecture mise en place, l'étape de l'entraînement peut commencer. Elle consiste à alimenter le modèle en données préparées, à examiner les résultats sortants (outputs), à procéder à des ajustements pour améliorer le modèle, et à reproduire ces mêmes étapes autant de fois que nécessaire.

L'entraînement d'un modèle d'IA est donc un processus itératif, semblable à la manière dont un enfant acquiert une compétence par la répétition.

S'il s'agit d'un modèle de fondation, une étape supplémentaire peut être introduite, consistant à procéder à un ajustement (fine-tuning) pour le spécialiser. Le modèle est alors réentraîné sur des données d'affinage, spécialisées.

d) La validation et le test du modèle

Une fois que le modèle a réussi la phase d'entraînement initiale, la phase de validation consiste à utiliser à un jeu de données distinct du jeu de données d'entraînement. L'objectif est d'évaluer les performances du modèle à partir de nouvelles données, généralement plus complexes.

Après la validation du modèle, un nouveau jeu de données est utilisé pour tester l'exactitude du modèle. Si le modèle fournit des résultats précis avec ces données de test, il est prêt à être mis en service. Si le modèle présente des lacunes, le processus d'entraînement se répète jusqu'à ce que le modèle respecte les objectifs de performance définis.

e) La mise en production et le déploiement du modèle

La mise en production, aussi appelée phase d'inférence, correspond au processus par lequel un modèle, préalablement entraîné, est utilisé pour effectuer des prévisions ou produire un résultat à partir de nouvelles données - aussi appelées données « fraîches » ou « données d'ancrage » - sans nécessiter d'entraînement. L'apport de ces nouvelles données permet d'ancrer le modèle dans l'actualité ou dans un contexte bien spécifique.

Une fois le modèle ancré, il est prêt à être intégré dans une infrastructure d'hébergement déjà existante ou nouvellement créée, de type solution cloud, installation sur site Web, application spécifique... Le modèle peut être libre d'accès (open source) ou distribué sous licence.

Les trois grandes catégories de

données utilisées

pour le fonctionnement des modèles

d'IA

Les données d'entraînement, « raclées » en très grande quantité (de l'ordre de plusieurs millions voire plusieurs milliards) pour servir à entraîner le modèle.

Les données d'affinage ou d'ajustement, sélectionnées pour spécialiser le modèle sur certaines tâches.

Les données d'ancrage, « fraîchement » recueillies pour ancrer le modèle dans l'actualité.

I. II. LA CRÉATION ARTISTIQUE FACE À LA VAGUE DE L'INTELLIGENCE ARTIFICIELLE : NOUVEL HORIZON ARTISTIQUE OU PARASITISME CRÉATIF ?

A. COMMENT L'INTELLIGENCE ARTIFICIELLE BOULEVERSE LE PROCESSUS DE CRÉATION

1. Des premières expériences artistiques recourant à l'intelligence artificielle aux premières oeuvres intégralement générées par celle-ci

La création artistique, la science et la technique sont depuis toujours très imbriquées. Les avancées scientifiques permettent de développer de nouvelles techniques que le secteur artistique, qui peut d'abord s'y montrer réticent voire hostile, s'approprie ensuite pour faire évoluer la création.

L'invention de la photographie au début du XIXe siècle est un exemple particulièrement caractéristique de cette ambivalence. Perçue initialement comme une menace par certains artistes, parmi lesquels les poètes Alphonse de Lamartine et Charles Baudelaire, qui craignaient qu'elle ne remplace l'art pictural, la photographie trouve progressivement sa place dans le monde de la création, y compris chez les peintres qui l'utilisent comme moyen de reproduction et de documentation de leur oeuvre, à l'instar de Gustave Courbet ou d'Edgar Degas. Dans la deuxième moitié du XIXe siècle, elle acquiert progressivement ses lettres de noblesse en tant qu'art avec les premiers photographes-artistes comme Gustave Le Gray ou Eugène Atget.

L'apparition des premiers ordinateurs un peu avant le milieu du XXe siècle bouleverse à son tour la pratique artistique, en permettant l'utilisation de techniques d'automatisation dans le processus créatif. C'est à cette époque qu'émerge l'art génératif, mouvement artistique qui explore les possibilités offertes par l'informatique et les algorithmes pour permettre à des machines de créer de manière autonome. Le cybernéticien Albert Ducrocq est l'un des précurseurs dans ce domaine : il crée en 1953 l'un des premiers générateurs automatiques de poèmes, dénommé Calliope. Des expérimentations dans les arts visuels voient également le jour, comme celles de l'artiste Jean Tinguely qui développe une série de vingt Méta-Matic entre 1955 et 1960, sorte de sculptures animées capables de dessiner et de créer des oeuvres d'art. Le secteur musical n'échappe pas à cette fascination pour l'électronique : en 1955, le premier morceau de musique généré par ordinateur est créé par Lejaren Hiller et Leonard Isaacson à l'Université de l'Illinois7(*) ; en 1958, le compositeur français Pierre Schaeffer crée le groupe de recherches musicales (GRM), important centre de recherche et d'expérimentations en musique électroacoustique.

Toutes ces expériences artistiques préfigurent l'arrivée de l'IA dans le monde de la création à partir des années 1960. Les potentialités qu'elle offre sont notamment mises à profit par les pionniers de l'art numérique, comme Michael Noll, qui crée certaines des premières images générées par ordinateur, ou Vera Molnar, première artiste à produire en France des dessins numériques. En 1970, l'artiste Harold Cohen met au point un programme informatique, nommé Aaron, capable de créer des dessins et des peintures de manière autonome.

C'est dans la décennie 2010, avec l'essor des techniques d'apprentissage profond et l'apparition de l'IA générative, qu'un changement de paradigme s'opère. Jusqu'alors relativement limitées, les capacités démiurgiques de l'IA connaissent un changement d'échelle sans précédent. Les réseaux antagonistes génératifs (GAN), introduits en 2014, sont les premiers modèles d'IA générative dont se servent les artistes. Le lancement en 2022 de modèles tels Stable Diffusion, DALL-E et Midjourney marque un véritable tournant dans l'histoire de la création. Désormais, l'IA est en mesure de générer de nouvelles oeuvres (dessin, morceau de musique, texte...) à partir des milliards de données qui l'ont nourrie, la part humaine de ces créations se limitant à la commande adressée à la machine (prompt). Cette nouvelle donne technologique, qui peut être qualifiée de disruptive, soulève des interrogations fondamentales, d'ordre éthique et juridique, sur l'essence même de l'acte de création, le degré de créativité d'une oeuvre, la fonction de l'artiste et le devenir de l'expression artistique.

2. Une échelle de gradation de la place de l'intelligence artificielle dans le processus créatif

a) L'intelligence artificielle comme outil au service du créateur

Aujourd'hui présente dans toutes les esthétiques, l'IA offre aux artistes un arsenal d'outils novateurs, leur permettant de faciliter, d'enrichir, d'étendre leur pratique créative. Cette assistance se manifeste de multiples façons, à différentes étapes du processus créatif :

· comme outil d'inspiration, l'IA propose des idées, des suggestions d'amélioration, des associations ou des comparaisons avec d'autres approches artistiques, stimulant ainsi la créativité de l'artiste ;

· comme outil d'automatisation, elle prend en charge certains aspects techniques, permettant à l'artiste de se concentrer sur les étapes les plus créatives de son oeuvre ;

· comme outil de perfectionnement, elle affine certaines caractéristiques matérielles d'une oeuvre ;

· comme outil de diffusion, elle améliore l'accessibilité d'une oeuvre.

Ces formes d'aide à la création ne se substituent pas à la vision créative de l'artiste, mais ouvrent plutôt de nouvelles perspectives d'expression et d'expérimentation.

b) L'intelligence artificielle comme co-partenaire de création

Au-delà de la simple assistance, l'usage de l'IA générative dans la création ouvre aussi la voie à des pratiques collaboratives entre l'artiste et la machine.

Cette co-création est rendue possible par la complémentarité des compétences : tandis que l'artiste apporte sa sensibilité esthétique, son intention artistique, sa compréhension du contexte culturel, historique et social dans lequel va s'inscrire l'oeuvre, l'IA déploie sa capacité d'analyse et de traitement de grandes quantités de données. Des échanges entre ces deux pôles émerge une collaboration hybride qui ouvre un vaste champ de possibilités créatives et qui s'inscrit, selon certains spécialistes, dans la continuité du travail en atelier où la créativité s'exerce indirectement via des instructions, la réalisation étant confiée à des exécutants.

c) L'intelligence artificielle comme créateur à part entière ?

Avec l'essor et la démocratisation des techniques d'IA générative, créer une image, un morceau de musique, un texte, devient à la portée de tous, moyennant la maîtrise des prompts. La création artistique humaine, qui reposait jusqu'alors sur un subtil dosage entre des qualités innées et des compétences acquises, est aujourd'hui confrontée à une nouvelle forme de création, accessible en quelques mots-clés.

Cette situation pose avec une acuité particulière la question du rôle de l'humain dans la création et de la potentielle substitution des artistes par l'IA. Suscitant de vifs débats, celle-ci ne peut recevoir de réponse tranchée car nul ne peut présager des futures avancées technologiques de l'IA.

À ce jour, il peut simplement être constaté que si l'IA est en capacité de produire une oeuvre nouvelle, elle le fait sans intention, sans émotion, sans vécu, sans prise en compte du contexte. Elle ne fait que répondre à une commande donnée par l'homme, à partir de contenus déjà existants, sans conscience du sens et de la portée de sa création. L'humain reste celui qui initie la démarche, qui choisit de donner tel sens et telle forme à l'oeuvre. L'IA demeure donc une potentialité que l'homme, avec plus ou moins de talent, peut exploiter à des degrés divers.

3. Principaux cas d'usage de l'intelligence artificielle dans les industries culturelles et créatives

IA et création artistique : un sujet d'exposition

Preuve que le sujet fascine, le musée du Jeu de Paume à Paris propose actuellement une grande exposition « Le monde selon l'IA », la première de cette ampleur à explorer les interactions entre l'IA et la création artistique, en embrassant toute une variété de médiums, de la photographie au cinéma, en passant par la peinture, la sculpture et la vidéo.

Y est présentée une sélection d'oeuvres créées entre 2016 et aujourd'hui, dont plusieurs inédites, qui posent la question de l'expérience du monde « selon l'IA » ou « au prisme de l'IA ».

a) Dans les arts visuels

De par leur rapport intrinsèque à l'image, les arts visuels constituent un terrain artistique très propice à l'usage de l'IA. C'est d'ailleurs dans les arts visuels que celle-ci a trouvé ses premières applications artistiques (voir supra).

Depuis une dizaine d'années, les artistes visuels se sont emparés des technologies d'IA pour faciliter et améliorer leur processus créatif, expérimenter de nouvelles techniques, s'ouvrir à d'autres styles, réaliser des installations interactives avec le public. Dans tous ces usages, l'IA agit à la fois comme outil d'aide à la création et catalyseur pour l'inspiration.

En 2016, The Next Rembrandt, un tableau composé par une IA à partir de l'analyse de 346 oeuvres du maître hollandais est présenté à Amsterdam.

En 2018, le collectif français Obvious, dont la mission d'information a auditionné l'un des membres, réalise une série de onze portraits représentant une famille bourgeoise fictive des XVIIIe et XIXe siècles, les Belamy, grâce à une IA entraînée à partir de milliers de portraits de la peinture classique. L'un des portraits de cette série, celui d'Edmond de Belamy, est vendu chez Christie's pour près d'un demi-million de dollars, une première pour une oeuvre générée par l'IA.

En 2022, l'installation « Hyperphantasia, des origines de l'image » de l'artiste plasticienne française Justine Emard, conçue en collaboration avec des archéologues et des préhistoriens, fait appel à l'IA générative : des GAN, entraînés sur un vaste corpus d'images de la grotte Chauvet-Pont d'Arc, ont permis d'obtenir des variantes de ces dessins préhistoriques.

En 2025, l'artiste turco-américain Refik Anadol présente au musée Guggenheim de Bilbao une installation audiovisuelle qui, à l'aide de l'IA, réimagine l'héritage architectural de Franck Gehry. Le logiciel utilisé a été entraîné pendant des mois avec des images, des croquis, des plans du célèbre architecte afin de traduire son vocabulaire en paysage numérique de formes, de couleurs et de mouvements en constante évolution.

b) Dans le cinéma et l'animation

Tout comme les arts visuels, les filières de l'image animée (cinéma, audiovisuel, jeu vidéo) ont depuis une dizaine d'années recours à l'IA pour ses potentialités techniques. La puissance inédite des modèles d'IA générative, comme Midjourney ou ChatGPT, bouleverse toutefois en profondeur la manière dont sont produites les oeuvres cinématographiques, audiovisuelles et vidéoludiques.

Une étude publiée en avril 2024 par le Centre national de la cinématographie et de l'image animée (CNC)8(*), dans le cadre de son Observatoire de l'IA, et dont les principaux enseignements ont été présentés à la mission d'information, offre une cartographie très intéressante des usages actuels et potentiels de l'IA dans ces filières.

Il en ressort les grands constats suivants :

· les applications de l'IA sont nombreuses (une soixantaine de cas d'usage a été identifiée dans le cadre de cette étude), sur l'ensemble des chaînes de valeur du cinéma, de l'audiovisuel et du jeu vidéo, avec un potentiel plus marqué pour les étapes de post-production, d'animation et d'effets visuels, et pour le secteur des jeux vidéo ;

En phase de préproduction, l'IA est notamment utilisée pour :

- analyser les attentes du public, repérer les éléments narratifs les plus susceptibles de lui plaire et orienter les choix créatifs en fonction des attentes identifiées ;

- générer des scripts à partir de l'analyse de scénarios existants ;

- aider à l'écriture de scénarios ;

- concevoir des storyboards.

En phase de production, l'IA permet d'automatiser des tâches logistiques comme l'élaboration des plannings de tournage.

En phase de postproduction, l'IA ouvre de nouvelles opportunités en matière de :

- montage vidéo et son ;

- création d'effets spéciaux (réalisation de visuels plus complexes et plus réalistes, création de scènes de masse sans figurants réels, vieillissement ou rajeunissement d'acteurs, « renaissance » d'acteurs décédés) ;

- composition de bandes originales ou d'effets sonores personnalisés ; techniques de post-synchronisation, doublage, synchronisation labiale et sous-titrage.

· les opportunités offertes par l'IA sont de divers ordres : gain de productivité, augmentation des capacités de production, stimulation de la créativité via les échanges homme-machine et la réallocation du temps vers les tâches à plus forte valeur créative, ouverture sur de nouveaux possibles techniques, créatifs et économiques, meilleure accessibilité des oeuvres ;

· les acteurs de ces filières n'adoptent pas l'IA à la même vitesse, ni dans les mêmes proportions, d'où un impact-métier de l'IA à géométrie variable : les acteurs de grande taille et ceux davantage tournés vers l'innovation sont plus susceptibles de s'adapter aux nouveaux usages que ceux de petite taille et ceux moins directement concernés par la technologie.

c) Dans la musique

Bien que l'attrait du secteur musical pour les technologies informatiques puis numériques remonte à plusieurs décennies, les capacités désormais offertes par l'IA générative sont sans commune mesure pour les acteurs de la filière.

L'IA leur permet, entre autres :

· d'améliorer la qualité sonore, en corrigeant les imperfections audio, en ajoutant des effets sonores, en augmentant la dynamique ;

· d'explorer de nouveaux territoires sonores, en créant de nouvelles combinaisons de sons, en générant des sons inhabituels ou en modifiant les sons existants ;

· de générer, à partir de l'analyse de milliers de morceaux et de l'extraction de leurs éléments constitutifs (mélodies, harmonies, rythmes...) de la musique originale dans une multitude de styles et pour diverses applications (musique d'ambiance, musique de film, musique de publicité...).

d) Dans la littérature

En comparaison des autres secteurs, celui de la création littéraire semble pour le moment un peu moins perméable à l'IA, même si ChatGPT est désormais capable de générer des écrits originaux ou des récits à la manière de tel ou tel auteur, disponibles à la vente sur de grandes plateformes en ligne.

Des cas d'usage explicites sont toutefois à mentionner :

· en 2018, une petite maison d'édition française, Jean Boîte, publie un roman en anglais, 1 the Road, exclusivement écrite par une IA entraînée sur des livres classiques américains ;

· en 2024, l'autrice japonaise Rie Kudan, lauréate du prestigieux prix littéraire Akutagawa pour son livre « La Tour de compassion de Tokyo », a révélé qu'environ 5 % de son roman futuriste avait été écrit par ChatGPT, précisant que le logiciel l'avait aidée à libérer son potentiel créatif.

D'autres cas d'usage, plus expérimentaux et confidentiels, ont également sans doute cours.

B. LA CONCURRENCE D'UNE NOUVELLE FORME DE CRÉATION QUI POSE UN DÉFI ÉCONOMIQUE, SOCIAL ET CULTUREL

1. Les contenus culturels sortants : des productions parasitaires

L'atteinte au droit d'auteur à l'entrée des modèles d'IA (voir infra), qui se matérialise par la collecte et la transformation d'une vaste quantité de données d'entraînement à contenus culturels protégés, entraîne une concurrence déloyale en sortie de modèle, tout aussi grave voire plus inquiétante pour l'avenir de la création artistique humaine.

Cette concurrence peut même être qualifiée de parasitaire puisque, dans le cas d'espèce, un agent économique - le fournisseur d'IA - s'immisce dans le sillage d'un autre - le créateur - afin de tirer profit, sans rien dépenser, de ses efforts et de son savoir-faire.

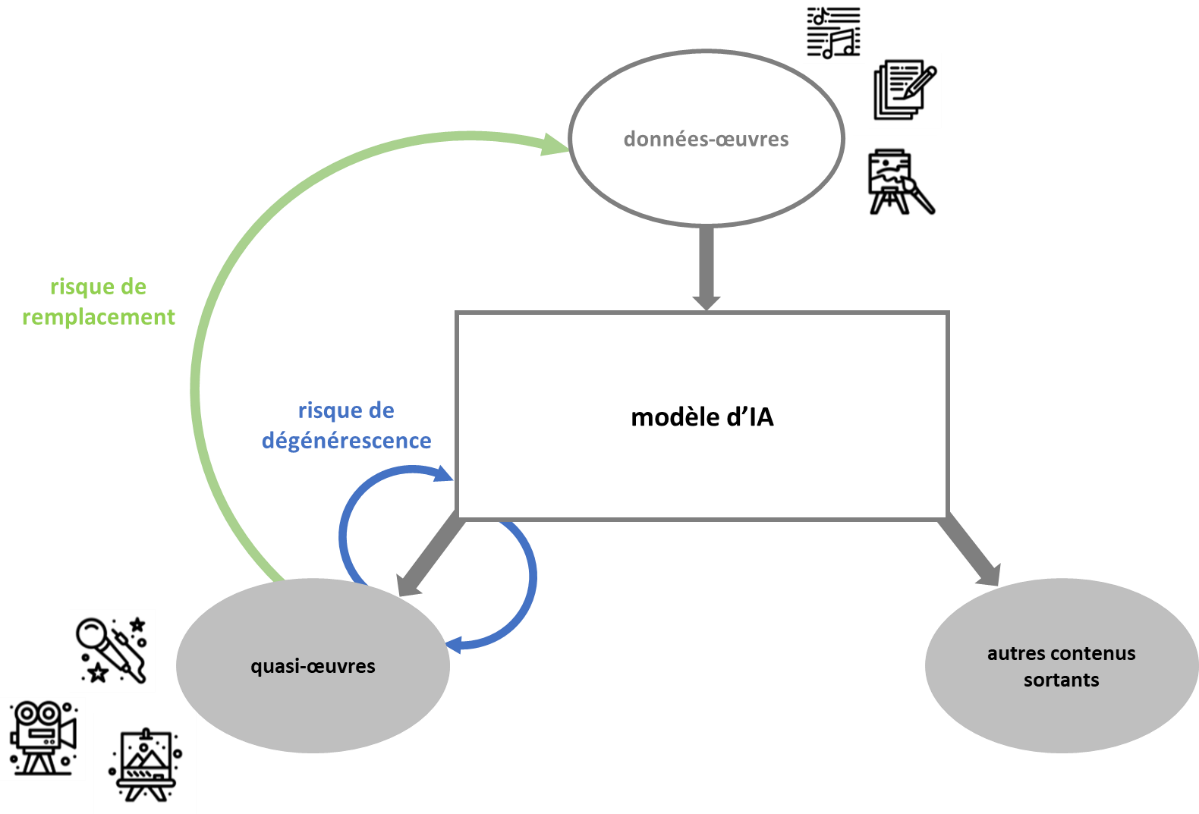

En effet, l'IA générative produit des données sortantes qui entrent directement en concurrence avec les données-oeuvres humaines ayant servi à leur élaboration. Ces contenus culturels concurrents, la professeure Joëlle Farchy les nomme des « quasi-oeuvres » dans son rapport remis au CSPLA9(*) pour signifier qu'ils ne remplissent pas la condition d'originalité propre aux oeuvres de l'esprit, lesquelles sont, de fait, protégées par le droit d'auteur.

La notion d'originalité d'une oeuvre

La notion d'originalité d'une oeuvre n'étant pas définie dans la loi, c'est la jurisprudence qui est venue la caractériser et la poser en condition essentielle à la protection par le droit d'auteur.

Selon différents arrêts de la Cour de Cassation, l'originalité s'entend comme « le reflet de la personnalité de l'auteur », « l'expression ou l'empreinte de la personnalité du créateur » ou « l'empreinte du talent créateur personnel ». La notion subjective d'originalité s'oppose ainsi à la notion objective de nouveauté, qui renvoie à l'absence d'antériorité.

En droit européen, la notion d'originalité est définie comme « la création intellectuelle propre à (son) auteur » (CJCE, 16 juill. 2009, aff. C-5/08, pt 35).

Source :

« Rémunération des contenus culturels

utilisés par les systèmes d'intelligence

artificielle », projet de rapport - volet économique, mission

confiée par le Conseil supérieur

de la propriété

littéraire et artistique, Joëlle Farchy et Bastien Blain,

mai 2025.

Ainsi que l'explique Joëlle Farchy dans son rapport précité, l'IA engendre, avec ses « quasi-oeuvres », un effet d'éviction des oeuvres humaines :

· par les prix, du fait de sa capacité à produire plus vite et moins cher que ne le font les hommes ;

· par les quantités, compte des volumes de contenus qu'elle est en mesure de générer, lesquels viendront saturer le marché au détriment des oeuvres humaines.

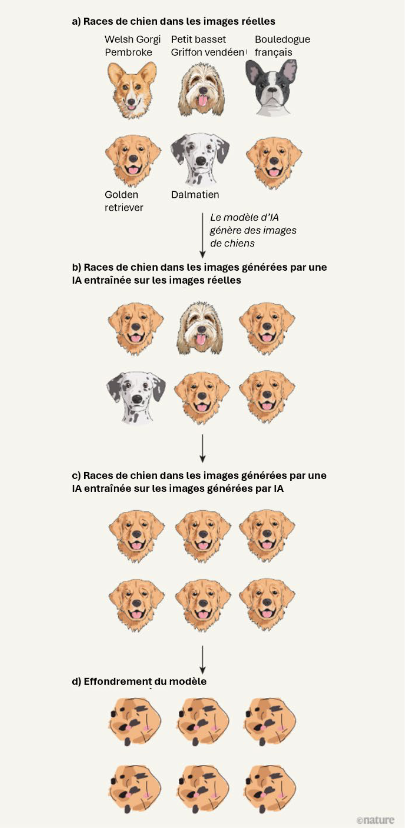

Cette déstabilisation économique du secteur de la création, inédite par sa nature et son ampleur, fait craindre un double risque :

· un risque de substitution des créateurs par les machines (« le grand remplacement ») ;

· un risque de dévitalisation de la création artistique se traduisant par une production standardisée et déshumanisée.

Des prévisions de perte de revenus pour les créateurs encore incertaines

Dans le domaine de la musique, une étude de la Confédération internationale des sociétés d'auteurs et de compositeurs (Cisac), publiée en novembre 2024 prévoit une diminution des revenus des créateurs dans le monde de 24 %, soit 10 milliards de dollars d'ici à 2028, sous l'effet de l'arrivée massive d'oeuvres générées par l'IA.

Pour autant, les auditions menées par la mission d'information ont montré que si de plus en plus de contenus musicaux produits par l'IA étaient bien présents sur les plateformes de streaming - entre 15 % et 20 % à l'heure actuelle -, ils ne généraient que des revenus marginaux, de l'ordre de 0,5 %. Il est donc à ce stade trop tôt pour extrapoler le lien entre quantité de contenus générés par l'IA et perte de revenus pour les créateurs.

2. Une menace pour les métiers de la création

a) Une menace plus ou moins forte selon les métiers

L'impact de l'IA sur les métiers de la création peut, à ce jour, difficilement faire l'objet d'un état des lieux global et exhaustif, les études sur le sujet restant encore limitées et souvent sectorielles. Néanmoins, à partir de celles disponibles - en particulier l'étude précitée du CNC - et des remontées de terrain des professionnels, quelques grandes tendances se dessinent.

Premier constat, l'IA générative, en se substituant à certaines tâches nécessitant des compétences avancées et spécialisées, concurrence davantage les emplois qualifiés que ceux non qualifiés. Contrairement aux précédentes révolutions industrielles, ce sont les « cols blancs » qui sont aujourd'hui principalement menacés.

Deuxième constat, l'IA n'affecte pas ces emplois qualifiés dans les mêmes proportions. Leur exposition au risque de remplacement dépend du degré de maturité technologique de leur domaine d'activité et du taux de pénétration des applications d'IA au sein de celui-ci. Par exemple, l'IA ayant fait, au cours des dernières années, des avancées particulièrement notables sur la compréhension du texte et la génération de voix, est plus à même d'affecter les métiers de l'écriture et de la voix, que ceux de la vidéo et de la modélisation 3D, secteurs encore en développement technologique.

Troisième constat, l'IA bouleverse potentiellement plus fortement les métiers de la création à forte composante technique plutôt que ceux à dominante artistique. Par exemple, des métiers comme réalisateur, compositeur ou comédien ont un potentiel d'automatisation plus faible que des métiers comme monteur son, bruiteur ou artiste en effets visuels.

b) Un risque existentiel pour certaines professions

Si l'impact de l'IA sur les métiers de la création dépend de multiples facteurs et n'est, de ce fait, pas facilement analysable, certaines professions, dont la mission d'information a tenu à échanger avec les représentants, sont indéniablement touchées de plein fouet. Pour elles, leur survie est en jeu.

Les graphistes sont particulièrement menacés par des systèmes d'IA générative d'images comme Midjourney. Au Royaume-Uni, la Society of Authors a estimé via un sondage qu'environ un quart des illustrateurs a déjà perdu du travail en raison de l'IA ge'ne'rative. En outre, plus d'un tiers des illustrateurs interrogés de'clarent que leurs revenus ont diminue' en valeur a` cause d'elle.

Les doubleurs sont très durement exposés à la concurrence de systèmes d'IA générative comme HeyGen, Eleven Labs ou Deepbub qui permettent de cloner des voix et de traduire des vidéos en plusieurs langues tout en adaptant les mouvements des lèvres. L'utilisation de plus en plus systématique de ces outils se fait au détriment de l'enregistrement en studio des doublages par des comédiens. Selon une étude du Datalab du groupe Audiens, 15 000 emplois directs de comédien de doublage sont ainsi menacés en Île-de-France.

Les traducteurs sont également fortement fragilisés par le déploiement de systèmes d'IA générative de traduction comme DeepL. Leurs commandes diminuent, elles changent de nature (moins de traductions complètes, davantage de prestations de correction de traductions effectuées par l'IA), entraînant une perte de revenus. Au sein de la profession, certaines spécialités comme la traduction de BD ou de livres audio sont plus affectées que d'autres (comme la traduction littéraire).

c) Un besoin urgent de formation et d'accompagnement des professionnels

La mission d'information estime que les secousses produites par l'IA générative sur les métiers de la création, d'intensités variables et aux conséquences plus ou moins lourdes - allant de la transformation des pratiques professionnelles à la disparition pure et simple de certaines professions - rendent indispensables, à court terme, la mise en place, par les industries culturelles et créatives et les pouvoirs publics, d'actions de formation et d'accompagnement pour les professionnels concernés.

L'objectif, certes délicat mais primordial, est de leur donner les moyens de prendre la vague de l'IA, tout en préservant, quand cela est possible, leur niveau de savoir-faire « traditionnel ».

3. Un risque d'uniformisation et de déshumanisation de la création artistique

Au défi économique et social que pose l'essor de l'IA générative à l'écosystème de la création fait écho un défi culturel et anthropologique.

La concentration de la puissance technologique entre quelques grands acteurs dominants, la standardisation des algorithmes et la persistance inévitable de biais dans les bases de données utilisées pour l'entraînement des modèles d'IA font courir un risque d'uniformisation des contenus culturels générés.

Sachant que ces « quasi-oeuvres » sont elles aussi appelées à entrer dans les prochaines bases d'apprentissage, il y a là une forme de consanguinité porteuse de danger pour la diversité et la richesse des créations à venir.

Ce risque d'appauvrissement artistique de la création se doublerait d'un risque de perte d'authenticité et d'originalité, qualités qu'à ce jour, seul un artiste humain peut apporter grâce à son vécu, sa sensibilité, son savoir-faire et son expérience.

La mission d'information estime qu'il est encore temps de ne pas emprunter cette voie déshumanisée.

I. III. UN ENCADREMENT JURIDIQUE EN CONSTRUCTION AU NIVEAU MONDIAL

Le développement extrêmement rapide des IA génératives au début de la décennie 2020 et surtout la forte médiatisation de ChatGPT, développé par la société OpenAI qui réalise déjà un chiffre d'affaires annuel de 10 milliards de dollars et compte 500 millions d'utilisateurs par semaine, a révélé le retard des législations sur la technologie, en particulier en matière de droits d'auteur.