B. GLOSSAIRE DE L'INTELLIGENCE ARTIFICIELLE

Le vocabulaire autour de l'IA est composé d'une multitude de termes et d'expressions, souvent techniques et pas toujours utilisés à bon escient. L'objectif ici est de faciliter la compréhension des différentes notions relatives à l'IA, en identifiant ce qui les lie et les différencie.

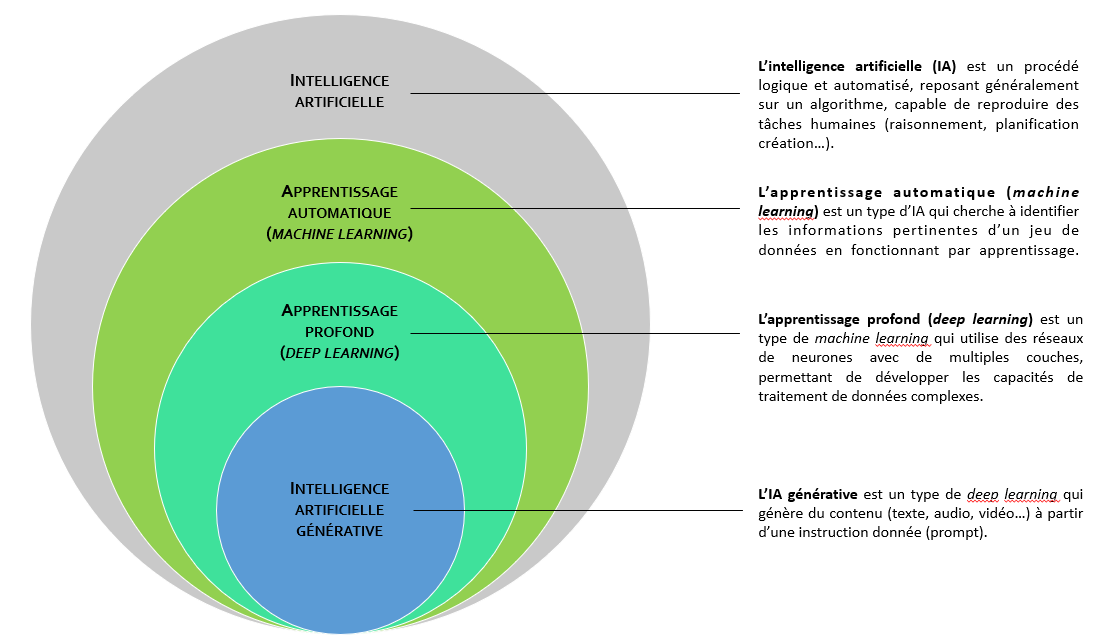

1. L'intelligence artificielle et ses sous-domaines

Au fur et à mesure de ses avancées scientifiques et technologiques, l'IA, qui est en quelque sorte la discipline-mère, a donné naissance à des sous-domaines, qui peuvent être représentés en sous-ensembles concentriques.

a) L'apprentissage automatique (machine learning)

Le machine learning est un champ d'études au sein de l'IA qui vise à donner aux machines la capacité d'apprendre à partir de données, via des modèles mathématiques utilisant des algorithmes probabilistes.

Plus précisément, il s'agit du procédé par lequel une machine, au moyen de techniques algorithmiques et sans l'intervention additionnelle de son programmateur, traite et analyse des données, apprend de ces données, estime la probabilité de résultats et prend des décisions fondées sur ce qu'elle a appris. Plus la machine réalise cet apprentissage, plus ses performances s'améliorent. En outre, plus le volume de données auquel elle a accès est important, plus ses résultats progressent.

Schéma d'un modèle d'apprentissage automatique (machine learning)

Le machine learning se décline en quatre principaux modèles d'apprentissage, qui emploient chacun des techniques algorithmiques différentes :

· l'apprentissage supervisé : dans ce premier modèle, la machine s'entraîne, au moyen d'un algorithme, à une tâche déterminée (ou clef de réponse) en utilisant un jeu de données assorties chacune d'une annotation (ou données étiquetées) indiquant le résultat attendu ;

· l'apprentissage non supervisé : dans ce deuxième modèle, la machine s'entraîne, au moyen d'un algorithme, sans tâche déterminée (sans clef de réponse) en utilisant un jeu de données brutes (sans étiquetage). En détectant des récurrences, des similarités, des corrélations entre certaines de ces données, elle obtient un résultat ;

· l'apprentissage semi-supervisé : dans ce troisième modèle, intermédiaire entre les deux premiers, la machine s'entraîne, au moyen d'un algorithme, à partir de petits volumes de données étiquetées pour analyser de gros volumes de données non étiquetées ;

· l'apprentissage par renforcement : dans ce quatrième modèle, la machine, qui connaît la clef de réponse, apprend en expérimentant différentes actions et en attribuant une valeur positive ou négative à chacune d'entre elles en fonction du résultat obtenu. Elle cherche, au fil des expériences, à maximiser la somme des récompenses, donc à parvenir à une solution décisionnelle optimale.

Dans chacun de ces modèles, une ou plusieurs techniques algorithmiques peuvent être appliquées ; tout dépend des jeux de données qui seront utilisés et de l'objectif visé au niveau des résultats. Par nature, les algorithmes du machine learning sont conçus pour classifier des éléments, repérer des motifs récurrents (patterns), prévoir des résultats (analyse probabiliste) et prendre des décisions éclairées. Les algorithmes peuvent être mis en oeuvre individuellement ou en groupe dans le but d'atteindre la plus grande précision possible lorsque les données utilisées sont complexes et imprévisibles.

b) L'apprentissage profond (deep learning)

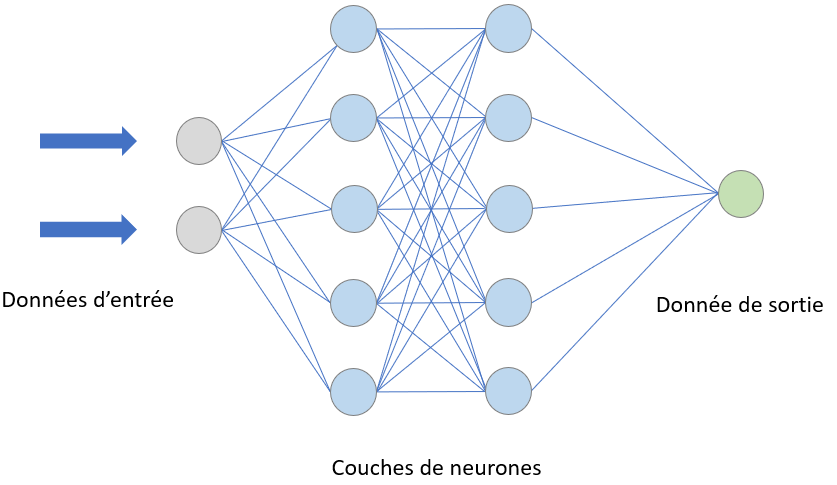

Le deep learning est un sous-ensemble du machine learning qui recourt à l'apprentissage supervisé, mais avec une architecture bien spécifique, celle d'un réseau de neurones artificiels agencé sous la même forme que les neurones d'un cerveau biologique. Les neurones artificiels composant un réseau s'appellent des « noeuds », qui sont connectés et regroupés en « couches ». Lorsqu'un noeud reçoit un signal digital, il le transmet alors à d'autres neurones appropriés, qui fonctionnent en parallèle.

Réseau de neurones artificiels

Cet apprentissage, qui fait appel à d'énormes volumes de données, complexes et disparates, est qualifié de « profond » (deep) car il fonctionne par « couches » : les résultats de la première « couche » de neurones vont servir d'entrée au calcul des autres, et ainsi de suite. Plus on augmente le nombre de couches, plus les réseaux de neurones apprennent des choses compliquées, abstraites, se rapprochant de plus en plus du fonctionnement d'un cerveau humain.

Par exemple, un modèle d'apprentissage profond qui traite des images de la nature et recherche des roses jaunes va d'abord reconnaître une plante dans la première couche. Au fur et à mesure qu'il va avancer dans les couches, il va ensuite identifier une fleur, puis une rose, et enfin une rose jaune.

Il existe différents types de réseaux neuronaux artificiels, parmi lesquels :

· les réseaux neuronaux convolutifs (CNN) : ils sont basés sur la structure du cortex visuel et utilisent des couches convolutives pour extraire les caractéristiques d'une image d'entrée. Ces CNN sont principalement utilisés pour des tâches de reconnaissance d'images ;

· les réseaux neuronaux récurrents (RNN) : ils permettent de « se souvenir » des informations passées et de les utiliser pour prendre des décisions en temps réel. Ces RNN sont spécialement utilisés pour l'analyse de séquences de données ;

· les réseaux antagonistes génératifs (GAN) : introduite pour la première fois en 2014, cette architecture repose sur deux réseaux neuronaux qui s'affrontent. L'un des réseaux, le générateur, crée des données originales, tandis que l'autre, le discriminateur, évalue si les données sont générées par l'IA ou réelles. Grâce à une méthode d'apprentissage profond et à une boucle de rétroaction qui pénalise le discriminateur en cas d'erreur, les GAN apprennent à générer un contenu de plus en plus réaliste ;

· les réseaux neuronaux Transformer (TNN) : cette architecture de réseau neuronal, introduite par l'article « Attention is All You Need » publié par des chercheurs de Google en 2017, est très novatrice par rapport aux architectures traditionnelles de traitement de séquences de données comme les CNN ou les RNN. Transformer repose sur un mécanisme d'auto-attention : au lieu de traiter les données dans l'ordre, il examine simultanément différentes parties de la séquence et détermine lesquelles sont les plus importantes. Ce fonctionnement non séquentiel, qui apporte flexibilité, adaptation et rapidité, permet de réaliser une multitude de tâches (génération d'images, traduction automatique, compréhension des séquences, détection d'anomalies...).

c) L'intelligence artificielle générative et sa capacité créatrice

L'IA dite « générative » (qualificatif dérivé du supin latin generatum, qui signifie « pour créer ») est un type d'IA capable de générer des contenus nouveaux couvrant un spectre très large (texte, code informatique, images, musique, audio, vidéos, etc.), à partir des données grâce auxquelles elle a été formée. Ces contenus nouveaux ressemblent à ce que l'on peut trouver dans ces données dites « d'entraînement », mais ils ne sont pas semblables, d'où leur caractère original.

C'est cette créativité - entendue au sens de la capacité à générer une production originale - qui distingue l'IA générative de l'IA prédictive, laquelle prévoit et anticipe mais ne crée pas.

L'IA générative repose principalement sur des techniques d'apprentissage profond. Autrement dit, elle est une application du deep learning qui se concentre sur la génération de contenus nouveaux.

L'IA générative, tout comme l'apprentissage automatique dont elle est issue, est par nature probabiliste : à partir des données d'entraînement, elle va estimer la probabilité de différents résultats et générer des contenus sortants qui découlent des probabilités apprises. Cela explique pourquoi elle est susceptible de produire des résultats erronés ou de pures inventions, appelées hallucinations, qui sont à l'origine de sa dégénérescence (voir infra).

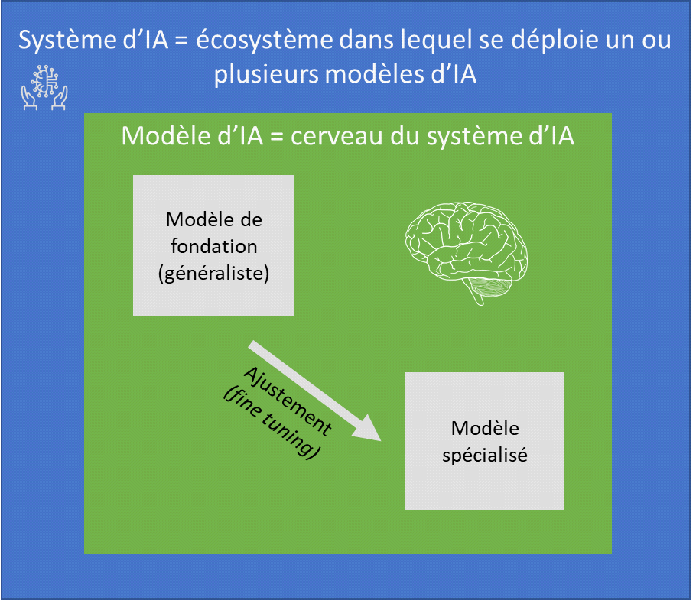

2. Modèle d'intelligence artificielle vs système d'intelligence artificielle

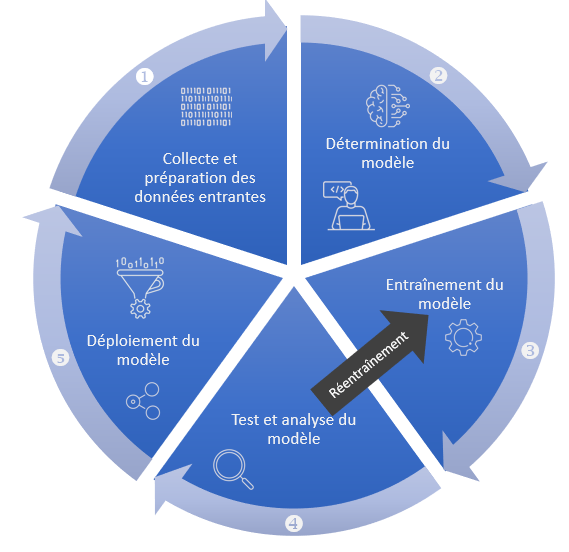

Un modèle d'IA est un programme informatique qui applique un ou plusieurs algorithmes à un jeu de données pour reconnaître des motifs, réaliser des tâches spécifiques ou prendre des décisions. Un modèle d'IA est intégré à un système d'IA, dont il est une composante essentielle, son cerveau en quelque sorte. Il est construit et optimisé à travers un processus d'entraînement, où il apprend à partir de données entrantes pour améliorer sa précision et son efficacité.

Un système d'IA est une application plus large qui englobe non seulement un ou plusieurs modèles d'IA, mais aussi tout l'écosystème nécessaire à leur fonctionnement. Il inclut des processus de collecte de données, des interfaces utilisateurs, une infrastructure technique (serveurs, bases de données) pour déployer efficacement l'IA dans des environnements pratiques. En d'autres termes, un système IA est une solution complète qui met en oeuvre des modèles IA dans un cadre opérationnel.

Au sein des modèles d'IA, on distingue les modèles de fondation, à usage général, et les modèles spécialisés :

· un modèle de fondation désigne un modèle d'IA de très grande taille, entraîné sur d'énormes quantités de données brutes (non étiquetées), dont les capacités sont générales, et qui peut être adapté à une grande diversité de tâches distinctes (compréhension du langage, génération de textes et d'images, conversation en langage naturel...), notamment après un ajustement (fine-tuning) supplémentaire. Cette flexibilité, combinée à la capacité à apprendre à partir de vastes ensembles de données, le rend particulièrement puissant. Un modèle de fondation peut être adapté à des tâches non génératives, comme la classification, l'analyse, la prédiction, ou à des tâches génératives ; il est donc plus large dans sa conception et son application potentielle qu'un modèle d'IA générative ;

· à l'inverse, un modèle qui est d'emblée spécialisé, sans passer par l'ajustement d'un modèle de fondation, n'est dédié qu'à une seule fonction ou appliqué qu'à un seul domaine. Un modèle spécialisé n'est toutefois pas forcément de petite taille.